a la Finance Université Paris 1 Calcul Stochastique ... - samos-matisse

a la Finance Université Paris 1 Calcul Stochastique ... - samos-matisse

a la Finance Université Paris 1 Calcul Stochastique ... - samos-matisse

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

M2 - Mathématiques Appliquées<br />

à l’Économie et à <strong>la</strong> <strong>Finance</strong><br />

Université <strong>Paris</strong> 1<br />

Spécialité : Modélisation et Méthodes Mathématiques<br />

en Économie et <strong>Finance</strong><br />

<strong>Calcul</strong> <strong>Stochastique</strong> 2<br />

Annie Millet<br />

15<br />

14<br />

13<br />

12<br />

11<br />

10<br />

9<br />

8<br />

7<br />

6<br />

5<br />

4<br />

3<br />

2<br />

1<br />

0<br />

−1<br />

−2<br />

0.0 0.2 0.4 0.6 0.8 1.0 1.2 1.4 1.6 1.8 2.0

Table des matières<br />

1. Processus d’Itô de dimension quelconque . . . . . . . . . . . . . . 1<br />

1.1. Rappels . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1<br />

1.2. Variation quadratique - Crochet d’une martingale locale. . . . . . 4<br />

1.3. Processus d’Itô réel. . . . . . . . . . . . . . . . . . . . . . . . 12<br />

1.4. Processus d’Itô de dimension d - Formule d’Itô générale . . . . . . 13<br />

1.4.1. Processus d’Itô de dimension d . . . . . . . . . . . . . . . . . 13<br />

1.4.2. Formule d’Itô générale . . . . . . . . . . . . . . . . . . . . 15<br />

1.5. Propriétés du Brownien. . . . . . . . . . . . . . . . . . . . . . 17<br />

1.5.1. Caractérisations de Lévy . . . . . . . . . . . . . . . . . . . 17<br />

1.5.2. Propriétés de Markov . . . . . . . . . . . . . . . . . . . . . 19<br />

1.6. Exercices. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22<br />

2. Équations différentielles stochastiques . . . . . . . . . . . . . . 24<br />

2.1. Solution forte - Diffusion. . . . . . . . . . . . . . . . . . . . . 25<br />

2.2. Solution faible.. . . . . . . . . . . . . . . . . . . . . . . . . . 32<br />

2.3. Quelques propriétés des diffusions. . . . . . . . . . . . . . . . . 33<br />

2.3.1. Flot stochastique et Propriété de Markov . . . . . . . . . . . . 33<br />

2.3.2. Générateur infinitésimal . . . . . . . . . . . . . . . . . . . . 35<br />

2.3.3. Théorème de comparaison . . . . . . . . . . . . . . . . . . . 38<br />

2.4. Processus de Bessel . . . . . . . . . . . . . . . . . . . . . . . . 39<br />

2.5. Lien avec les EDP. . . . . . . . . . . . . . . . . . . . . . . . . 40<br />

2.5.1. Problème parabolique . . . . . . . . . . . . . . . . . . . . . 40<br />

2.5.2. Formule de Feynman-Kac . . . . . . . . . . . . . . . . . . . 41<br />

2.6. Exemples en finance. . . . . . . . . . . . . . . . . . . . . . . . 44<br />

2.6.1. Problème de Sturm-Liouville - Temps d’occupation . . . . . . . . 44<br />

2.6.2. Introduction à <strong>la</strong> formule de B<strong>la</strong>ck & Sholes . . . . . . . . . . . 46<br />

2.7. Exercices. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49<br />

3. Théorème de Girsanov . . . . . . . . . . . . . . . . . . . . . . . 54<br />

3.1. Changement de probabilité . . . . . . . . . . . . . . . . . . . . 54<br />

3.2. Formule de Cameron Martin. . . . . . . . . . . . . . . . . . . . 55<br />

3.3. Théorème de Girsanov . . . . . . . . . . . . . . . . . . . . . . 57<br />

3.4. Condition de Novikov et généralisations . . . . . . . . . . . . . . 58<br />

3.5. Existence de solutions faibles . . . . . . . . . . . . . . . . . . . 61<br />

3.6. Exemples d’application à des calculs d’espérance . . . . . . . . . . 62<br />

3.7. Théorème de représentation prévisible . . . . . . . . . . . . . . 64<br />

3.8. Exercices. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 66<br />

4. Applications à <strong>la</strong> finance . . . . . . . . . . . . . . . . . . . . . . 68<br />

4.1. Modélisation d’un marché financier en temps continu . . . . . . . . 68<br />

4.1.1. Modélisation d’un marché à d actifs risqués et k facteurs . . . . . . 68<br />

4.1.2. Description des stratégies . . . . . . . . . . . . . . . . . . . 69

4.1.3. Absence d’opportunité d’arbitrage - Mesure martingale équivalente . . 70<br />

4.1.4. Probabilité risque neutre . . . . . . . . . . . . . . . . . . . . 71<br />

4.2. Modèle de B<strong>la</strong>ck & Sholes généralisé . . . . . . . . . . . . . . . 73<br />

4.2.1. Absence d’opportunité d’arbitrage et changement de probabilité -<br />

Prime de risque . . . . . . . . . . . . . . . . . . . . . . . 73<br />

4.2.2. Complétude du marché . . . . . . . . . . . . . . . . . . . . 76<br />

4.2.3. <strong>Calcul</strong> du portefeuille de couverture dans le modèle de B<strong>la</strong>ck & Sholes 78<br />

4.2.4. Vo<strong>la</strong>tilité . . . . . . . . . . . . . . . . . . . . . . . . . . 81<br />

4.3. Modèle de Cox-Ingersoll-Ross . . . . . . . . . . . . . . . . . . 82<br />

4.3.1. Processus de Bessel généraux . . . . . . . . . . . . . . . . . . 82<br />

4.3.2. Modèle de Cox-Ingersoll-Ross . . . . . . . . . . . . . . . . . 84<br />

4.3.3. <strong>Calcul</strong> du prix d’un zéro-coupon . . . . . . . . . . . . . . . . 85<br />

4.4. Exercices. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 86

1<br />

1 Processus d’Itô de dimension quelconque<br />

Le but de ce chapitre est d’étendre les notions de mouvement Brownien, de processus<br />

d’Itô et <strong>la</strong> formule d’Itô de <strong>la</strong> dimension 1 à une dimension d arbitraire.<br />

1.1 Rappels<br />

Nous rappelons tout d’abord quelques définitions et notations du cours de <strong>Calcul</strong> <strong>Stochastique</strong><br />

1. La filtration donne « l’information » dont on dispose à chaque instant t.<br />

Définition 1.1 Soit (Ω, F, P) un espace probabilisé.<br />

(i) Une filtration est une famille croissante (F t , t ≥ 0) de sous-tribus de F, c’est à dire<br />

telle que F s ⊂ F t ⊂ F si s ≤ t.<br />

(ii) On dit que <strong>la</strong> filtration (F t ) satisfait les conditions usuelles si elle est :<br />

• continue à droite, i.e., F t = F t+ := ⋂ s>t F s.<br />

• complète, i.e., toutes les tribus F t contiennent les ensembles négligeables, ce qui revient<br />

à demander que P(A) = 0 entraîne A ∈ F 0 .<br />

Convention. Dans toute <strong>la</strong> suite on se donne un espace probabilisé filtré (Ω, F, (F t , t ≥<br />

0), P) et on suppose que sa filtration (F t ) satisfait les conditions habituelles. On supposera<br />

de plus que <strong>la</strong> tribu F 0 est <strong>la</strong> complétée de <strong>la</strong> tribu triviale {∅, Ω}, ce qui entraîne que les v.a.<br />

F 0 mesurables sont presque sûrement constantes. Ceci ne sera pas rappelé dans les énoncés.<br />

Définition 1.2 Un processus stochastique (à valeurs dans R d ) est une famille (X t , t ≥ 0)<br />

de variables aléatoires X t : (Ω, F) → (R d , R d ).<br />

(i) Le processus stochastique (X t ) est (F t )-adapté si X t est mesurable de (Ω, F t ) dans<br />

(R d , R d ) pour tout instant t ≥ 0.<br />

(ii) Le processus stochastique (X t ) est progressivement mesurable (ou progressif) si pour<br />

tout instant t ≥ 0, l’application (s, ω) ↦→ X s (ω) est mesurable de B([0, t])⊗F t dans (R d , R d ).<br />

(iii) Soit (X t ) un processus stochastique. Sa filtration naturelle est (F X t , t ≥ 0) où F X t =<br />

σ(σ(X s , s ∈ [0, t]), N) où N désigne les ensembles négligeables. Si le processus (X t ) est<br />

continu à droite, sa filtration naturelle (F X t ) satisfait les conditions habituelles.<br />

Théorème 1.3 Soit (X t ) un processus stochastique à valeurs dans R d , adapté et continu à<br />

droite. Alors (X t ) est progressif.<br />

La notion de temps d’arrêt joue un rôle crucial dans <strong>la</strong> théorie.<br />

Définition 1.4 Une variable aléatoire τ : Ω → [0, +∞] est un temps d’arrêt (re<strong>la</strong>tivement<br />

à <strong>la</strong> filtration (F t )), ou (F t )-temps d’arrêt, si {τ ≤ t} ∈ F t pour tout t ≥ 0. Si τ est un<br />

temps d’arrêt re<strong>la</strong>tivement à (F t ), on note<br />

F τ = {A ∈ F : A ∩ {τ ≤ t} ∈ F t , ∀t ∈ [0, +∞[}.<br />

Enfin si (X t ) est un processus (F t )-adapté, on note X τ (ω) = X τ(ω) (ω); si le processus (X t )<br />

est continu à droite et adapté, X τ 1 {τ

2 1 Processus d’Itô de dimension quelconque<br />

Proposition 1.5 Soit (X t , t ≥ 0) un processus à valeurs dans R d , (F t )-adapté et A ∈ R d .<br />

Rappelons <strong>la</strong> convention inf ∅ = +∞.<br />

(i) Si A est fermé et (X t ) est continu, D A = inf{t ≥ 0 : X t ∈ A} est un (F t )-temps<br />

d’arrêt.<br />

(ii) Si A est un ensemble ouvert et (X t ) est continu à droite, alors le temps d’atteinte<br />

de A noté T A = inf{t > 0 : X t ∈ A} est un (F t +)-temps d’arrêt.<br />

Démonstration. (i) De façon évidente, <strong>la</strong> continuité de X . et le fait que A est fermé entraînent<br />

{D A ≤ t} = {ω : inf s∈Q,s≤t d(X s (ω), A) = 0} ∈ F t , où d(x, A) = inf y∈A d(x, y).<br />

(ii) Pour vérifier {T A ≤ t} ∈ F + t , il suffit de vérifier que {T A < t} ∈ F t pour tout t.<br />

De plus, si s < t et X s (ω) ∈ A, <strong>la</strong> continuité à droite de X . (ω) et le fait que A est ouvert<br />

entraînent qu’il existe ε ∈]0, t − s[ tel que pour tout r ∈ [s, s + ε[, X r (ω) ∈ A, d’où<br />

{T A < t} = ∪ s

1.1 Rappels 3<br />

Démonstration. (i) Pour tout n ≥ 1, soit S n (ω) = k2 −n sur {S ∈ [(k − 1)2 −n , k2 −n [},<br />

k ≤ K2 n + 1 et T n défini de façon simi<strong>la</strong>ire. Alors S n et T n sont des (F t )-temps d’arrêt<br />

qui ne prennent qu’un nombre fini de valeurs et tels que S ≤ S n ≤ T n , lim n S n = S et<br />

lim n T n = T. Si A ∈ F Sn , en découpant l’ensemble A suivant les valeurs prises par S n et en<br />

utilisant <strong>la</strong> propriété de martingale, on voit que ∫ M A S n<br />

dP = ∑ ∫<br />

k<br />

M A∩{S n=k} KdP, c’est à<br />

dire que M Sn = E(M K |F Sn ). Puisque F Sn ⊂ F Tn , on a donc<br />

E(M Tn |F Sn ) = E(E(M K |F Tn )|F Sn ) = M Sn .<br />

On en déduit que pour A ∈ F S ⊂ F Sn , ∫ M A S n<br />

dP = ∫ M A T n<br />

dP. De plus, les suites de<br />

temps d’arrêt (S n , n ≥ 1) et (T n , n ≥ 1) étant décroissantes, le calcul précédent montre que<br />

les suites (M Sn , F Sn ) et (M Tn , F Tn ) sont des martingales descendantes, donc uniformément<br />

intégrables. Puisque <strong>la</strong> martingale M est continue à droite, M T = lim n M Tn et M S =<br />

lim n M Sn p.s. et dans L 1 . On en déduit que pour tout A ∈ F S , ∫ M A SdP = ∫ M A TdP,<br />

ce qui termine <strong>la</strong> démonstration. On remarque que cette démonstration s’étend aisément au<br />

cas où S et T sont des temps d’arrêt non bornés tels que S ≤ T si <strong>la</strong> martingale M est<br />

uniformément intégrable, donc fermée.<br />

(ii) Si s ≤ t, il suffit d’appliquer <strong>la</strong> partie (i) aux temps d’arrêt s ∧ T ≤ t ∧ T ≤ t,<br />

pour déduire que M t∧T est une (F t∧T )-martingale. Montrons que ce processus (F t )-adapté<br />

intégrable est encore une (F t )-martingale.<br />

Soit A ∈ F s . De façon évidente, A ∩ {T > s} ∈ F s∧T , et puisque E(M t∧T |F s∧T ) = M s∧T ,<br />

∫<br />

∫<br />

M t∧T dP = M s∧T dP.<br />

A∩{T>s}<br />

A∩{T>s}<br />

De plus, sur {T ≤ s}, M t∧T = M T = M s∧T ; on en déduit ∫ M A t∧TdP = ∫ M A s∧TdP, ce qui<br />

termine <strong>la</strong> démonstration. ✷<br />

Cette proposition justifie <strong>la</strong> définition suivante qui permet de « localiser » <strong>la</strong> notion de<br />

martingale en introduisant une suite croissante de temps d’arrêt.<br />

Définition 1.8 Un processus (F t )-adapté et continu à droite M est une (F t )-martingale<br />

locale s’il existe une suite croissante (τ n ) de (F t )-temps d’arrêt telle que τ n → ∞ et M τn :=<br />

(M t∧τn , t ≥ 0) est une (F t )-martingale pour tout n.<br />

Remarque 1.9 (1) Soit M une martingale locale. En remp<strong>la</strong>çant <strong>la</strong> suite de temps d’arrêt<br />

(τ n ) par (τ n ∧ n) on voit que l’on peut demander que chaque martingale M τn soit uniformément<br />

intégrable. Pour tout n ≥ 1, soit S n = inf{t ≥ 0 : |M t | ≥ n}. Alors S n est<br />

un temps d’arrêt et si <strong>la</strong> martingale locale M est continue, on peut, en remp<strong>la</strong>çant τ n par<br />

τ n ∧ n ∧ S n , demander que <strong>la</strong> martingale M τn soit bornée.<br />

(2) Même si M est une martingale locale intégrable, ce n’est pas nécessairement une<br />

martingale. On pourra voir un contre-exemple dans [11], page 182.<br />

Définition 1.10 Le processus (B t , t ≥ 0) est un mouvement Brownien (standard) réel - ou<br />

unidimensionnel si les propriétés (a)-(c) sont vérifiées :<br />

a) P(B 0 = 0) = 1 (le mouvement Brownien est issu de l’origine).<br />

b) Pour 0 ≤ s ≤ t, B t − B s est une variable réelle de loi gaussienne, centrée de variance<br />

(t − s), notée N(0, t − s).<br />

c) Pour tout n et 0 ≤ t 0 ≤ t 1 · · · ≤ t n , les variables aléatoires B t0 , B t1 − B t0 , · · · ,<br />

B tn − B tn−1 sont indépendantes.<br />

26 octobre 2009 <strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet

4 1 Processus d’Itô de dimension quelconque<br />

Rappelons que les trajectoires du Brownien B sont p.s. continues, et même Höldériennes<br />

d’ordre α < 1 , mais p.s. qu’elles ne sont pas dérivables (ni même des fonctions de c<strong>la</strong>sse<br />

2<br />

C 2).<br />

1 On supposera souvent que <strong>la</strong> tribu (F t ) considérée est <strong>la</strong> tribu naturelle de B, notée (Ft B ),<br />

et satisfait donc le théorème d’arrêt 1.7. La propriété c) montre que pour tout 0 ≤ s < t,<br />

l’accroissement B t − B s est indépendant de <strong>la</strong> tribu Fs<br />

B = σ(σ(B u , 0 ≤ u ≤ s), N). Le<br />

mouvement Brownien est donc une (Ft B )-martingale. Rappelons des propriétés du Brownien<br />

qui seront d’un usage constant, et pourront être montrées à titre d’exercice.<br />

Proposition 1.11 Soit (B t ) un Brownien. Alors<br />

(i) (Scaling) Pour toute constante c > 0, le processus cB t/c 2 est un mouvement Brownien<br />

et (−B t ) est un mouvement Brownien.<br />

(ii) (Bt 2 − t, t ≥ 0) est (FB t )-martingale.<br />

(iii) Pour tout θ ∈ R, le processus<br />

(<br />

exp<br />

(<br />

θB t − θ2 t<br />

2<br />

) )<br />

, t ≥ 0 est une (Ft B)-martingale.<br />

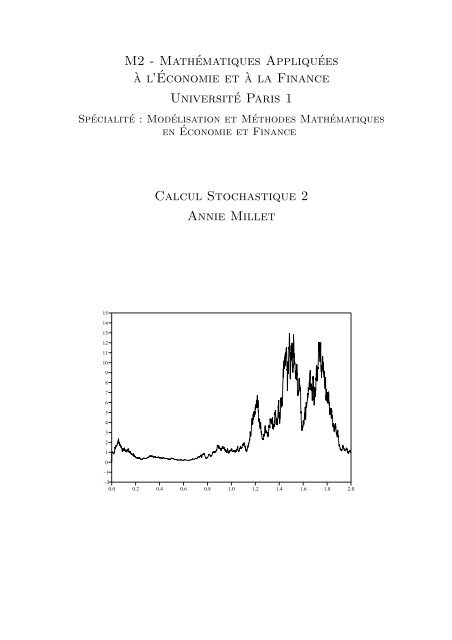

La figure suivante montre trois exemples de trajectoires de B (obtenues par simu<strong>la</strong>tion).<br />

5<br />

4<br />

3<br />

2<br />

1<br />

0<br />

−1<br />

−2<br />

−3<br />

−4<br />

−5<br />

0.0 0.5 1.0 1.5 2.0 2.5 3.0 3.5 4.0 4.5 5.0<br />

1.2 Variation quadratique - Crochet d’une martingale locale<br />

Rappelons les notations suivantes.<br />

Définition 1.12 Soit (Ω, F, (F t , t ≥ 0), P) un espace filtré. Pour a = 1, 2 et T ∈]0, +∞]<br />

on note :<br />

{<br />

(∫ t<br />

) }<br />

H a (F t ) = h progressivement mesurable tel que pour tout t ≥ 0, E |h s | a ds < ∞ ,<br />

{<br />

∫ t<br />

0<br />

}<br />

Ha loc (F t ) = h progressivement mesurable tel que pour tout t ≥ 0, |h s | a ds < ∞ p.s. ,<br />

0<br />

{<br />

(∫ T<br />

) }<br />

Ha T (F t) = h progressivement mesurable tel que E |h s | a ds < +∞ .<br />

0<br />

<strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet 26 octobre 2009

1.2 Variation quadratique - Crochet d’une martingale locale 5<br />

En particulier soit h un processus cad<strong>la</strong>g (F t )-adapté; si pour tout t > 0 on a ∫ t<br />

( 0 h2 s ds <<br />

∫ )<br />

+∞ p.s., alors h ∈ H2 loc t<br />

, si E<br />

0 h2 sds < ∞ pour tout t, alors h ∈ H 2 (F t ), ... Lorsque<br />

<strong>la</strong> filtration (F t ) est <strong>la</strong> filtration naturelle (Ft B ) d’un mouvement Brownien B, on notera<br />

simplement H1 loc := H1 loc (Ft B ), H2 loc := H2 loc (Ft B ), ...<br />

La propriété suivante des intégrales stochastiques par rapport au mouvement Brownien<br />

est fondamentale.<br />

Théorème 1.13 Soit B un mouvement Brownien et (Ft B ) sa filtration naturelle. Soit h ∈<br />

H 2 ; alors le processus t → I t = ∫ t<br />

h 0 sdB s est une (Ft B )-martingale de carré intégrable et à<br />

trajectoires p.s. continues.<br />

Soit h ∈ H2 loc (par exemple un processus cad<strong>la</strong>g, (Ft B)-adapté tel que ∫ t<br />

0 h2 sds < +∞<br />

p.s.) Alors l’intégrale stochastique I t = ∫ t<br />

h 0 sdB s peut être construite comme une martingale<br />

locale continue.<br />

Rappelons <strong>la</strong> notion de variation satisfaite par les intégrales de <strong>la</strong> borne supérieure déterministes.<br />

Définition 1.14 (i) Soit s < t et f : [s, t] → R. La fonction f est à variation bornée sur<br />

[s, t] si V [s,t] (f) < +∞, où<br />

{ }<br />

∑<br />

V [s,t] (f) := sup |f(t i+1 ) − f(t i )| : {s = t 0 < t 1 < · · · < t n ≤ t} subdivision de [s, t] .<br />

i<br />

La fonction f : [0, +∞[ est à variation finie sur [0, +∞[ si elle est à variation bornée sur<br />

tout intervalle [0, T].<br />

(ii) Le processus (X t ) est à variation bornée sur [s, t] (resp. à variation finie) si ses<br />

trajectoires sont p.s. à variation bornée sur [s, t] (resp. p.s. à variation finie).<br />

De façon évidente, si b ∈ H1 loc (F t ), le processus t → I t = ∫ t<br />

b 0 sds est à variation finie; en<br />

effet pour tout T ≥ 0, V [0,T] (I) ≤ ∫ T<br />

|b(t)| dt. Le comportement des intégrales stochastiques<br />

0<br />

est tout autre.<br />

Proposition 1.15 Soit (M t ) une (F t )-martingale locale p.s. continue à variation finie.<br />

Alors pour tout t <strong>la</strong> variable aléatoire M t est presque sûrement constante (égale à M 0 ).<br />

Démonstration. Puisque M 0 est p.s. constante, en remp<strong>la</strong>çant M t par M t − M 0 , on peut<br />

supposer M 0 = 0.<br />

(i) Fixons T et supposons que (M t ) est une martingale continue et que sa variation<br />

V [0,T] (M) est (p.s.) bornée par C. Soit ∆ = {t 0 = 0 < t 1 < · · · < t n = T } une subdivision de<br />

[0, T], |∆| = sup n−1<br />

i=0 |t i+1 − t i | son pas et pour 0 ≤ k ≤ n − 1 soit X k = M tk+1 − M tk . Alors<br />

∑n−1<br />

E(|M T | 2 ) = E(|M T − M 0 | 2 ) = E(Xk) 2 + 2<br />

k=0<br />

∑<br />

1≤i

6 1 Processus d’Itô de dimension quelconque<br />

appliquant le Théorème de convergence dominée, on en déduit E ( sup k |M tk+1 − M tk | ) → 0<br />

quand |∆| → 0. On en déduit E(|M T | 2 ) = 0 ce qui entraîne M T = 0 p.s.<br />

(ii) Supposons que (M t ) est une martingale p.s. continue. Pour tout n, soit<br />

τ n = inf{t ∈ [0, T] : V [0,t] (M) ≥ n} ∧ T<br />

(avec <strong>la</strong> convention inf ∅ = +∞). La définition de V [0,t] montre que c’est un processus (F t )-<br />

adapté, continu. La Proposition 1.5 (i) montre que (τ n ) est une suite de (F t )-temps d’arrêt;<br />

de façon évidente, (τ n ) est croissante et converge vers T. Le théorème d’arrêt 1.7 montre<br />

que le processus (Mt τn<br />

) = (M t∧τn , t ≥ 0) est une (F t )-martingale. De plus, par construction,<br />

V [0,T] (M τn ) ≤ n p.s. Soit t ∈ [0, T]; <strong>la</strong> partie (i) montre donc que M t∧τn = 0 p.s. puis <strong>la</strong><br />

continuité p.s. de M permet, en faisant tendre n vers l’infini, d’en déduire que M t = 0 p.s.<br />

(iii) Soit maintenant M une martingale locale continue et soit (τ n ) une suite de temps<br />

d’arrêt qui croit vers T telle que (M t∧τn , t ≥ 0) est une martingale continue. Pour tout<br />

n cette martingale est à variation bornée sur [0, T] et est donc nulle p.s. d’après (ii). On<br />

conclut de nouveau par passage à <strong>la</strong> limite en n en utilisant <strong>la</strong> continuité p.s. de M. ✷<br />

La proposition précédente montre que le mouvement Brownien n’est p.s. pas à variation<br />

bornée sur [0, T] et que l’intégrale stochastique t → ∫ t<br />

σ 0 sdB s ne peut pas être définie<br />

ω par ω et n’est pas à variation finie, sauf si elle est nulle.<br />

La « bonne notion » pour les intégrales stochastiques, tout comme pour le Brownien, est<br />

celle de variation quadratique. Pour tout processus X défini sur [0, T], 0 ≤ t ≤ T et toute<br />

subdivision ∆ = {t 0 = 0 < t 1 < · · · < t k = T },<br />

∑k−1<br />

Tt ∆ (X) = |X ti+1 ∧t − X ti ∧t| 2 .<br />

i=0<br />

Définition 1.16 Soit X : [0, T]×Ω → R un processus stochastique défini sur [0, T]. On dit<br />

que X est de variation quadratique finie si pour tout t ∈ [0, T],<br />

〈X, X〉 t = lim T t<br />

∆ existe en probabilité,<br />

|∆|→0<br />

c’est à dire que pour toute suite (∆ n ) de subdivisions de [0, T] dont le pas tend vers 0, <strong>la</strong><br />

suite T ∆n<br />

t converge en probabilité vers une limite notée 〈X, X〉 t .<br />

Les deux résultats suivants donnent les rapports entre processus à variation bornée et à<br />

variation quadratique finie.<br />

Proposition 1.17 Soit X un processus continu à variation bornée sur [0, T]. Alors X est<br />

de variation quadratique nulle sur [0, T].<br />

Démonstration. Soit ∆ = {0 = t 0 < t 1 < · · · < t k = T } une subdivision de [0, T]. Alors<br />

∑k−1<br />

∑k−1<br />

|X ti+1 − X ti | 2 ≤ |X ti+1 − X ti | sup |X ti+1 − X ti |.<br />

0≤i

1.2 Variation quadratique - Crochet d’une martingale locale 7<br />

On remarque d’ailleurs que <strong>la</strong> démonstration précédente et le Théorème de convergence<br />

dominée entraînent que si V [0,t] (X) ≤ C p.s. où C est constante, Tt<br />

∆ converge vers 0 dans<br />

L 1 . ✷<br />

Le résultat suivant a été montré dans le cours de <strong>Calcul</strong> <strong>Stochastique</strong> 1.<br />

Théorème 1.18 Le mouvement Brownien (B t ) est de variation quadratique finie sur tout<br />

intervalle [0, T] et 〈B, B〉 t = t. Plus précisément, lorsque |∆| → 0, E(|Tt ∆ (B) − t| 2 ) → 0,<br />

c’est à dire que <strong>la</strong> convergence a lieu dans L 2 .<br />

De plus, si σ ∈ H2 loc,<br />

le processus (∫ t<br />

σ 0 sdB s , t ≥ 0) est de variation quadratique ∫ t<br />

0 σ2 s ds<br />

sur chaque intervalle [0, t].<br />

Nous allons tout d’abord le généraliser à des martingales locales continues.<br />

Notation Soit ∆ = {t 0 = 0 < t 1 < t 2 < · · · } une subdivision de [0, +∞[ telle que pour tout<br />

t > 0, ∆ ∩ [0, t] ne comprend qu’un nombre fini de points. Par analogie avec les notations<br />

précédentes, pour tout t > 0 (en ajoutant t à <strong>la</strong> subdivision) et pour tout processus X<br />

notons<br />

Tt ∆ (X) = ∑ ti+1 ∧t − X ti ∧t)<br />

i≥0(X 2 . (1.2)<br />

Le processus X est à variation quadratique finie si pour tout t <strong>la</strong> famille de processus T ∆<br />

t (X)<br />

converge en probabilité vers 〈X, X〉 t quand le pas |∆| de <strong>la</strong> subdivision sur [0, t] tend vers<br />

0.<br />

Le résultat suivant est fondamental. Il relie <strong>la</strong> variation quadratique à une martingale<br />

associée au carré du processus.<br />

Théorème 1.19 Soit M une (F t )-martingale locale continue. Alors M est de variation quadratique<br />

finie et sa variation quadratique 〈M, M〉 t est l’unique processus croissant, adapté,<br />

continu, nul en zéro tel que<br />

(<br />

M<br />

2<br />

t − 〈M, M〉 t , t ≥ 0 ) est une (F t ) martingale locale .<br />

De plus, ∣ pour s < t et toute∣ suite (∆ n ) de subdivisions dont le pas |∆ n | tend vers 0, <strong>la</strong> suite<br />

sup s≤t Ts<br />

∆n (M) − 〈M, M〉 s converge vers 0 en probabilité.<br />

Si de plus, M est une martingale de carré intégrable (c’est à dire que E(Mt 2 ) < +∞<br />

pour tout t), alors (Mt 2 − 〈M, M〉 t, t ≥ 0) est une (F t ) martingale continue telle que pour<br />

tout couple de temps d’arrêt bornés S ≤ T ≤ C,<br />

E(M 2 T − M 2 S|F S ) = E(|M T − M S | 2 |F S ) = E(〈M, M〉 T − 〈M, M〉 S |F S ).<br />

Démonstration. L’unicité de <strong>la</strong> décomposition découle de <strong>la</strong> Proposition 1.15. En effet,<br />

soit Mt 2 = Y t + A t = Z t + B t où A, B sont des processus continus à variation finie et nuls<br />

en 0, Y, Z sont des martingales locales, continues puisque M. 2 , A . et B . le sont. Alors <strong>la</strong><br />

différence Y − Z = B − A est une martingale locale continue à variation finie nulle en 0,<br />

donc est nulle d’après <strong>la</strong> Proposition 1.15.<br />

Pour prouver l’existence, nous distinguerons plusieurs étapes. Pour alléger les notations,<br />

nous ne ferons pas référence à <strong>la</strong> filtration pour les temps d’arrêt, martingales, ... En remp<strong>la</strong>çant<br />

(M t ) par (M t − M 0 , t ≥ 0) qui est aussi une martingale (ou une martingale locale),<br />

nous supposerons que M 0 = 0.<br />

(1) On suppose que M est une martingale bornée par C. Pour toute subdivision ∆,<br />

s < t, notons i et k les entiers tels que t i ≤ s < t i+1 et t k ≤ t < t k+1 .<br />

26 octobre 2009 <strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet

8 1 Processus d’Itô de dimension quelconque<br />

Alors si i = k, <strong>la</strong> propriété de martingale de M entraîne que<br />

Si i < k,<br />

E ( T ∆<br />

t (M) − T ∆ s (M) ∣ ∣ Fs<br />

)<br />

= E(|Mt − M ti | 2 − |M s − M ti | 2 |F s )<br />

= E(|M t − M s | 2 |F s ) = E(M 2 t − M2 s |F s).<br />

E ( |M ti+1 − M ti | 2 |F s<br />

)<br />

= E<br />

(<br />

|Mti+1 − M s | 2 |F s<br />

)<br />

+ |Ms − M ti | 2 .<br />

Avec <strong>la</strong> convention ∑ n 2<br />

j=n 1<br />

x j = 0 si n 1 > n 2 , on en déduit<br />

E ( T ∆<br />

t (M) − T ∆ s (M) ∣ ∣ Fs<br />

)<br />

= E<br />

(|M ti+1 − M s | 2 +<br />

D’autre part, pour tout s ≤ a < b ≤ c < d ≤ t,<br />

∑k−1<br />

j=i+1<br />

|M tj+1 − M tj | 2 + |M t − M tk | 2 ∣ ∣∣Fs<br />

).<br />

E[(M b − M a )(M d − M c )|F s ] = E[(M b − M a )E[M d − M c |F c ]|F s ] = 0.<br />

En décomposant M t − M s comme somme d’accroissements sur les points {s, t i+1 , · · · , t k , t}<br />

on obtient donc<br />

E ( |M t − M s | 2 |F s<br />

)<br />

= E<br />

(|M ti+1 − M s | 2 +<br />

∑k−1<br />

j=i+1<br />

|M tj+1 − M tj | 2 + |M t − M tk | 2 ∣ ∣∣Fs<br />

),<br />

On en déduit que<br />

E [ Mt 2 − M2 s |F ] [ ] [<br />

s = E (Mt − M s ) 2 |F s = E T<br />

∆<br />

t (M) − Ts ∆ (M)|F s]<br />

. (1.3)<br />

Le processus (Mt 2 −T t ∆ (M), t ≥ 0) est donc une martingale de carré intégrable et E(Mt 2) =<br />

E(Tt ∆ (M)) pour tout t ≥ 0.<br />

(2) Soit M une martingale continue bornée par C. Fixons a en notons (∆ n ) une suite<br />

de subdivisions de [0, a] dont le pas tend vers 0. Montrons que <strong>la</strong> suite (Ta ∆n (M), n ≥ 0)<br />

converge dans L 2 , c’est à dire est de Cauchy dans L 2 .<br />

Soit ∆ et ∆ ′ deux subdivisions; notons ˜∆ <strong>la</strong> subdivision obtenue en prenant l’union des<br />

points de ∆ et ∆ ′ . Notons<br />

X = T ∆ (M) − T ∆′ (M).<br />

Puisque (Mt 2 − T t ∆ (M) , t ≥ 0) est une martingale, X est également une martingale nulle<br />

en 0 telle que (X t , 0 ≤ t ≤ a) est bornée. Le calcul précédent appliqué à X au lieu de M<br />

montre que<br />

[<br />

] [ ]<br />

E(Xa 2 ) = E |Ta ∆ ∆′<br />

(M) − Ta (M)|2 = E T ˜∆<br />

a (X) .<br />

[<br />

De plus, T ˜∆<br />

a (X) ≤ 2 T ˜∆ (<br />

a T ∆ (M) ) + T ˜∆ (<br />

a T<br />

∆ ′ (M) )] .<br />

Pour vérifier que <strong>la</strong> suite Ta<br />

∆n (M) est de Cauchy, il suffit donc de vérifier que<br />

[<br />

E T ˜∆ (<br />

a T ∆ (M)) )] converge vers 0 quand |∆| + |∆ ′ | → 0.<br />

Soit s k ∈ ˜∆ et t l l’unique élément de ∆ tel que t l ≤ s k < s k+1 ≤ t l+1 . Alors<br />

T ∆ s k+1<br />

(M) −T ∆ s k<br />

(M) = (M sk+1 −M tl ) 2 −(M sk −M tl ) 2 = (M sk+1 −M sk )(M sk+1 +M sk −2M tl ).<br />

<strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet 26 octobre 2009

1.2 Variation quadratique - Crochet d’une martingale locale 9<br />

On en déduit<br />

T ˜∆<br />

a<br />

(<br />

T ∆ (M) ) ≤ T ˜∆<br />

a (M)<br />

(<br />

)<br />

sup |M sk+1 + M sk − 2M tl | 2 .<br />

k<br />

Puisque M est continue bornée, le théorème de convergence dominée entraîne que<br />

(<br />

)<br />

E sup |M sk+1 + M sk − 2M tl | 4 → 0 quand |∆| + |∆ ′ | → 0.<br />

k<br />

Il suffit d’après l’inégalité de Schwarz de prouver que E(|T ˜∆<br />

a (M)| 2 ) reste bornée par une<br />

constante, c’est à dire que<br />

sup E(|Ta ∆ (M)|2 ) < +∞.<br />

∆<br />

Soit ∆ une subdivision qui contient a = t n . Alors<br />

( n−1<br />

) 2<br />

∑<br />

|Ta ∆ (M)|2 = |M ti+1 − M ti | 2<br />

i=0<br />

∑n−1<br />

∑n−2<br />

∑n−1<br />

= |M ti+1 − M ti | 4 + 2 |M ti+1 − M ti | 2<br />

i=0<br />

i=0<br />

i=0<br />

i=0<br />

j=i+1<br />

|M tj+1 − M tj | 2<br />

∑n−1<br />

∑n−2<br />

( )<br />

= |M ti+1 − M ti | 4 2 (<br />

+ 2 Mti+1 − M ti T<br />

∆<br />

a (M) − Tt ∆<br />

i+1<br />

(M) ) .<br />

L’équation (1.3) montre que E [ T ∆ a (M)−T ∆<br />

t i+1<br />

(M)|F ti+1<br />

]<br />

= E<br />

[<br />

(Ma −M ti+1 ) 2 |F ti+1<br />

]<br />

. Puisque<br />

(M ti+1 − M ti ) 2 est F ti+1 -mesurable, on en déduit<br />

∑n−1<br />

E(|Ta ∆ (M)|2 ) = E(|M ti+1 − M ti | 4 )<br />

i=0<br />

n−1<br />

∑<br />

+ 2<br />

i=0<br />

n−1<br />

E [ |M ti+1 − M ti | 2 E ( T ∆ a (M) − T ∆<br />

t i+1<br />

(M)|F ti+1<br />

)]<br />

∑<br />

∑n−1<br />

= E(|M ti+1 − M ti | 4 ) + 2 E [ |M ti+1 − M ti | 2 (M a − M ti+1 ) 2]<br />

i=0<br />

[(<br />

≤ E<br />

sup<br />

k<br />

i=0<br />

) ]<br />

|M tk+1 − M tk | 2 + 2 sup |M a − M tk | 2 Ta ∆ (M) .<br />

k<br />

Puisque sup t |M t | ≤ C et M 0 = 0, l’équation (1.3) pour 0 et a entraîne que E(T ∆ a (M)) ≤ C 2<br />

et donc<br />

E(|T ∆ a (M)|2 ) ≤ 12C 2 E(T ∆ a (M)) ≤ 12C4 . (1.4)<br />

La suite (Ta<br />

∆n (M), n ≥ 1) est donc de Cauchy dans L 2 ; elle converge dans L 2 (donc aussi<br />

en probabilité) vers une limite notée 〈M, M〉 a .<br />

(3) Soit M une martingale continue bornée par C. Il reste à vérifier que le processus<br />

〈M, M〉 a les propriétés annoncées. Soit (∆ n ) une suite de subdivisions dont le pas |∆ n | tend<br />

26 octobre 2009 <strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet

10 1 Processus d’Itô de dimension quelconque<br />

vers 0. Pour tout m < n, le processus T ∆n (M) − T ∆m (M) est une martingale et l’inégalité<br />

de Doob entraîne que<br />

(<br />

) [<br />

E |Ts<br />

∆n<br />

(M) − Ts ∆m<br />

(M)| 2 ≤ 4E |Ta<br />

∆n<br />

(M) − Ta ∆m<br />

(M)| 2] .<br />

sup<br />

0≤s≤a<br />

Soit m(k) un entier tel que pour tout m ≥ m(k), E(|Ts<br />

∆m (M)−T ∆ m(k)<br />

s (M)| 2 ) ≤ 2 −k . On peut<br />

supposer que <strong>la</strong> suite m(k) est strictement croissante et, d’après le lemme de Borel Cantelli,<br />

de <strong>la</strong> suite (T. ∆n (M), n ≥ 1) on peut donc extraire une sous-suite (T ∆ m(k)<br />

. (M), k ≥ 1) qui<br />

converge p.s. uniformément sur l’intervalle [0, a].<br />

Par un procédé diagonal, on peut faire en sorte d’extraire une nouvelle sous-suite qui<br />

converge uniformément sur tout intervalle [0, N] pour tout entier N. La limite 〈M, M〉 est<br />

donc p.s. continue. De plus, <strong>la</strong> limite étant indépendante de <strong>la</strong> suite de subdivisions choisie,<br />

on peut faire en sorte que <strong>la</strong> suite de subdivisions soit telle que ∆ n ⊂ ∆ n+1 et que ∪ n ∆ n<br />

soit dense dans [0, +∞[.<br />

Alors, si s < t sont des points de ∪ n ∆ n , il existe n 0 tel que s, t ∈ ∆ n pour tout n ≥ n 0 . On<br />

en déduit alors de façon évidente que Ts<br />

∆n ≤ Tt<br />

∆n<br />

pour n ≥ n 0 , d’où 〈M, M〉 s ≤ 〈M, M〉 t et<br />

que le processus 〈M, M〉 est croissant par continuité. Enfin, en faisant tendre n vers l’infini<br />

dans l’équation (1.3) écrite pour <strong>la</strong> subdivision ∆ n et en utilisant l’intégrabilité uniforme<br />

de <strong>la</strong> suite (Tt<br />

∆n<br />

(M), n ≥ 1) qui découle du fait que cette suite est bornée dans L 2 d’après<br />

(1.4), on déduit que M 2 − 〈M, M〉 est une martingale.<br />

(4) Soit M une martingale locale continue et (T n ) une suite de temps d’arrêt qui croît<br />

p.s. vers +∞ et telle que pour tout n le processus X(n) = M Tn défini par (1.1) est une<br />

martingale continue bornée. La démonstration précédente montre qu’il existe un processus<br />

croissant A(n) nul en 0 tel que pour tout n, (X(n) 2 t − A(n) t , t ≥ 0) est une martingale. De<br />

plus <strong>la</strong> martingale arrêtée<br />

(X(n + 1) 2 − A(n + 1)) Tn = X(n) 2 − A(n + 1) Tn<br />

est une martingale et A(n + 1) Tn est un processus croissant nul en 0. L’unicité montrée en<br />

(1) permet de déduire que A(n + 1) Tn = A(n) Tn p.s. Ceci permet de définir sans ambiguïté<br />

un processus croissant 〈M, M〉 t = A(n) t pour tout t ≤ T n . L’unicité vient de l’unicité sur<br />

tout intervalle [0, T n ].<br />

Fixons t > 0, ε > 0 et δ > 0. La suite de temps d’arrêt (T n ) tend vers +∞, donc pour n<br />

assez grand S = T n est tel que P(S ≤ t) < δ et <strong>la</strong> martingale M S est bornée. La première<br />

partie montre que lorsque le pas de <strong>la</strong> subdivision |∆| tend vers 0, Tt ∆(MS<br />

) converge vers<br />

〈M S , M S 〉 t en probabilité. Puisque Ts ∆ (M S ) = Ts ∆ (M) et 〈M S , M S 〉 s = 〈M, M〉 s pour<br />

s ∈ [0, S], on en déduit que pour |∆| assez petit<br />

(<br />

) (<br />

)<br />

P sup |Ts ∆ (M) − 〈M, M〉 s| ≥ ε ≤ δ + P sup |Ts ∆ (MS ) − 〈M S , M S 〉 s | ≥ ε ≤ 2δ.<br />

s≤t<br />

s≤t<br />

(5) Supposons enfin que M est une martingale est de carré intégrable. D’après l’inégalité<br />

de Doob,<br />

E( sup |M s | 2 ) ≤ 2E(|M t | 2 ).<br />

0≤s≤t<br />

D’autre part, soit (T n ) une suite de temps d’arrêt qui croît p.s. vers +∞ et telle que pour tout<br />

n le processus X n = M Tn est une martingale continue bornée. Pour tout t, E(〈M, M〉 t∧Tn ) =<br />

<strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet 26 octobre 2009

1.2 Variation quadratique - Crochet d’une martingale locale 11<br />

E(|M t∧Tn | 2 ) et <strong>la</strong> suite (M t∧Tn , n ≥ 0) est une (F t∧Tn , n ≥ 0) martingale bornée dans L 2 qui<br />

converge dans L 2 vers M 2 t . De plus, le théorème de convergence monotone montre que<br />

E(〈M, M〉 t ) = lim<br />

n<br />

E(〈M, M〉 t∧Tn ) = lim<br />

n<br />

E(|M t∧Tn | 2 ).<br />

Enfin <strong>la</strong> martingale discrète (M t∧Tn , n ≥ 1) est fermée par M t ∈ L 2 et converge dans L 2 vers<br />

M t puisque ∨ n F t∧Tn = F t ; on a donc E(〈M, M〉 t ) = E(Mt 2 ) < +∞. L’inégalité de Doob<br />

montre alors que pour tout s ≤ t,<br />

Ms 2 − 〈M, M〉 s ≤ sup Mr 2 + 〈M, M〉 r ∈ L 1 .<br />

r≤t<br />

L’exercice 1.4 (ii) montre que cette martingale locale continue uniformément intégrable est<br />

une martingale. Il suffit d’appliquer le Théorème d’arrêt 1.7 pour conclure <strong>la</strong> démonstration.<br />

✷<br />

Le crochet de deux martingales locales continues M et N est défini par po<strong>la</strong>risation.<br />

Théorème 1.20 Soit M et N des (F t )-martingales locales continues. Il existe un unique<br />

processus continu, adapté, à variation finie 〈M, N〉 nul en 0 tel que (M t N t − 〈M, N〉 t , t ≥ 0)<br />

soit une martingale locale continue. De plus pour toute suite ∆ n de subdivisions de [0, t] dont<br />

le pas tend vers 0, <strong>la</strong> suite<br />

∣<br />

sup<br />

s≤t<br />

∣ ∑<br />

∣∣∣∣ (M ti+1 ∧s − M ti ∧s)(N ti+1 ∧s − N ti ∧s) − 〈M, N〉 s converge vers 0 en probabilité.<br />

∣<br />

t i ∈∆ n<br />

Démonstration. L’unicité découle de <strong>la</strong> proposition 1.15. Pour l’existence, il suffit de vérifier<br />

que<br />

〈M, N〉 = 1 [<br />

]<br />

〈M + N , M + N〉 − 〈M − N , M − N〉 .<br />

4<br />

a les propriétés annoncées. C’est <strong>la</strong> différence de deux processus croissants et c’est donc un<br />

processus à variation finie. ✷<br />

Définition 1.21 On dit que le processus 〈M, N〉 est le crochet de M et N et que le processus<br />

〈M, M〉 aussi noté 〈M〉 est le processus croissant associé à M.<br />

Définition 1.22 Un processus X est une semi-martingale continue s’il admet <strong>la</strong> décomposition<br />

X t = X 0 +M t +A t pour tout t, où (M t ) est une (F t )-martingale locale continue, (A t )<br />

est un processus continu à variation finie, M 0 = A 0 = 0.<br />

On déduit aisément <strong>la</strong><br />

Proposition 1.23 La variation quadratique d’une semi-martingale continue X = X 0 +M+<br />

A est finie et égale 〈M, M〉. La décomposition de X est unique (à indistinguabilité près).<br />

On note donc 〈X, X〉 = 〈M, M〉 et on dit que ce processus croissant est le crochet de X. De<br />

même, si X = X 0 + M + A et Y = Y 0 + N + B sont des semi-martingales continues (avec<br />

les martingales locales continues M, N et les processus à variation finie A et B) on définit<br />

le crochet de X et Y comme<br />

〈X, Y 〉 = 〈M, N〉 = 1 [<br />

]<br />

〈X + Y , X + Y 〉 − 〈X − Y , X − Y 〉 .<br />

4<br />

26 octobre 2009 <strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet

12 1 Processus d’Itô de dimension quelconque<br />

Démonstration. Soit X = X 0 + M + A une semi-martingale continue. Si X admet une<br />

autre décomposition X = ¯X 0 + ¯M + Ā où Ā est un processus à variation finie, ¯M est une<br />

martingale locale continue, ¯M0 = Ā0 = 0, on a ¯X 0 = X 0 , le processus M − ¯M = Ā − A est<br />

une martingale locale continue à variation finie, est est donc nulle p.s. d’après <strong>la</strong> Proposition<br />

1.15.<br />

Soit ∆ une subdivision de [0, t]. D’après <strong>la</strong> Proposition 1.17 le processus A est à variation<br />

quadratique nulle et pour prouver que <strong>la</strong> variation quadratique de X est celle de M, il suffit<br />

de vérifier que<br />

∑<br />

(<br />

)<br />

(M<br />

∣<br />

ti+1 − M ti )(A ti+1 − A ti )<br />

∣ ≤ sup |M ti+1 − M ti | V ar [0,t] (A).<br />

i<br />

Puisque les trajectoires de M sont p. s. continues (donc uniformément continues sur [0, t])<br />

et que V ar [0,t] (A) < +∞ on déduit que p.s., le majorant tend vers 0 quand |∆| → 0. ✷<br />

1.3 Processus d’Itô réel.<br />

Définition 1.24 Soit (B t ) un mouvement Brownien, (Ft B ) sa filtration naturelle, x ∈ R,<br />

b ∈ H1 loc(FB<br />

t ) et σ ∈ Hloc 2 (FB t ). Le processus X défini par<br />

X t = x +<br />

∫ t<br />

0<br />

i<br />

σ s dB s +<br />

∫ t<br />

0<br />

b s ds (1.5)<br />

est un processus d’Itô; il est à trajectoires continues. Le processus b est sa dérive, le processus<br />

σ est le coefficient de diffusion et x est <strong>la</strong> condition initiale. L’équation (1.5) est souvent<br />

également notée { dXt = b t dt + σ t dB t ,<br />

(1.6)<br />

X 0 = x.<br />

Le Théorème 1.13 montre que M t = ∫ t<br />

σ 0 sdB s est une (Ft B )-martingale locale continue.<br />

Un processus d’Itô X t = x + ∫ t<br />

σ 0 sdB s + ∫ t<br />

b 0 sds est donc une semi-martingale locale continue.<br />

On dit que t → ∫ t<br />

σ 0 sdB s est sa « partie martingale » (même si c’est seulement une<br />

martingale locale) et que t → x + ∫ t<br />

b 0 sds est sa « partie à variation finie ». La partie martingale(<br />

de X est une « vraie » (Ft B )-martingale si le coefficient de diffusion σ est cad<strong>la</strong>g tel<br />

∫ )<br />

t<br />

que E < +∞ pour tout t > 0, ou plus généralement si σ ∈ H 2 (Ft B ). C’est une<br />

0 σ2 sds<br />

martingale bornée dans L 2 si σ ∈ H ∞ 2 (F 2 t ).<br />

Les résultats de <strong>la</strong> section précédente donnent donc immédiatement quelques propriétés<br />

importantes des processus d’Itô.<br />

Corol<strong>la</strong>ire 1.25 (i) Le crochet d’un processus d’Itô X t = x + ∫ t<br />

σ 0 sdB s + ∫ t<br />

b 0 sds est défini<br />

par 〈X, X〉 t = ∫ t<br />

0 σ2 sds pour tout t ≥ 0.<br />

(ii) Plus généralement, le crochet croisé de deux processus d’Itô X t = x + ∫ t<br />

σ 0 sdB s +<br />

∫ t<br />

b 0 sds et Y t = y + ∫ t<br />

¯σ 0 sdB s + ∫ t ¯b 0 s ds est celui de leurs parties martingales, soit 〈X, Y 〉 t =<br />

∫ t<br />

σ 0 s¯σ s ds.<br />

(iii) Soit (X t = x + ∫ t<br />

σ 0 sdB s + ∫ t<br />

b 0 sds = ˜x + ∫ t<br />

˜σ 0 sdB s + ∫ t ˜b 0 s ds, t ≥ 0) un processus<br />

d’Itô, où b,˜b ∈ H1 loc (Ft B ), σ, ˜σ ∈ H2 loc (Ft B ), x, ˜x ∈ R. Alors, x = ˜x, b = ˜b ds ⊗ dP p.p. et<br />

σ = ˜σ ds ⊗ dP p.p., c’est à dire que <strong>la</strong> décomposition de X est unique.<br />

<strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet 26 octobre 2009

1.4 Processus d’Itô de dimension d - Formule d’Itô générale 13<br />

(iv) Soit (X t ) un processus d’Itô qui est une (Ft B<br />

est nulle ds ⊗ dP p.p.<br />

)-martingale locale. Alors sa dérive b<br />

Démonstration. (i) et (ii) sont des conséquences immédiates de <strong>la</strong> Proposition 1.17, du<br />

Théorème 1.18 et de <strong>la</strong> po<strong>la</strong>risation.<br />

(iii) La différence D t = ∫ t<br />

(˜b 0 s − b s )ds = ∫ t<br />

(σ 0 s − ˜σ s )dB s est dont un processus à variation<br />

bornée sur [0, T] (à cause de l’intégrale déterministe) et une martingale locale continue (à<br />

cause de l’intégrale stochastique et du Théorème 1.13). La Proposition 1.17 montre que <strong>la</strong><br />

variation quadratique de l’intégrale stochastique de σ − ˜σ est nulle p.s. sur tout intervalle<br />

[0, t], soit ∫ t<br />

|σ 0 s − ˜σ s | 2 ds = 0, et σ = ˜σ ds ⊗ dP p.p. sur [0, t] × Ω. On en déduit que<br />

∫ t<br />

(b 0 s − ˜b s )ds = 0 pour tout t, ce qui termine <strong>la</strong> démonstration puisque X 0 = x = ˜x.<br />

(iv) Le processus d’Itô X t = x+ ∫ t<br />

σ 0 sdB s + ∫ t<br />

b 0 sds est continu. Puisque t → x+ ∫ t<br />

σ 0 sdB s<br />

est une (Ft B )-martingale locale continue, par différence le processus t → ∫ t<br />

b 0 sds est une<br />

martingale locale continue et est à variation finie sur tout intervalle [0, t]. Il est donc constant<br />

(et égal à 0) p.s. d’après <strong>la</strong> Proposition 1.15 ✷<br />

1.4 Processus d’Itô de dimension d - Formule d’Itô générale<br />

1.4.1 Processus d’Itô de dimension d<br />

Nous étendons tout d’abord <strong>la</strong> définition du mouvement Brownien réel au cas d’un<br />

processus de dimension quelconque.<br />

Définition 1.26 Soit ( B t = (B 1 t , B 2 t , . . .,B r t ), t ≥ 0 ) un processus r-dimensionnel et (F t )<br />

une filtration. On dit que B est un (F t )-Brownien standard r-dimensionnel si les processus<br />

(B i ), 1 ≤ i ≤ r sont des (F t )-Browniens réels indépendants, c’est à dire : B 0 = 0 et pour<br />

0 ≤ s ≤ t<br />

(i) B t − B s suit une loi normale N(0, (t − s)Id r ).<br />

(ii) l’accroissement B t − B s est indépendant de <strong>la</strong> tribu F s .<br />

Quand <strong>la</strong> filtration n’est pas précisée, on dit que B est un Brownien standard d-dimensionnel<br />

si c’est un mouvement Brownien pour sa filtration naturelle (F B t ). Si B est un Brownien<br />

standard pour <strong>la</strong> filtration (F t ), c’est aussi un Brownien standard pour sa filtration naturelle<br />

(F B t ). Le Brownien est un processus gaussien à accroissements indépendants.<br />

Nous commettrons l’abus de notation consistant à identifier un vecteur (x 1 , · · · , x r ) ∈ R r et<br />

<strong>la</strong> matrice colonne de ses composantes dans <strong>la</strong> base canonique. Nous noterons donc<br />

⎛ ⎞<br />

B t =<br />

⎜<br />

⎝<br />

B 1 t<br />

.<br />

B r t<br />

⎟<br />

⎠ .<br />

Nous généralisons de même <strong>la</strong> notion de processus d’Itô. Notons M(d, r) l’ensemble des<br />

matrices d × r à d lignes et r colonnes. On dit qu’un processus X = (Xj(t) i : 1 ≤ i ≤ d, 1 ≤<br />

j ≤ r, t ≥ 0) à valeurs dans M(d, k) appartient à H1 loc(F<br />

t) (resp. H2 loc(F<br />

t), H2 2(F t), H2 ∞(F t))<br />

si chaque composante Xk i est un processus réel qui appartient à Hloc 1 (F t ) (resp. H2 loc (F t ),<br />

H2 2(F t), H2 ∞(F t)).<br />

26 octobre 2009 <strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet

14 1 Processus d’Itô de dimension quelconque<br />

Définition 1.27 Soit B un (F t )-Brownien standard de dimension r, σ = (σk i : 1 ≤ i ≤<br />

d, 1 ≤ k ≤ r) : Ω × [0, +∞[→ M(d, r) ∈ H2 loc , b = (b 1 , · · · , b d ) : Ω × [0, +∞[→ R d ∈ H1 loc ,<br />

et x = (x 1 , · · · , x d ) ∈ R d . Le processus (X t ) à valeurs dans R d est un processus d’Itô de<br />

condition initiale x, de coefficient de diffusion σ et de coefficient de dérive b si pour tout<br />

i = 1, · · · , d,<br />

r∑<br />

∫ t ∫ t<br />

Xt i = xi + σk i (s)dBk s + b i (s)ds. (1.7)<br />

k=1<br />

0<br />

En notation matricielle, si on commet l’abus de notation qui consiste à identifier un vecteur<br />

x = (x 1 , · · · , x d ) de R d et <strong>la</strong> matrice colonne de ses coefficients dans <strong>la</strong> base canonique,<br />

l’équation (1.7) peut s’écrire<br />

0<br />

où on note<br />

⎛<br />

X t =<br />

⎜<br />

⎝<br />

X 1 t<br />

.<br />

X d t<br />

⎞<br />

⎛<br />

⎟ ⎜<br />

⎠ , x = ⎝<br />

X t = x +<br />

∫ t<br />

0<br />

σ(s)dB s +<br />

∫ t<br />

⎞ ⎛<br />

x 1<br />

σ1(s) 1 · · ·<br />

⎟ ⎜<br />

. ⎠ , σ(s) = ⎝ . .<br />

x d σ1 d(d) · · ·<br />

0<br />

b(s)ds,<br />

⎞ ⎛ ⎞<br />

σr(s)<br />

1 b 1 (s)<br />

⎟ ⎜ ⎟<br />

. ⎠ , b(s) = ⎝ . ⎠ .<br />

σd r (s) b d (s)<br />

Considérons les processus d’Itô unidimensionnels<br />

ξ t = x +<br />

r∑<br />

k=1<br />

∫ t<br />

0<br />

σ k (s)dB k s +<br />

∫ t<br />

0<br />

b(s)ds et ¯ξt = ¯x +<br />

r∑<br />

¯σ j (s)dBs k +<br />

k=1<br />

∫ t<br />

0<br />

¯b(s)ds,<br />

pour b,¯b ∈ H1 loc et σ k , ¯σ k ∈ H2 loc.<br />

Alors le processus ∫ t<br />

b(s)ds est continu à variation finie,<br />

0<br />

tandis que le processus ∑ r<br />

∫ t<br />

k=1<br />

σ 0 k(s)dBs k est une martingale locale continue comme somme<br />

de martingales locales continues. Les processus ξ et ¯ξ sont donc des semi-martingales. Pour<br />

trouver leurs ( crochets, on remarque tout d’abord que pour chaque indice k = 1, · · · , r, le<br />

∣∣∣ ∫ t<br />

processus σ 0 k(s)dBs<br />

k ∣ 2 − ∫ )<br />

t<br />

|σ 0 k(s)| 2 ds , t ≥ 0 est une (F t )-martingale locale.<br />

Soit k ≠ l ; supposons d’abord que les processus σ k et σ l sont étagés, c’est à dire<br />

∑n−1<br />

σ k = ξk i 1 ]t i ,t i+1 ] et σ l =<br />

i=0<br />

n∑<br />

ξl i 1 ]t i ,t i+1 ], t 0 = 0 < t 1 < · · · et ξk i , ξj l<br />

F ti -mesurables.<br />

i=1<br />

Soit s < t; sans perte de généralité, on peut supposer que les instants s et t sont ajoutés à<br />

<strong>la</strong> liste des t i , avec s = t I et t = t n . Alors,<br />

(∫ t<br />

E σ k (u)dBu<br />

k<br />

0<br />

∫ t<br />

0<br />

)<br />

σ l (u)dBu<br />

l ∣<br />

∑n−1<br />

∑n−1<br />

(<br />

)<br />

∣F s = E ξk i ξ j l [Bk t i+1<br />

− Bt k i<br />

][Bt l j+1<br />

− Bt l ∣<br />

j<br />

] ∣F s<br />

=<br />

i=0 j=0<br />

∫ s<br />

0<br />

σ k (u)dB k u<br />

∫ s<br />

0<br />

σ l (u)dB l u.<br />

En effet l’indépendance de F ti , B k t i+1<br />

− B k t i<br />

et B l t i+1<br />

− B l t i<br />

, entraîne par exemple que :<br />

si I ≤ i = j, puisque E[(B k t i+1<br />

−B k t i<br />

)(B l t i+1<br />

−B l t i<br />

)|F ti ) = E[(B k t i+1<br />

−B k t i<br />

)(B l t i+1<br />

−B l t i<br />

)] = 0,<br />

on en déduit E(ξ i k ξi l E[(Bk t i+1<br />

− B k t i<br />

)(B l t i+1<br />

− B l t i<br />

)|F ti ) ∣ ∣ FtI ) = 0.<br />

<strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet 26 octobre 2009

1.4 Processus d’Itô de dimension d - Formule d’Itô générale 15<br />

L’indépendance de (B l t j+1<br />

− B l t j<br />

et de F tj entraîne :<br />

si i < I ≤ j, ξ i k (Bk t i+1<br />

− B k t i<br />

)E(ξ j l E(Bl t j+1<br />

− B l t j<br />

|F tj )|F tI ) = 0,<br />

si I ≤ i < j, E(ξk i(Bk t i+1<br />

− Bt k i<br />

)ξ j l E(Bl t j+1<br />

− Bt l j<br />

|F tj ) ∣ FtI ) = 0,<br />

Cette propriété s’étend ensuite à des processus σ k et σ l de H2(F 2 t ) pour lesquels on déduit<br />

que<br />

(∣ ∣∣<br />

r∑<br />

∫ t<br />

σ k (s)dBs<br />

k r∑<br />

∫<br />

∣ 2 t<br />

)<br />

− |σ k (s)| 2 ds , t ≥ 0<br />

k=1<br />

0<br />

k=1<br />

est une (F t )-martingale. Par localisation, on montre enfin que ce processus est une (F t )-<br />

martingale locale si on sait seulement que les processus σ k , 1 ≤ k ≤ r appartiennent à<br />

H2 loc (F t ).<br />

Le crochet des processus ξ et ¯ξ est donc celui de leurs parties martingales<br />

m t = ∑ r<br />

∫ t<br />

k=1<br />

σ 0 k(s)dBs k, et ¯m t = ∑ r<br />

∫ t<br />

k=1 ¯σ 0 k(s)dBs k soit<br />

∫<br />

〈ξ , ¯ξ〉<br />

t r∑<br />

t = 〈m, ¯m〉 t = σ k (s)¯σ k (s)ds.<br />

Le crochet de <strong>la</strong> martingale locale m est égal à celui de ξ, soit<br />

〈ξ , ξ〉 t = 〈m, m〉 t =<br />

∫ t<br />

0<br />

0<br />

0<br />

k=1<br />

r∑<br />

|σ k (s)| 2 ds =<br />

k=1<br />

∫ t<br />

0<br />

‖σ(s)‖ 2 ds,<br />

où ‖σ(s)‖ désigne <strong>la</strong> norme euclidienne dans R r du vecteur (σ 1 (s), · · · , σ r (s)).<br />

1.4.2 Formule d’Itô générale<br />

Les résultats de <strong>la</strong> section précédente sont résumés dans <strong>la</strong><br />

Proposition 1.28 Soit (B t ) un (F t )-Brownien standard à valeurs dans R r , (X t ) un processus<br />

d’Itô à valeurs dans R d de <strong>la</strong> forme (1.7). Alors X est à trajectoires continues. Pour<br />

chaque i = 1, · · · , d, le processus ( ∫ t<br />

0 bi (s)ds, t ≥ 0) est continu à variation finie (c’est à dire<br />

que chacune de ses composantes est à variation finie), nul en 0. Le processus ∫ t<br />

σ(s)dB 0 s est<br />

une martingale locale continue (c’est à dire que chacune de ses composantes est une martingale<br />

locale continue) nulle en 0. La décomposition est unique. Le crochet des composantes<br />

X i et X j , 1 ≤ i, j ≤ d est<br />

〈X i , X j 〉 t =<br />

∫ t<br />

0<br />

r∑<br />

σk i (s)σj k (s)ds.<br />

k=1<br />

La formule d’Itô, montrée pour un processus d’Itô réel dans le cours de <strong>Calcul</strong> <strong>Stochastique</strong><br />

1, se généralise immédiatement à des processus d’Itô multidimensionnels. Rappelons<br />

<strong>la</strong> tout d’abord en dimension 1 sous sa forme <strong>la</strong> plus simple.<br />

Théorème 1.29 Soit X t = x+ ∫ t<br />

σ(s)dB 0 s+ ∫ t<br />

b(s)ds, où x ∈ R, (B 0 t) est un (F t )-Brownien,<br />

b ∈ H1 loc , σ ∈ H2 loc . Soit f : R → R une fonction de c<strong>la</strong>sse C 2 . Alors pour tout t ≥ 0,<br />

f(X t ) = f(x) +<br />

= f(x) +<br />

∫ t<br />

0<br />

∫ t<br />

0<br />

f ′ (X s )dX s + 1 2 f ′′ (X s )d〈X, X〉 s (1.8)<br />

∫ t<br />

[<br />

f ′ (X s )σ(s)dB s + f ′ (X s )b(X s ) + 1 ]<br />

2 f ′′ (X s )σ 2 (s) ds.<br />

0<br />

26 octobre 2009 <strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet

16 1 Processus d’Itô de dimension quelconque<br />

On peut donc formellement poser<br />

df(X t ) = f ′ (X t )dX t + 1 2 f ′′ (X t )d〈X, X〉 t où 〈X, X〉 t =<br />

∫ t<br />

0<br />

σ 2 (s)ds.<br />

La formule d’Itô admet <strong>la</strong> version suivante en dimension quelconque, dont <strong>la</strong> démonstration<br />

simi<strong>la</strong>ire à celle en dimension 1, est omise. Notons A ∗ <strong>la</strong> transposée de <strong>la</strong> matrice<br />

A.<br />

Théorème 1.30 Soit B un (F t )-Brownien standard de dimension r, σ un processus à valeurs<br />

dans M(d, r) qui appartient à H2 loc (F t ), b un processus à valeurs dans R d qui appartient<br />

à H1 loc(F<br />

t) et x ∈ R d . Notons X t = x + ∫ t<br />

σ(s)dB 0 s + ∫ t<br />

b 0 sds le processus d’Itô défini par<br />

les équations (1.7) pour tout i = 1, · · · , d et soit f : R d → R une fonction de c<strong>la</strong>sse C 2 .<br />

Alors si on note a(s) = σ(s)σ(s) ∗ <strong>la</strong> matrice d × d définie par a i,j (s) = ∑ r<br />

k=1 σi k (s)σj k (s)<br />

pour i, j ∈ {1, · · · , d}, on a :<br />

∫ t d∑ ∂f<br />

f(X t ) = f(x) + (X s )dXs i + 1 ∫ t d∑ ∂ 2 f<br />

(X s )d〈X i , X j 〉 s (1.9)<br />

∂x i 2 ∂x i ∂x j<br />

= f(x) +<br />

∫ t<br />

0<br />

∫ t<br />

0<br />

i=1<br />

k∑<br />

j=1<br />

d∑<br />

i=1<br />

0<br />

i,j=1<br />

∫<br />

∂f<br />

t<br />

(X s )σ i<br />

∂x<br />

jdBs j +<br />

i 0<br />

d∑<br />

i=1<br />

∂f<br />

∂x i<br />

(X s )b i (s)ds<br />

+ 1 d∑ ∂ 2 f<br />

(X s )a i,j (s)ds. (1.10)<br />

2 0 ∂x<br />

i,j=1 i ∂x j<br />

(<br />

)<br />

Notons ∂2 f<br />

∂<br />

<strong>la</strong> matrice carrée symétrique<br />

2 f<br />

∂x 2 ∂x i ∂x j<br />

, 1 ≤ i, j ≤ d , (, ) le produit sca<strong>la</strong>ire<br />

dans R d et ∂f<br />

∂f<br />

<strong>la</strong> matrice colonne dont les composantes sont les dérivées partielles<br />

∂x ∂x i<br />

. On<br />

peut alors écrire formellement <strong>la</strong> formule d’Itô<br />

( ) ∂f<br />

df(X t ) =<br />

∂x (X t), dX t + 1 (<br />

)<br />

2 Trace σ(t)σ ∗ (t) ∂2 f<br />

∂x (X t) dt.<br />

2<br />

Si <strong>la</strong> fonction f dépend aussi du temps, on a <strong>la</strong> seconde version de <strong>la</strong> formule d’Itô.<br />

Théorème 1.31 Soit B un (F t )-Brownien standard de dimension r, σ un processus à valeurs<br />

dans M(d, r) qui appartient à H2 loc(F<br />

t), b un processus à valeurs dans R d qui appartient<br />

à H1 loc (F t ) et x ∈ R d . Notons X t = x + ∫ t<br />

σ(s)dB 0 s + ∫ t<br />

b 0 sds le processus d’Itô défini par les<br />

équations (1.7) pour tout i = 1, · · · , d et soit f : [0, +∞[×R d → R une fonction de c<strong>la</strong>sse<br />

C 1,2 , c’est à dire de c<strong>la</strong>sse C 1 par rapport à <strong>la</strong> première variable t et de c<strong>la</strong>sse C 2 par rapport<br />

à <strong>la</strong> seconde variable x. Alors si a(s) = σ(s)σ(s) ∗ , on a :<br />

∫ t ∫<br />

∂f<br />

t d∑<br />

f(t, X t ) = f(0, x) +<br />

∂t (s, X ∂f<br />

s)ds + (s, X s )dXs<br />

i ∂x i<br />

+ 1 2<br />

∫ t<br />

0<br />

= f(0, x) +<br />

+<br />

∫ t<br />

0<br />

d∑<br />

0<br />

i,j=1<br />

∫ t<br />

0<br />

0<br />

i=1<br />

∂ 2 f<br />

∂x i ∂x j<br />

(s, X s )d〈X i , X j 〉 s ds (1.11)<br />

r∑<br />

k=1<br />

d∑<br />

i=1<br />

[<br />

∂f<br />

∂t (s, X s) +<br />

∂f<br />

∂x i<br />

(s, X s )σ i k (s)dBk s<br />

d∑<br />

i=1<br />

∂f<br />

∂x i<br />

(s, X s )b i (s) + 1 2<br />

d∑<br />

i,j=1<br />

]<br />

∂ 2 f<br />

(s, X s )a i,j (s) ds.<br />

∂x i ∂x j<br />

<strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet 26 octobre 2009

1.5 Propriétés du Brownien. 17<br />

De nouveau, l’équation (1.11) peut s’écrire de façon compacte sous <strong>la</strong> forme<br />

df(t, X t ) = ∂f ( )<br />

∂f<br />

∂t (t, X t)dt +<br />

∂x (t, X t), dX t + 1 (<br />

)<br />

2 Trace σ(t)σ ∗ (t) ∂2 f<br />

∂x (t, X t)<br />

2<br />

dt.<br />

Un cas particulier très simple de cette formule est le résultat suivant qui est une « formule<br />

d’intégration par parties » . On <strong>la</strong> montrera comme exercice.<br />

Si f : [0, +∞[→ R est de c<strong>la</strong>sse C 1 et (B t ) est un Brownien standard unidimensionnel,<br />

∫ t<br />

0<br />

f(s)dB s = f(t)B t −<br />

∫ t<br />

0<br />

B s f ′ (s)ds.<br />

La formule d’Itô permet de montrer que si B est un Brownien standard( unidimensionnel ∫ )<br />

et si X est un processus (Ft B)-adapté, p ∈ [1+∞[ et T > 0 sont tels que E T<br />

|X 0 s| 2p ds <<br />

+∞, alors ( ∣∣∣∣ ∫ T<br />

∣ ) ∣∣∣<br />

2p (∫ T<br />

)<br />

E X s dB s ≤ [p(2p − 1)] p T p−1 E |X s | 2p ds (1.12)<br />

0<br />

On pourra montrer cette inégalité très utile dans l’exercice 1.8. Le résultat suivant renforce<br />

<strong>la</strong> conclusion. L’une des inégalités est montrée dans l’exercice 1.8.<br />

Théorème 1.32 (Théorème de Burkholder-Davies-Gundy) Pour tout p ∈ [1, +∞[ il existe<br />

des constantes universelles k p > 0 et K p > 0 (qui ne dépendent que de p) telles que toute<br />

(F t )- martingale continue M de carré intégrable et pour tout T > 0,<br />

( )<br />

k p E (〈M〉 p T ) ≤ E sup |M s | 2p ≤ K p E (〈M〉 p T ) . (1.13)<br />

1.5 Propriétés du Brownien.<br />

1.5.1 Caractérisations de Lévy<br />

0≤s≤T<br />

Remarquons que si B est un Brownien standard d-dimensionnel, pour tout i, j = 1, · · · , d<br />

les processus (B i t , t ≥ 0) et (Bi t Bj t − δ i,j t , t ≥ 0) sont des (F B t )-martingales (avec δ i,j = 0<br />

pour i ≠ j et δ i,i = 1). La démonstration est faite dans l’exercice 1.7 Nous allons montrer<br />

que ces propriétés caractérisent le Brownien, ce qui sera fondamental pour traiter des changements<br />

de probabilité. Notons (u, v) le produit sca<strong>la</strong>ire des vecteurs u, v ∈ R d et ‖u‖ <strong>la</strong><br />

norme euclidienne de u,<br />

Théorème 1.33 (Caractérisation de Paul Lévy) Soit X = (X t = (Xt 1, · · · , Xd t ), t ≥ 0) un<br />

processus (F t )-adapté à valeurs dans R d .<br />

(i) On suppose pour tout u ∈ R d , les processus X et t ↦→ exp [(u, X t ) − ‖u‖ 2 t/2] sont des<br />

(F t )-martingales. Alors, X est un (F t )-Brownien standard de dimension d.<br />

(ii) On suppose que le processus défini pour j = 1, · · · , d par M j t = X j t − X j 0 est une<br />

(F t )-martingale locale continue nulle en 0 (M0 i = 0 pour tout i) et que les crochets de M i<br />

et M j sont<br />

〈M i M j 〉 t = δ i,j t. (1.14)<br />

Alors M est un (F t )-Brownien standard de dimension d.<br />

0<br />

26 octobre 2009 <strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet

18 1 Processus d’Itô de dimension quelconque<br />

Démonstration. (i) Il faut montrer que pour 0 ≤ s < t, le vecteur aléatoire X t − X s suit<br />

une loi N(0, (t − s)Id) et est indépendant de F s .<br />

Soit Z un vecteur gaussien de loi N(0, (t − s)Id). Puisque <strong>la</strong> fonction caractéristique<br />

caractérise <strong>la</strong> loi, il suffit de vérifier que pour tout u ∈ R d<br />

) )<br />

E<br />

(e i(u,Xt−Xs) |F s = E<br />

(e i(u,Z) = e − ‖u‖2 (t−s)<br />

2 . (1.15)<br />

En effet, supposons que (1.15) est vraie et notons Φ(x) = e i(u,x) ; pour tout A ∈ F s<br />

on a E[1 A Φ(X t − X s )] = P(A)E[Φ(Z)]. On en déduit que pour toute fonction borélienne<br />

bornée f : R d → R et tout A ∈ F s , on a E [ 1 A f(X t − X s ) ] = P(A)E[f(Z)]. Ceci prouve<br />

l’indépendance de X t − X s de <strong>la</strong> tribu F s et montre également que <strong>la</strong> loi de X t − X s est<br />

égale à celle de Z.<br />

Pour prouver (1.15), fixons tout d’abord v ∈ R d . Par hypothèse, si 0 ≤ s < t,<br />

E [ exp ( (X t − X s , v) ) (<br />

]<br />

| F s = exp −(X s , v) + ‖v‖2 t<br />

2<br />

( ‖v‖ 2 (t − s)<br />

= exp<br />

2<br />

)<br />

.<br />

)<br />

E<br />

[<br />

exp<br />

(<br />

(X t , v) − ‖v‖2 t<br />

2<br />

) ∣∣∣<br />

Fs<br />

]<br />

Un argument de récurrence finie (reposant sur le caractère analytique des deux membres de<br />

(1.15) comme fonction de l’une de variables v k ∈ C, les autres composantes de v étant fixées<br />

dans R ou C) montre que l’équation précédente s’étend du cas v ∈ R d au cas v ∈ C d . Cette<br />

égalité appliquée au vecteur v dont les composantes sont v k = iu k montre (1.15).<br />

(ii) Nous ne montrerons cette caractérisation que dans le cas où (X t ) est un processus<br />

d’Itô, c’est à dire X t = X 0 + ∫ t<br />

H(s)dB 0 s avec H ∈ H2 loc . Le cas général nécessite une notion<br />

d’intégrale stochastique plus générale que celle par rapport au Brownien présentée en <strong>Calcul</strong><br />

<strong>Stochastique</strong> 1. Pour tout j = 1, · · · , d et t > 0, le crochet de X j à l’instant t est donné par<br />

〈X j , X j 〉 t = t = ∑ r<br />

∫ t<br />

k=1 0 |Hj k (s)|2 ds, ce qui entraîne que ∑ r<br />

k=1 |Hj k (s)|2 = 1 p.s. pour presque<br />

tout s. De plus, si j ≠ l, pour tout t > 0, le crochet 〈X j , X l 〉 t = ∫ t ∑ r<br />

0 k=1 Hj k (s)Hl k (s) ds = 0,<br />

ce qui entraîne que ∑ r<br />

k=1 Hj k (s)Hl k (s) = 0 p.s. pour presque tout s. On en déduit que H ∈ H2 2<br />

et que (X t , 0 ≤ t ≤ T) est une martingale. De plus, les égalités précédentes montrent que<br />

les vecteurs (H j (s), 1 ≤ j ≤ d) forment une famille orthonormée (donc libre) de R r , ce<br />

qui entraîne d ≤ r. Pour tout A ∈ F s et λ ∈ R d , soit f(t) = E<br />

(<br />

1 A exp [i(λ, M t − M s )]<br />

D’après <strong>la</strong> partie (i), il suffit de montrer que f(t) = P(A) exp [ − ‖λ2 ‖<br />

(t −s)] . En appliquant<br />

2<br />

<strong>la</strong> formule d’Itô séparément ( à <strong>la</strong> partie réelle et à <strong>la</strong> partie imaginaire de <strong>la</strong> fonction x =<br />

(x 1 , · · ·x d ) → exp i ∑ d<br />

j=1 λj x<br />

), j on déduit que pour s < t,<br />

ce qui entraîne<br />

e i(λ,Mt)<br />

e i(λ,Mt−Ms) = 1 + i<br />

d∑<br />

j=1 k=1<br />

= e i(λ,Ms) + i<br />

−<br />

d∑<br />

j,l=1 k=1<br />

d∑<br />

j=1 k=1<br />

∫ t<br />

r∑ λ j λ l<br />

2<br />

r∑<br />

∫ t<br />

λ j e i(λ,Mu) H j k (u)dBk u<br />

r∑<br />

∫ t<br />

λ j e i(λ,Mu−Ms) H j k (u)dBk u −<br />

s<br />

s<br />

s<br />

e i(λ,Mu) H j k (s)Hl k (u)du,<br />

d∑ |λ j | 2<br />

j=1<br />

2<br />

∫ t<br />

s<br />

e i(λ,Mu−Ms) du.<br />

)<br />

.<br />

<strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet 26 octobre 2009

1.5 Propriétés du Brownien. 19<br />

Les intégrales stochastiques ( ∫ t<br />

s ei(λ,Mu−Ms) H j k (u)dBk u , t ≥ s) sont des martingales pour tout<br />

j = 1, · · · , d et k = 1, · · · , r, et sont indépendantes de F s . En utilisant le théorème de Fubini,<br />

on en déduit<br />

( ∫ t<br />

) ∫ t<br />

f(t) = P(A) − ‖λ‖2<br />

2 E 1 A e i(λ,Mu−Ms) du = P(A) − ‖λ‖2 f(u)du.<br />

2<br />

s<br />

Puisque f ′ (t) = − ‖λ‖2 f(t) pour t ≥ s et que f(s) = P(A), nous avons établi que pour tout<br />

2<br />

t ≥ s, f(t) = P(A) exp(− ‖λ2 ‖<br />

(t − s)). ✷<br />

2<br />

1.5.2 Propriétés de Markov<br />

Une propriété fondamentale du Brownien est <strong>la</strong> propriété de Markov, qui traduit le fait<br />

que ce qui se passe après l’instant t (c’est à dire dans le futur à l’instant t) ne dépend pas<br />

de toute <strong>la</strong> tribu F t des évènements du « passé » , mais seulement de l’état B t à l’instant t.<br />

Décrivons tout d’abord le passage d’un instant s à un instant t ≥ s.<br />

Définition 1.34 Une probabilité de transition sur R d est une application Π : R d × R d →<br />

[0, 1] telle que<br />

(i) pour tout x ∈ R d , l’application A ∈ R d → Π(x, A) est une probabilité.<br />

(ii) pour tout A ∈ R d , x ∈ R d → Π(x, A) est mesurable de (R d , R d ) dans ([0, 1], B([0, 1]).<br />

Une fonction de transition sur R d est une famille (P s,t , 0 ≤ s < t) de probabilités de transition<br />

telle que si s < t < v l’équation de Chapman-Kolmogorov soit satisfaite :<br />

∫<br />

P s,t (x, dy)P t,v (y, A) = P s,v (x, A) , ∀A ∈ R d , ∀x ∈ R d . (1.16)<br />

Pour toute fonction f : R d → R borélienne positive (ou bornée) on note<br />

∫<br />

P s,t f(x) = f(y) P s,t (x, dy).<br />

R d<br />

Si <strong>la</strong> fonction de transition P s,t ne dépend que de t − s, on dit qu’elle homogène et dans ce<br />

cas, si on note P t = P 0,t , l’équation (1.16) s’écrit<br />

∫<br />

P s+t (x, A) = P s (x, dy)P t (y, A).<br />

Pour toute fonction f : R d → R borélienne positive (ou bornée), on a P s+t f(x) = P t<br />

(<br />

Ps f(x) )<br />

et on dit que (P t ) est un semi-groupe.<br />

L’équation (1.16) est naturelle. En effet, si X est un processus et (x, A) ∈ R d × R d →<br />

P s,t (x, A) est une probabilité de transition tels que pour tout A ∈ R d et s < t,<br />

∫<br />

P(X t ∈ A|σ(X u , u ≤ s)) = P s,t (X s , A) = 1 A (y) P s,t (x, dy) p.s.,<br />

on en déduit E(f(X t )|σ(X u , u ≤ s)) = ∫ R d f(y)P s,t (X s , dy) pour toute fonction borélienne<br />

f : R d → R positive (ou bornée). Pour s < t < v, A ∈ R d et f(y) = P t,v (y, A), on en déduit<br />

P s,v (X s , A) = P(X v ∈ A|σ(X u , u ≤ s))<br />

= E [ P(X v ∈ A|σ(X u , u ≤ t) | σ(X u , u ≤ s) ]<br />

= E [ f(X t )|σ(X u , u ≤ s) ] ∫<br />

= P s,t (X s , dy)P t,v (y, A).<br />

Ces notions permettent de formuler précisément <strong>la</strong> propriété de Markov « faible ».<br />

s<br />

26 octobre 2009 <strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet

20 1 Processus d’Itô de dimension quelconque<br />

Définition 1.35 (1) Un processus (X t , t ≥ 0) à valeurs dans R d et adapté à <strong>la</strong> filtration<br />

(F t ) est un processus de Markov pour cette filtration si pour toute fonction borélienne bornée<br />

f : R d → R,<br />

E ( f(X t ) | F s ) = E ( f(X t ) | X s ) pour tout s ≤ t. (1.17)<br />

(2) Un processus (X t , t ≥ 0) à valeurs dans R d et adapté à <strong>la</strong> filtration (F t ) est un processus<br />

de Markov pour cette filtration de fonction de transition P s,t si pour toute fonction borélienne<br />

bornée f : R d → R,<br />

E [ ∫<br />

]<br />

f(X t ) | F s = Ps,t f(X s ) := P s,t (X s , dy)f(y). (1.18)<br />

R d<br />

On dit que le processus de Markov est homogène si sa fonction de transition est homogène.<br />

Nous allons montrer que le mouvement Brownien est un processus de Markov homogène<br />

de semi-groupe de transition P h défini pour s ≥ 0, h > 0, x ∈ R d et A ∈ R d par :<br />

∫<br />

)<br />

1<br />

‖y − x‖2<br />

P h (x, A) = P(B s+h ∈ A|B s = x) = exp<br />

(− dy,<br />

(2πh) d 2 A 2h<br />

c’est à dire que P h (x, dy) est <strong>la</strong> loi d’un vecteur gaussien N(x, hId).<br />

Théorème 1.36 (Propriété de Markov simple) Soit (B t ) un mouvement Brownien standard<br />

d-dimensionnel et f : R d → R une fonction borélienne bornée. Alors pour tout s ≤ t,<br />

∫<br />

E[f(B t ) | Fs B ] = E[f(B 1<br />

t) | B s ] =<br />

f(y) exp<br />

(− ‖y − B )<br />

s‖ 2<br />

dy.<br />

(2π(t − s)) d 2 R 2(t − s)<br />

d<br />

Démonstration. La démonstration repose sur le lemme suivant :<br />

Lemme 1.37 Soit F une tribu et G une sous-tribu de F, X : (Ω, G) → (E 1 , E 1 ) une<br />

application G-mesurable et Y : (Ω, F) → (E 2 , E 2 ) une application F-mesurable indépendante<br />

de G. Alors, pour toute fonction Φ : (E 1 × E 2 , E 1 ⊗ E 2 ) → (R, R) bornée,<br />

E(Φ(X, Y )|G) = ϕ(X), où ϕ : (E 1 , E 1 ) → (R, R) est définie par ϕ(x) = E[Φ(x, Y )].<br />

Démonstration du Lemme Pour toute application mesurable V : (Ω, F) → (E, E),<br />

notons P (V ) <strong>la</strong> mesure image de P par V . D’après <strong>la</strong> définition de P (Y ) et le Théorème de<br />

Fubini, ϕ est telle que ϕ(x) = ∫ E 2<br />

Φ(x, y)dP (Y ) (y) et est bornée, mesurable de (E 1 , E 1 ) dans<br />

(R, R). De plus, si Z : (Ω, G) → (R, R) est G-mesurable bornée, l’indépendance de Y et<br />

(X, Z) et le théorème de Fubini entraînent<br />

E [ Φ(X, Y )Z ] ∫ ∫<br />

= Φ(x, y) z dP (X,Z) (x, z) dP (Y ) (y)<br />

∫ (∫<br />

)<br />

= Φ(x, y)dP (Y ) (dy) z dP (X,Z) (x, z)<br />

∫<br />

= ϕ(x) zdP (X,Z) (x, z) = E [ ϕ(X)Z ] ,<br />

ce qui termine <strong>la</strong> démonstration.<br />

✷<br />

<strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet 26 octobre 2009

1.5 Propriétés du Brownien. 21<br />

Soit s < t; appliquons le lemme précédent avec E 1 = E 2 = R d , G = F s , F = F t , X = B s<br />

et Y = B t − B s . Nous en déduisons que pour toute fonction borélienne bornée f : R d → R,<br />

E [ ]<br />

f(B t )|F s = ϕ(Bs ) où ϕ(x) = E [ f(x + B t − B s ) ] . Un calcul simi<strong>la</strong>ire avec G = σ(B s ) et<br />

F = F t pour les mêmes variables aléatoires X = B s et Y = B t − B s permet de conclure<br />

E [ ]<br />

f(B t )|B s = ϕ(Bs ). La loi de B t − B s étant gaussienne N(0, (t − s)Id), ceci termine <strong>la</strong><br />

démonstration. ✷<br />

Corol<strong>la</strong>ire 1.38 Soit τ un (F t )-temps d’arrêt fini presque sûrement et B un (F t )-Brownien<br />

standard de dimension d. Alors le processus (M t = B τ+t − B τ , t ≥ 0) est un (F τ+t , t ≥ 0)-<br />

Brownien standard indépendant de F τ .<br />

Démonstration. Supposons tout d’abord que τ ≤ C p.s. et notons G t = F τ+t pour tout<br />

t ≥ 0. Alors (G t ) est une filtration et le Théorème d’arrêt 1.7 montre que si (X t ) est une<br />

(F t )-martingale et si on note Y t = X τ+t , Y t est intégrable et pour s < t, E(Y t |G s ) =<br />

E(X τ+t |F τ+s ) = X τ+s = Y s , c’est à dire que (Y t ) est une (G t )-martingale.<br />

Il faut montrer que si 0 ≤ s < t, le vecteur aléatoire M t − M s suit une loi N(0, (t −<br />

s)Id) et est indépendant de G s . Un argument utilisé dans <strong>la</strong> démonstration du théorème<br />

de caractérisation du Brownien de Paul Lévy montre qu’il suffit de vérifier que pour tout<br />

u ∈ R d l’équation (1.15) est satisfaite.<br />

Fixons u ∈ R d et notons f(x) = e i(u,x) pour tout x ∈ R d . Alors |f| = 1 et en décomposant<br />

f en partie réelle et partie imaginaire, <strong>la</strong> propriété de Markov et <strong>la</strong> définition du Brownien<br />

montrent<br />

)<br />

(t − s)‖u‖2<br />

E(exp(i(u, B t )|F s ) = E(exp(i(u, B t )|B s ) = exp(i(u, B s )) exp<br />

(− .<br />

2<br />

On en déduit que le processus X t = exp ( i(u, B t ) + t‖u‖ 2 /2) est une (F t )-martingale, et<br />

d’après <strong>la</strong> remarque précédente, que (Y t = X τ+t , t ≥ 0) est une (G t )-martingale. Pour tout<br />

s ≤ t, on a donc<br />

(<br />

Yt<br />

∣ )<br />

∣∣Gs<br />

E = E(Y t|G s )<br />

= Y s<br />

,<br />

Y 0 Y 0 Y 0<br />

ce qui prouve que ( Y t<br />

Y 0<br />

= exp(i(u, M t ) + t‖u‖ 2 /2), t ≥ 0 ) est une (G t )-martingale. Donc pour<br />

s ≤ t,<br />

∣ ) (<br />

)<br />

E<br />

(e i(u,Mt−Ms) ∣∣Gs<br />

t‖u‖2<br />

i(u,Mt)+ ∣<br />

t‖u‖2<br />

−i(u,Ms)−<br />

= E e 2<br />

∣G s e 2 = e −(t−s)‖u‖2 2 ,<br />

ce qui termine <strong>la</strong> démonstration de (1.15) lorsque τ est borné p.s.<br />

Soit τ un temps d’arrêt presque sûrement fini; pour conclure, il suffit d’écrire (1.15) pour<br />

<strong>la</strong> suite de temps d’arrêt τ ∧ n et de faire tendre n vers +∞. ✷.<br />

On en déduit une propriété simi<strong>la</strong>ire à <strong>la</strong> propriété de Markov simple (Théorème 1.36)<br />

en remp<strong>la</strong>çant les temps fixes par des temps d’arrêt.<br />

Théorème 1.39 (Propriété de Markov forte) Soit B un (F t )-Brownien standard à valeurs<br />

dans R d et τ un (Ft B )-temps d’arrêt fini presque sûrement; alors pour tout t > 0,<br />

∫<br />

1<br />

E[f(B τ+t ) | F τ ] = E[f(B τ+t ) | B τ ] = f(y) exp<br />

(− ‖y − B )<br />

τ‖ 2<br />

dy. (1.19)<br />

(2πt) d 2 R 2t<br />

d<br />

Démonstration. Le lemme 1.37 appliqué à X = B τ , Y = B τ+t − B τ , G = F τ (ou bien<br />

G = σ(X τ )), F = F t+τ et le Corol<strong>la</strong>ire 1.38 montrent que, puisque (B τ+t −B τ , t ≥ 0) est un<br />

Brownien indépendant de F τ , <strong>la</strong> propriété de Markov forte (1.19) est satisfaite. ✷<br />

26 octobre 2009 <strong>Calcul</strong> <strong>Stochastique</strong> 2 - Annie Millet

22 1 Processus d’Itô de dimension quelconque<br />

1.6 Exercices<br />

Exercice 1.1 Montrer qu’une martingale locale M arrêtée est encore une martingale locale.<br />

Exercice 1.2 Soit (M t ) un processus cad<strong>la</strong>g (F t )-adapté. Montrer que c’est une (F t )-<br />

martingale si et seulement si pour tout temps d’arrêt borné T, M T ∈ L 1 et E(M T ) = E(M 0 ).<br />

Exercice 1.3 Soit (X t , 0 ≤ t ≤ T) une (F t )-surmartingale, c’est à dire que si 0 ≤ s ≤ t ≤ T,<br />

X s ≥ E(X t |F s ), telle que E(X T ) = E(X 0 ). Montrer que (X t ) est une martingale.<br />