CeBIT 2002 – Qualität statt Quantität - Midrange Magazin

CeBIT 2002 – Qualität statt Quantität - Midrange Magazin

CeBIT 2002 – Qualität statt Quantität - Midrange Magazin

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

Titelthema<br />

10 www.midrangemagazin.de Mai <strong>2002</strong><br />

Datenintegration<br />

Lösung für Datenaustausch und Data Warehouse-Umgebungen<br />

„Wissen ist Macht“: Nie war dieser Satz<br />

gültiger als heute, da Unternehmen mehr und<br />

mehr den Wert von Informationen <strong>–</strong> sowohl<br />

diejenigen in den Köpfen der Mitarbeiter als<br />

auch die im Netzwerk befindlichen <strong>–</strong> für ihren<br />

erfolgreichen Fortbestand erkannt haben.<br />

Unternehmensrelevante Informationen bilden<br />

die Grundlage für alle wichtige Entscheidungen<br />

und werden heute mit moderner Data<br />

Warehouse-Technologie geschaffen. Es handelt<br />

sich nicht mehr nur um die Auswertungssysteme<br />

mit Standardberichten, sondern um<br />

weiterentwickelte, flexible, visuelle und<br />

benutzerfreundliche Systeme für eine effiziente<br />

Entscheidungsvorbereitung.<br />

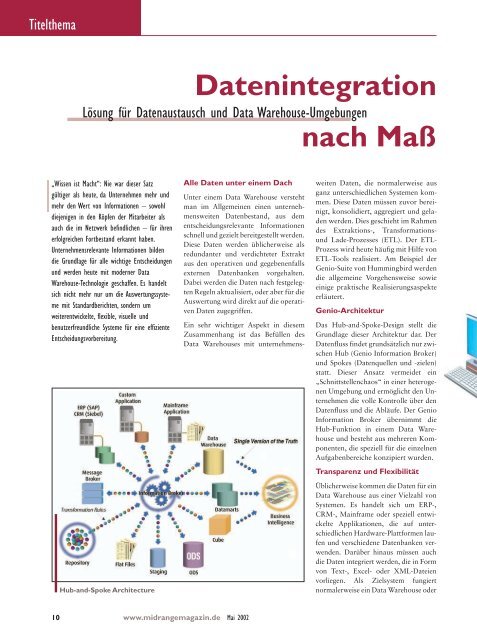

Hub-and-Spoke Architecture<br />

Alle Daten unter einem Dach<br />

Unter einem Data Warehouse versteht<br />

man im Allgemeinen einen unternehmensweiten<br />

Datenbestand, aus dem<br />

entscheidungsrelevante Informationen<br />

schnell und gezielt bereitgestellt werden.<br />

Diese Daten werden üblicherweise als<br />

redundanter und verdichteter Extrakt<br />

aus den operativen und gegebenenfalls<br />

externen Datenbanken vorgehalten.<br />

Dabei werden die Daten nach festgelegten<br />

Regeln aktualisiert, oder aber für die<br />

Auswertung wird direkt auf die operativen<br />

Daten zugegriffen.<br />

Ein sehr wichtiger Aspekt in diesem<br />

Zusammenhang ist das Befüllen des<br />

Data Warehouses mit unternehmens-<br />

nach Maß<br />

weiten Daten, die normalerweise aus<br />

ganz unterschiedlichen Systemen kommen.<br />

Diese Daten müssen zuvor bereinigt,<br />

konsolidiert, aggregiert und geladen<br />

werden. Dies geschieht im Rahmen<br />

des Extraktions-, Transformationsund<br />

Lade-Prozesses (ETL). Der ETL-<br />

Prozess wird heute häufig mit Hilfe von<br />

ETL-Tools realisiert. Am Beispiel der<br />

Genio-Suite von Hummingbird werden<br />

die allgemeine Vorgehensweise sowie<br />

einige praktische Realisierungsaspekte<br />

erläutert.<br />

Genio-Architektur<br />

Das Hub-and-Spoke-Design stellt die<br />

Grundlage dieser Architektur dar. Der<br />

Datenfluss findet grundsätzlich nur zwischen<br />

Hub (Genio Information Broker)<br />

und Spokes (Datenquellen und -zielen)<br />

<strong>statt</strong>. Dieser Ansatz vermeidet ein<br />

„Schnittstellenchaos“ in einer heterogenen<br />

Umgebung und ermöglicht den Unternehmen<br />

die volle Kontrolle über den<br />

Datenfluss und die Abläufe. Der Genio<br />

Information Broker übernimmt die<br />

Hub-Funktion in einem Data Warehouse<br />

und besteht aus mehreren Komponenten,<br />

die speziell für die einzelnen<br />

Aufgabenbereiche konzipiert wurden.<br />

Transparenz und Flexibilität<br />

Üblicherweise kommen die Daten für ein<br />

Data Warehouse aus einer Vielzahl von<br />

Systemen. Es handelt sich um ERP-,<br />

CRM-, Mainframe oder speziell entwickelte<br />

Applikationen, die auf unterschiedlichen<br />

Hardware-Plattformen laufen<br />

und verschiedene Datenbanken verwenden.<br />

Darüber hinaus müssen auch<br />

die Daten integriert werden, die in Form<br />

von Text-, Excel- oder XML-Dateien<br />

vorliegen. Als Zielsystem fungiert<br />

normalerweise ein Data Warehouse oder