w26M2

w26M2

w26M2

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

Aufgaben durch die Verwendung von verschachtelten<br />

HiveQL-Unterabfragen oder durch temporäre Zwischentabellen<br />

gelöst werden müssen. Das trägt nicht gerade zur<br />

Klarheit bei und kann zu Performance-Fallen führen.<br />

Werkzeugunterstützung für die Joberstellung<br />

Es ist zu berücksichtigen, dass man bei wachsenden Integrationsprojekten<br />

mit manuellem »Hand-coding« ohne<br />

Werkzeugunterstützung, wie z. B. einem Team-Repository,<br />

regelmäßig an organisatorische Effizienzgrenzen stößt.<br />

Integrationswerkzeuge (z. B. ETL, ESB) unterstützen hierbei<br />

typischerweise in den Projektphasen Design, Dokumentation,<br />

Deployment, Betrieb und Monitoring. Mittlerweile<br />

bieten eigentlich alle Integrationssoftware-Hersteller<br />

zumindest Konnektoren für persistente Big-Data-Datenhaltungssysteme<br />

an (z. B. Hadoop, MongoDB) – ähnlich<br />

wie für etablierte Datenbanken oder Dateisysteme, die<br />

lesend bzw. schreibend angesprochen werden können.<br />

Um die manuelle Hadoop/MapReduce-Programmierung<br />

zu vereinfachen und den Datenzugriff zu erleichtern, sind<br />

ETL-Technologien entsprechend erweitert worden. Im<br />

Kontext eines Daten- und Transformationsflusses können<br />

MapReduce-Jobs konfiguriert, generiert und ausgeführt<br />

werden. Hierbei werden Technologien wie Hive und Pig<br />

genutzt, aber aus Vereinfachungsgründen gekapselt und<br />

abstrahiert. Ähnlich wie in ETL-Verfahren mit Java als<br />

Transformationslogik kann nun Hadoop komplementär<br />

oder alternativ verwendet werden, um ELT-Prozesse zu<br />

automatisieren (vgl. Abbildung 13).<br />

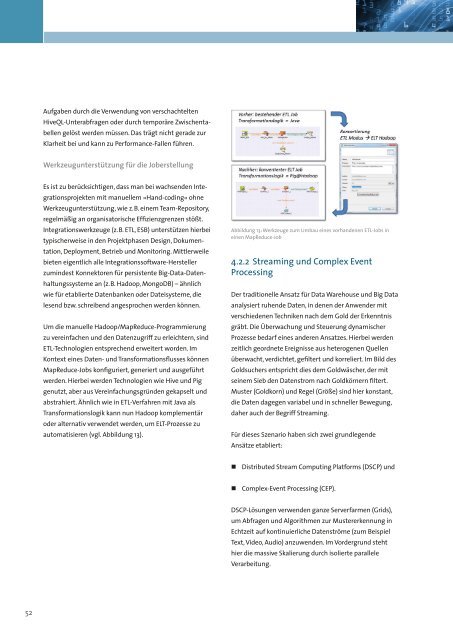

Abbildung 13: Werkzeuge zum Umbau eines vorhandenen ETL-Jobs in<br />

einen MapReduce-Job<br />

4.2.2 Streaming und Complex Event<br />

Processing<br />

Der traditionelle Ansatz für Data Warehouse und Big Data<br />

analysiert ruhende Daten, in denen der Anwender mit<br />

verschiedenen Techniken nach dem Gold der Erkenntnis<br />

gräbt. Die Überwachung und Steuerung dynamischer<br />

Prozesse bedarf eines anderen Ansatzes. Hierbei werden<br />

zeitlich geordnete Ereignisse aus heterogenen Quellen<br />

überwacht, verdichtet, gefiltert und korreliert. Im Bild des<br />

Goldsuchers entspricht dies dem Goldwäscher, der mit<br />

seinem Sieb den Datenstrom nach Goldkörnern filtert.<br />

Muster (Goldkorn) und Regel (Größe) sind hier konstant,<br />

die Daten dagegen variabel und in schneller Bewegung,<br />

daher auch der Begriff Streaming.<br />

Für dieses Szenario haben sich zwei grundlegende<br />

Ansätze etabliert:<br />

• Distributed Stream Computing Platforms (DSCP) und<br />

• Complex-Event Processing (CEP).<br />

DSCP-Lösungen verwenden ganze Serverfarmen (Grids),<br />

um Abfragen und Algorithmen zur Mustererkennung in<br />

Echtzeit auf kontinuierliche Datenströme (zum Beispiel<br />

Text, Video, Audio) anzuwenden. Im Vordergrund steht<br />

hier die massive Skalierung durch isolierte parallele<br />

Verarbeitung.<br />

52