2 - SAM - ETH Zürich

2 - SAM - ETH Zürich

2 - SAM - ETH Zürich

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

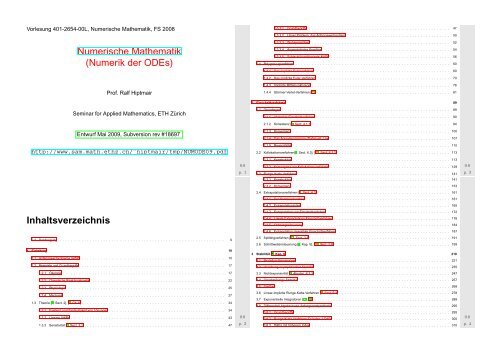

Vorlesung 401-2654-00L, Numerische Mathematik, FS 2008<br />

Numerische Mathematik<br />

(Numerik der ODEs)<br />

1.3.3.1 Grundbegriffe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47<br />

1.3.3.2 Unser Problem: das Anfangswertproblem . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 50<br />

1.3.3.3 Wohlgestelltheit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 52<br />

1.3.3.4 Asymptotische Kondition . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 54<br />

1.3.3.5 Schlecht konditionierte AWPe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 56<br />

1.4 Polygonzugverfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 60<br />

1.4.1 Das explizite Eulerverfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 60<br />

1.4.2 Das implizite Euler-Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70<br />

Prof. Ralf Hiptmair<br />

1.4.3 Implizite Mittelpunktsregel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 76<br />

1.4.4 Störmer-Verlet-Verfahren [13] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 81<br />

2 Einschrittverfahren 89<br />

Seminar for Applied Mathematics, <strong>ETH</strong> Zürich<br />

2.1 Grundlagen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 89<br />

2.1.1 Abstrakte Einschrittverfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 90<br />

2.1.2 Konsistenz [5, Sect. 4.1.1] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 94<br />

Entwurf Mai 2009, Subversion rev #18697<br />

http://www.sam.math.ethz.ch/˜hiptmair/tmp/NUMODE09.pdf<br />

Inhaltsverzeichnis<br />

0.1 Danksagung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9<br />

1 Einleitung 10<br />

1.1 Anfangswertprobleme (AWP) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10<br />

1.2 Beispiele und Grundbegriffe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17<br />

1.2.1 Ökologie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17<br />

1.2.2 Chemische Reaktionskinetik . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22<br />

1.2.3 Physiologie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25<br />

1.2.4 Mechanik . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27<br />

1.3 Theorie [5, Sect. 2], [1, Ch. II] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34<br />

1.3.1 Existenz und Eindeutigkeit von Lösungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34<br />

1.3.2 Lineare AWPe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 43<br />

1.3.3 Sensitivität [5, Sect. 3.1] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47 p. 2<br />

0.0<br />

p. 1<br />

0.0<br />

2.1.3 Konvergenz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 100<br />

2.1.4 Das Äquivalenzprinzip (Dahlquist, Lax) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 107<br />

2.1.5 Reversibilität . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 110<br />

2.2 Kollokationsverfahren[5, Sect. 6.3], [11, Sect. II.1.2] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 113<br />

2.2.1 Konstruktion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 113<br />

2.2.2 Konvergenz von Kollokationsverfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 129 0.0<br />

2.3 Runge-Kutta-Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 141 p. 3<br />

2.3.1 Konstruktion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 141<br />

2.3.2 Konvergenz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 153<br />

2.4 Extrapolationsverfahren [5, Sect. 4.3] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 161<br />

2.4.1 Der Kombinationstrick . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 161<br />

2.4.2 Extrapolationsidee . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 165<br />

2.4.3 Extrapolation von Einschrittverfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 172<br />

2.4.4 Lokale Extrapolations-Einschrittverfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 178<br />

2.4.5 Ordnungssteuerung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 184<br />

2.4.6 Extrapolation reversibler Einschrittverfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 187<br />

2.5 Splittingverfahren [11, Sect. 2.5] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 191<br />

2.6 Schrittweitensteuerung [5, Kap. 5], [16, Sect. 2.8] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 199<br />

3 Stabilität [5, Kap. 6] 219<br />

3.1 Modellproblemanalyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 221<br />

3.2 Vererbung asymptotischer Stabilität . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 235<br />

3.3 Nichtexpansivität [5, Abschn. 6.3.3] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 247<br />

3.4 Gleichmässige Stabilität . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 257<br />

3.5 Steifheit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 268<br />

3.6 Linear-implizite Runge-Kutta-Verfahren [5, Sect. 6.4] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 278<br />

3.7 Exponentielle Integratoren [21, 24] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 288<br />

3.8 Differentiell-Algebraische Anfangswertprobleme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 295<br />

3.8.1 Grundbegriffe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 295<br />

3.8.2 Runge-Kutta-Verfahren für Index-1-DAEs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 300 0.0<br />

3.8.3 DAEs mit höherem Index . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 310 p. 4

4 Strukturerhaltende numerische Integration 324<br />

4.1 Polynomiale Invarianten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 325<br />

4.2 Volumenerhaltung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 338<br />

Kapitel 4:<br />

Kapitel 6:<br />

http://www.sam.math.ethz.ch/˜hiptmair/tmp/Literatur1.pdf<br />

http://www.sam.math.ethz.ch/˜hiptmair/tmp/Literatur2.pdf<br />

4.3 Verallgemeinerte Reversibilität . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 347<br />

4.4 Symplektizität . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 356<br />

4.4.1 Symplektische Evolutionen Hamiltonscher Differentialgleichungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 356<br />

4.4.2 Symplektische Integratoren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 371<br />

4.4.3 Rückwärtsanalyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 394<br />

4.4.4 Modifizierte Gleichungen: Fehleranalyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 406<br />

4.4.5 Strukturerhaltende modifizierte Gleichungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 430<br />

4.5 Methoden für oszillatorische Differentialgleichungen [20] . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 440<br />

5 Randwertprobleme 455<br />

Enzyklopädische Präsentation klassischer numerischer Integratoren:<br />

E. HAIRER, S. NORSETT, AND G. WANNER, Solving Ordinary Differential Equations I. Nonstiff Problems,<br />

Springer, Heidelberg, 2nd ed., 1993.<br />

E. HAIRER AND G. WANNER, Solving Ordinary Differential Equations II. Stiff and Differential-Algebraic<br />

Problems, Springer, Heidelberg, 1991.<br />

Umfassende Darstellung “strukturerhaltender” Integratoren:<br />

Verzeichnisse 456<br />

Stichwortverzeichnis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 456<br />

Verzeichnis der Beispiele und Bemerkungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 466<br />

Verzeichnis der Definitionen und Konzepte . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 470<br />

Verzeichnis der MATLAB-CODE-Fragmente . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 472<br />

Symbolverzeichnis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 473<br />

Allgemeine Informationen<br />

0.0<br />

p. 5<br />

E. HAIRER, C. LUBICH, AND G. WANNER, Geometric numerical integration, vol. 31 of Springer Series<br />

in Computational Mathematics, Springer, Heidelberg, 2002.<br />

Gute Einführung in die Numerik Hamiltonscher Differentialgleichungen:<br />

B. LEIMKUHLER AND S. REICH, Simulating Hamiltonian Dynamics, vol. 14 of Cambridge Monographs 0.0<br />

on Applied and Computational Mathematics, Cambridge University Press, Cambridge, UK, 2004. p. 7<br />

Reporting errors<br />

Please report errors in the electronic lecture notes via a wiki page !<br />

Dozent: Prof. Ralf Hiptmair, <strong>SAM</strong>, D-MATH, Büro: HG G 58.2 Tel.: 044 632 3404,<br />

hiptmair@sam.math.ethz.ch<br />

Assistent: Holger Heumann, <strong>SAM</strong>, D-MATH Büro: HG G 58.3, Tel.: 044 632 8587,<br />

holger.heumann@sam.math.ethz.ch<br />

http://elbanet.ethz.ch/wikifarm/rhiptmair/index.php?n=Main.NCSECourse<br />

(Password: CSE, please choose EDIT menu to enter information)<br />

Website:<br />

Please supply the following information:<br />

Prüfung:<br />

Übungen:<br />

schriftliche Prüfung am Rechner (teilweise MATLAB-basierte Programmieraufgaben),<br />

keine (mitgebrachten) Hilfsmittel<br />

Vorlesungsunterlagen werden als PDF-Datei zur Verf¨gung gestellt<br />

• wöchentliches Übungsblatt (Bearbeitungszeit 1 Woche)<br />

• MATLAB-basierte Programmieraufgaben<br />

• Testatbedingung: 75% der Übungen abgegeben und akzeptiert<br />

• (sub)section where the error has been found,<br />

• precise location (e.g, after Equation (4), Thm. 2.3.3, etc. ). Refrain from giving page numbers,<br />

• brief description of the error.<br />

Alternative: E-mail an hiptmair@sam.math.ethz.ch, Subject: NUMODE<br />

☞ Literatur:<br />

P. DEUFLHARD AND F. BORNEMANN, Numerische Mathematik II, DeGruyter, Berlin, 2 ed., 2002. p. 6<br />

0.0<br />

0.1<br />

p. 8

0.1 Danksagung<br />

Dank geht an Frau Evgenia Ageeva für die Aufarbeitung der MATLAB-Codes zu numerischen Beispielen.<br />

offene Teilmenge D ⊂ R d ˆ= Zustandsraum ↔ “Zustandsvariable” y (engl. state space)<br />

Ω := I × D ˆ= erweiterter Zustandsraum (enthält Tupel (t,y))<br />

✎ Notation (Newton): Punkt ˙ ˆ= (totale) Ableitung nach der Zeit t<br />

✎ Notation: Fettdruck für Spaltenvektoren (Komponenten selektiert durch Subscript-Indices)<br />

Für d > 1 heisst (1.1.1) auch System gewöhnlicher Differentialgleichungen:<br />

⎛<br />

(1.1.1) ⇐⇒ ⎝ y ⎞ ⎛<br />

1<br />

. ⎠ = ⎝ f ⎞<br />

1(t,y 1 , ...,y d )<br />

. ⎠ .<br />

y d f d (t, y 1 ,...,y d )<br />

0.1<br />

p. 9<br />

Grundannahme: stetige rechte Seite f : I × D ↦→ R d 1.1<br />

p. 11<br />

1 Einleitung<br />

1.1 Anfangswertprobleme (AWP)<br />

Definition 1.1.1 (Lösung einer gewöhnlichen Differentialgleichung).<br />

Eine Funktion y ∈ C 1 (J, D), J ⊂ I Intervall positiver Länge, heisst Lösung der gewöhnlichen<br />

Differentialgleichung (1.1.1), falls<br />

ẏ(t) = f(t,y(t)) für alle t ∈ J .<br />

Beispiel 1.1.1 (Richtungsfeld und Lösungskurven).<br />

Riccati-Differentialgleichung<br />

skalare ODE<br />

Eine gewöhnliche Differentialgleichung erster Ordnung<br />

ẏ = y 2 + t 2<br />

➤<br />

d = 1, I, D = R + . (1.1.2)<br />

(engl. first-order ordinary differential equation (ODE)):<br />

ẏ = f(t,y) (1.1.1)<br />

f : I × D ↦→ R d ˆ= rechte Seite (d ∈ N)<br />

I ⊂ R ˆ= (Zeit)intervall ↔ “Zeitvariable” t p. 10<br />

1.1<br />

1.1<br />

p. 12

1.5<br />

1.5<br />

Verallgemeinerung: Eine gewöhnliche Differentialgleichung n-ter Ordnung, n ∈ N:<br />

y (n) = f(t,y,ẏ,...,y (n−1) ) . (1.1.4)<br />

y<br />

1<br />

y<br />

1<br />

✎ Notation: Superscript<br />

(n) ˆ= n. Ableitung nach der Zeit t<br />

0.5<br />

0<br />

0 0.5 1 1.5<br />

t<br />

Fig. 1<br />

Richtungsfeld<br />

0.5<br />

0<br />

0 0.5 1 1.5<br />

t<br />

Fig. 2<br />

Lösungskurven<br />

Lösungskurven tangential zum Richtungsfeld in jedem Punkt des erweiterten Zustandsraumes.<br />

➤ Umwandlung in ODE (System !) erster Ordnung (d ← n · d):<br />

⎛ ⎞<br />

⎛ ⎞ ⎛ ⎞<br />

y(t)<br />

z<br />

z 2<br />

1<br />

z(t) := ⎜ y (1) (t)<br />

⎟<br />

⎝ . ⎠ = ⎜z 2<br />

⎟<br />

⎝ . ⎠ ∈ z 3<br />

Rdn : (1.1.4) ↔ ż = g(z) , g(z) :=<br />

⎜ .<br />

⎟<br />

y (n−1) ⎝ z<br />

(t) z n ⎠ .<br />

n<br />

f(t,z 1 , ...,z n )<br />

(1.1.5)<br />

Theorie<br />

Theorie<br />

für ODEs 1. Ordnung ➥ für ODEs n. Ordnung !<br />

Numerische Verfahren Numerische Verfahren<br />

✸<br />

1.1<br />

p. 13<br />

Vorsicht: (1.1.5) weist spezielle Struktur auf, die ein generisches Verfahren für ODEs 1. Ordnung<br />

vielleicht nicht zur Verbesserung der Genauigkeit/Verringerung des Rechenaufwandes auszunutzen<br />

vermag (→ Diskussion in späteren Kapiteln)<br />

1.1<br />

p. 15<br />

Spezialfall: f(t,y) = f(y) ➡ autonome Differentialgleichung (hier I = R)<br />

ẏ = f(y) . (1.1.3)<br />

Bemerkung 1.1.4. Die Transformation (1.1.5) ist nur eine von (unendlich) vielen Möglichkeiten der<br />

Transformation von (1.1.4) in eine ODE 1. Ordnung.<br />

△<br />

Hier: f : D ⊂ R d ↦→ R d is ein (stetiges) Vektorfeld (Geschwindigkeitsfeld)<br />

Bemerkung 1.1.2 (Translationsinvarianz von Lösungen autonomer Dgl.).<br />

ODE + Anfangsbedigungen = Anfangswertproblem (AWP)<br />

ẏ = f(t,y) , y(t 0 ) = y 0 für ein (t 0 ,y 0 ) ∈ Ω . (1.1.6)<br />

t ↦→ y(t) Lösung von (1.1.3) ⇒ t ↦→ y(t + τ) Lösung von (1.1.3) ∀τ ∈ R<br />

△<br />

Definition 1.1.2 (Lösung eines Anfangswertproblems).<br />

Eine Lösung y : J ↦→ D, t 0 ∈ J, von (1.1.1), die y(t 0 ) = y 0 erfüllt, heisst Lösung des<br />

Anfangswertproblems (1.1.6).<br />

Bemerkung 1.1.3 (Autonomisierung).<br />

( )<br />

y(t)<br />

z(t) := =<br />

t<br />

(<br />

z ′<br />

z d+1<br />

)<br />

: (1.1.1) ↔ ż = g(z) , g(z) :=<br />

(<br />

f(zd+1 ,z ′ )<br />

)<br />

.<br />

1<br />

Bemerkung 1.1.5.<br />

Wenn ODE autonom<br />

Bem. 1.1.2<br />

➣ O.B.d.A. setze t 0 = 0 in (1.1.6)<br />

△<br />

△<br />

Bemerkung 1.1.6 (Anfangswerte für Dgl. höherer Ordnung).<br />

1.1<br />

p. 14<br />

Anfangswertproblem für gewöhnliche Differentialgleichung n-ter Ordnung (1.1.4):<br />

y (n) = f(t,y) , y(t 0 ) = y 0 ,ẏ(t 0 ) = y 1 , . ..,y (n−1) (t 0 ) = y n−1 . p. 16<br />

1.1

➡ n unabhängige Anfangswerte sind vorzugeben.<br />

Modellierung: Anfangswertprobleme (1.1.6) beschreiben deterministische Evolutionen<br />

△<br />

MATLAB-CODE: ODE-Integration<br />

fn = @(t,y) 5*y*(1-y);<br />

[t,y] = ode45(fn,[0 1.5],y0);<br />

plot(t,y,’r-’);<br />

Numerische Integration der logistischen Differentialgleichung<br />

in MATLAB mittels Funktion ode45():<br />

Funktions-Handle zur Übergabe der rechten Seite<br />

Zeitintervall<br />

Anfangswert<br />

1.2 Beispiele und Grundbegriffe<br />

Rückgabewerte:<br />

t ˆ= Vektor von Zeitpunkten, y ˆ= Vektor von Lösungswerten<br />

✸<br />

1.2.1 Ökologie<br />

Bemerkung 1.2.2 (AWP-Löser in MATLAB). → [26]<br />

[t,y] = solver(odefun,tspan,y0);<br />

Beispiel 1.2.1 (Resourcenbegrenztes Wachstum). [1, Sect. 1.1]<br />

Autonome logistische Differentialgleichung: (d = 1, D = R + , I = R)<br />

solver : ∈ { ode23, ode45, ode113, ode15s, ode23s, ode23t,<br />

ode23tb }<br />

odefun : Funktions-Handle vom Typ @(t,y) ↔ rechte Seite f(t,y)<br />

tspan : 2-Vektor: Anfangs- und Endzeitpunkt für numerische Integration<br />

y0 : (Vektor ) mit Anfangswerten y 0<br />

ẏ = (α − βy)y (1.2.1)<br />

1.2<br />

p. 17<br />

Warum so viele verschiedene Löser ?<br />

△<br />

1.2<br />

p. 19<br />

y ˆ= Populationsdichte, [y] = 1 m 2<br />

Beispiel 1.2.3 (Räuber-Beute-Modelle). [1, Sect. 1.1] & [11, Sect. 1.1.1]<br />

Wachstumsrate α − βy mit Wachstumskoeffizienten α, β > 0, [α] = 1 m2<br />

s , [β] = s<br />

Allgemein für ODE (1.1.1):<br />

y ∗ ∈ D, f(t,y ∗ ) = 0 ∀t ➣ y ∗ ist Fixpunkt/stationärer Punkt für die ODE → Sect. 3.2.<br />

Autonome Lotka-Volterra-Dgl.: (d = 2)<br />

˙u = (α − βv)u<br />

˙v = (δu − γ)v , I = R, D = (R+ ) 2 , α, β,γ, δ > 0 . (1.2.3)<br />

1.5<br />

Populationsdichten:<br />

1<br />

Attraktiver Fixpunkt y = α/β<br />

Repulsiver Fixpunkt y = 0<br />

u → Beute,<br />

v → Räuber<br />

y<br />

0.5<br />

0<br />

0 0.5 1 1.5<br />

t<br />

Fig. 3<br />

Richtungsfeld und Lösungskurven (α, β = 5)<br />

Separation der Variablen<br />

➥ Lösung des AWP für (1.2.1)<br />

mit y(0) = y 0 > 0<br />

y(t) =<br />

für alle t ∈ R<br />

αy 0<br />

βy 0 + (α − βy 0 ) exp(−αt) , (1.2.2)<br />

1.2<br />

p. 18<br />

Vektorfeld f für Lotka-Volterra-Dgl.<br />

Lösungskurven sind Trajektorien von Partikeln, die<br />

vom Geschwindigkeitsfeld f mitgetragen werden.<br />

✄<br />

(1.2.3) ⇒ 0 =(δ − γ u ) ˙u − (α v − β) ˙v = d (δu − γ log u − α log v + βv) = 0 .<br />

dt } {{ }<br />

=:I(u,v)<br />

v<br />

α/β<br />

γ/δ<br />

u<br />

Fig. 4<br />

1.2<br />

p. 20

Falls (u(t), v(t)) Lösung von (1.2.3) ⇒ I(u(t),v(t)) ≡ const<br />

Lösungen von (1.2.3) sind Niveaulinien von I<br />

A<br />

C<br />

Reaktion:<br />

k 2<br />

A + B<br />

←−<br />

−→ C + D . (1.2.5)<br />

k1<br />

6<br />

5<br />

4<br />

u = y 1<br />

v = y 2<br />

6<br />

5<br />

4<br />

B<br />

D<br />

Fig. 5<br />

mit Reaktionskonstanten k 1 (‘Hinreaktion”), k 2<br />

(“Rückreaktion”), [k 1 ] = [k 2 ] = cm3<br />

mol s .<br />

y<br />

3<br />

v = y 2<br />

3<br />

Faustregel:<br />

Geschwindigkeit einer bimolekularen Reaktion proportional zum Produkt der Konzentrationen<br />

der Reaktionspartner:<br />

2<br />

1<br />

2<br />

1<br />

for (1.2.5): ċ A = ċ B = −ċ C = −ċ D = −k 1 c A c B + k 2 c C c D . (1.2.6)<br />

c A , c B , c C ,c D ˆ= (zeitabhängige) Konzentrationen der Reaktanden, [c X ] = mol<br />

cm 3 ➥ c X (t) > 0; ∀t<br />

0<br />

1 2 3 4 5 6 7 8 9 10<br />

t<br />

Zeitabhängige Lösung, y 0 := ( u(0)<br />

v(0)<br />

)<br />

=<br />

( 42 )<br />

0<br />

0 0.5 1 1.5 2 2.5 3 3.5 4<br />

u = y 1<br />

Lösungskurven von (1.2.3) ↔ Niveaulinien von I<br />

Fixpunkt<br />

Geschlossene Lösungskurven ↔ (1.2.3) hat ausschliesslich periodische Lösungen<br />

(für u(0),v(0) > 0)<br />

Definition 1.2.1 (Erstes Integral).<br />

Ein Funktional I : D ↦→ R heisst erstes Integral/Invariante (engl. invariant) der ODE (1.1.1),<br />

wenn<br />

für jede Lösung y = y(t) von (1.1.1).<br />

I(y(t)) ≡ const<br />

Notwendige und hinreichende Bedingung für differenzierbares erstes Integral<br />

1.2<br />

✸<br />

p. 21<br />

(1.2.6) = autonome gewöhnliche Dgl. (1.1.3) mit<br />

⎛ ⎞<br />

⎛ ⎞<br />

c A (t)<br />

1<br />

y(t) = ⎜c B (t)<br />

⎟<br />

⎝c C (t) ⎠ , f(t,y) = (−k 1y 1 y 2 + k 2 y 3 y 4 ) ⎜ 1<br />

⎟<br />

⎝−1⎠ c D (t)<br />

−1<br />

Massenerhaltung:<br />

Beispiel 1.2.5 (Oregonator-Reaktion).<br />

d<br />

dt (c A(t) + c B (t) + c C (t) + c D (t)) = 0<br />

Spezialfall einer zeitlich oszillierenden Zhabotinski-Belousov-Reaktion [8]:<br />

BrO − 3 + Br− ↦→ HBrO 2<br />

HBrO 2 + Br − ↦→ Org<br />

BrO − 3 + HBrO 2 ↦→ 2 HBrO 2 + Ce(IV)<br />

(1.2.7)<br />

2 HBrO 2 ↦→ Org<br />

Ce(IV) ↦→ Br −<br />

✸<br />

1.2<br />

p. 23<br />

I erstes Integral von (1.1.1) ⇔ grad I(y) ·f(t,y) = 0 ∀(t,y) ∈ Ω . (1.2.4)<br />

Euklidisches Skalarprodukt<br />

1.2.2 Chemische Reaktionskinetik [5, Sect. 1.3]<br />

Beispiel 1.2.4 (Bimolekulare Reaktion).<br />

1.2<br />

p. 22<br />

y 1 := c(BrO − 3 ): ẏ 1 = −k 1 y 1 y 2 − k 3 y 1 y 3 ,<br />

y 2 := c(Br − ): ẏ 2 = −k 1 y 1 y 2 − k 2 y 2 y 3 + k 5 y 5 ,<br />

y 3 := c(HBrO 2 ): ẏ 3 = k 1 y 1 y 2 − k 2 y 2 y 3 + k 3 y 1 y 3 − 2k 4 y3 2 ,<br />

y 4 := c(Org): ẏ 4 = k 2 y 2 y 3 + k 4 y3 2 ,<br />

y 5 := c(Ce(IV)): ẏ 5 = k 3 y 1 y 3 − k 5 y 5 ,<br />

mit (dimensionslosen) Reaktionskonstanten:<br />

k 1 = 1.34 , k 2 = 1.6 · 10 9 , k 3 = 8.0 · 10 3 , k 4 = 4.0 · 10 7 , k 5 = 1.0 .<br />

Periodische chemische Reaktion ➽ Video 1, Video 2<br />

(1.2.8)<br />

MATLAB-Simulation mit Anfangswerten y 1 (0) = 0.06, y 2 (0) = 0.33 · 10 −6 , y 3 (0) = 0.501 · 10 −10 , 1.2<br />

y 4 (0) = 0.03, y 5 (0) = 0.24 · 10 −7 : p. 24

10 −3 Concentration of Br −<br />

Concentration of HBrO 2<br />

2.5<br />

2<br />

Phase flow for Zeeman model (α = 5.000000e−01,β=1.000000e−01)<br />

3<br />

Heartbeat according to Zeeman model (α = 5.000000e−01,β=1.000000e−01)<br />

l(t)<br />

p(t)<br />

2<br />

10 −4<br />

10 −6<br />

1.5<br />

1<br />

1<br />

10 −5<br />

10 −7<br />

0.5<br />

p<br />

0<br />

l/p<br />

0<br />

c(t)<br />

10 −6<br />

10 −7<br />

c(t)<br />

10 −8<br />

−0.5<br />

−1<br />

−1<br />

10 −8<br />

10 −9<br />

−1.5<br />

−2<br />

−2<br />

10 −9<br />

10 −10<br />

−2.5<br />

0<br />

l<br />

2 2.5<br />

Fig. 10<br />

−2.5 −2 −1.5 −1 −0.5 0.5 1 1.5<br />

−3<br />

0 10 20 30 40 50 60 70 80 90 100<br />

time t<br />

Fig. 11<br />

10 −10<br />

0 20 40 60 80 100 120 140 160 180 200<br />

Fig. 6<br />

t<br />

10 −5 t<br />

10 −11<br />

0 20 40 60 80 100 120 140 160 180 200<br />

Fig. 7 ✸<br />

Beobachtung: α ≪ 1 ➤ “Kammerflimmern”<br />

✸<br />

1.2.3 Physiologie<br />

1.2.4 Mechanik<br />

Beispiel 1.2.6 (Zeemans Herzschlagmodell). → [3, p. 655] p. 25<br />

1.2<br />

Beispiel 1.2.7 (Mathematisches Pendel).<br />

[1, I.3. Bsp. (3.4c)]<br />

1.2<br />

p. 27<br />

Grössen:<br />

mit Parametern:<br />

l = l(t) ˆ= Länge der Herzmuskelfaser<br />

p = p(t) ˆ= elektrochemisches Potential<br />

Phänomenologisches Modell:<br />

˙l = −(l 3 − αl + p) ,<br />

ṗ = βl ,<br />

α ˆ= Vorspannung der Muskelfaser<br />

β ˆ= (phänomenologischer) Rückkopplungsparameter<br />

Vektorfelder und numerische Lösungen für verschiedene Parameter:<br />

(1.2.9)<br />

Zustandsraum D = Konfigurationsraum für Minimalkoordinaten<br />

(= Auslenkungswinkel)<br />

➣<br />

d = 1, D = T (Kreislinie = “1D Torus”)<br />

Auslenkungswinkel α ∈ [−π,π[)<br />

Newtonsche Bewegungsgleichungen:<br />

ml ¨α(t) = −mg sinα(t) . (1.2.10)<br />

autonome ODE 2. Ordnung, siehe (1.1.4)<br />

l<br />

α<br />

mg<br />

Fig. 12<br />

2.5<br />

2<br />

1.5<br />

Phase flow for Zeeman model (α = 3,β=1.000000e−01)<br />

3<br />

2<br />

Heartbeat according to Zeeman model (α = 3,β=1.000000e−01)<br />

l(t)<br />

p(t)<br />

Formale Umwandlung in gewöhnliche Differentialgleichungen 1. Ordnung:<br />

Winkelgeschwindigkeit p := ˙α ⇒ d ( ) ( )<br />

α p<br />

=<br />

dt p − g l sin α . (1.2.11)<br />

1<br />

0.5<br />

1<br />

Energieerhaltung: E(t) = 1 2 ml2 p(t) 2 − mgl cosα(t) ⇒ E(t) ≡ const. (1. Integral → Def. 1.2.1) .<br />

p<br />

0<br />

−0.5<br />

l/p<br />

0<br />

kinetische Energie T(t)<br />

potentielle Energie U(t)<br />

−1<br />

−1<br />

−1.5<br />

−2<br />

−2<br />

−2.5<br />

−2.5 −2 −1.5 −1 −0.5 0<br />

l<br />

0.5 1 1.5 2 2.5<br />

Fig. 8<br />

−3<br />

0 10 20 30 40 50 60 70 80 90 100<br />

time t<br />

Fig. 9<br />

1.2<br />

p. 26<br />

1.2<br />

p. 28

4<br />

3<br />

Phase field for pendulum: l=1, g=1<br />

3<br />

2<br />

✬<br />

Lemma 1.2.3 (“Energieerhaltungssatz”).<br />

Die Hamilton-Funktion H is ein erstes Integral des autonomen Hamiltonschen Systems.<br />

✩<br />

p = velocity<br />

2<br />

1<br />

0<br />

−1<br />

−2<br />

−3<br />

−4<br />

−4 −3 −2 −1 0<br />

q = α<br />

1 2 3 4<br />

Fig. 13<br />

Vektorfeld für (1.2.11)<br />

p = velocity<br />

1<br />

0<br />

−1<br />

−2<br />

−3<br />

−3 −2 −1 0 1 2 3<br />

q = α<br />

Fig. 14<br />

Isolinien der Energie ↔ Lösungskurven<br />

✸<br />

✫<br />

Hamiltonsches System in der Form (1.1.1):<br />

(<br />

p<br />

y = ⇒ (1.2.12) ⇔ ẏ = J<br />

q)<br />

−1 · gradH(y) , J :=<br />

✎ Notation: I n ˆ= n × n Einheitsmatrix<br />

( )<br />

0 In<br />

∈ R<br />

−I n 0<br />

2n,2n . (1.2.13)<br />

Zusammen mit (1.2.4) folgt sofort Lemma 1.2.3, denn J ist schiefsymmetrisch (J T = −J) und für<br />

jede schiefsymmetrische Matrix A ∈ R n,n gilt x · Ax = 0 ∀x ∈ R n .<br />

Beispiel 1.2.9 (Massenpunkt im Zentralfeld).<br />

✪<br />

Newtonsche Bewegungsgleichungen eines Körpers (Ortskoordinate r = r(t)) mit Masse m > 0 im<br />

Kraftfeld f : R n ↦→ R n , n ∈ N:<br />

m ¨r(t) = f(r(t)) . (1.2.14)<br />

Definition 1.2.2 (Hamiltonsche Differentialgleichung).<br />

→ [11, Sect. VI.1.2]<br />

Es sei n ∈ N, M ⊂ R n offen, H : R n × M ↦→ R, H = H(p,q), stetig differenzierbar. Dann<br />

heisst die gewöhnliche Differentialgleichung erster Ordnung<br />

ṗ(t) = − ∂H<br />

∂q (p(t),q(t)) ,<br />

∂H<br />

˙q(t) = (p(t),q(t)) , (1.2.12)<br />

∂p<br />

ein autonomes Hamiltonsches System mit Hamilton-Funktion (engl. Hamiltonian) H.<br />

1.2<br />

p. 29<br />

Spezialfall:<br />

radialsymmetrisches konservatives Kraftfeld<br />

f(x) = −grad U(x) , x ∈ R n , U(x) = G(‖x‖) . (1.2.15) p. 31<br />

√<br />

✎ Notation: ‖x‖ := x 2 1 + · · · + x2 n ˆ= Euklidische Norm eines Vektors<br />

Speziell G(r) = G 0<br />

r<br />

:<br />

Keplerproblem: [11, Sect. I.2], [5, Sect. 1.1]<br />

Bewegung im Gravitationsfeld einer Zentralmasse<br />

(Sonne – Planet)<br />

1.2<br />

Für Pendelgleichung (1.2.11): n = 1, M =]0, 2π[, q ↔ α,<br />

H(p,q) = 2 1p2 − g l cos q (Gesamtenergie !)<br />

Terminologie: q ˆ= Ortsvariable, Konfigurationsvariable,<br />

p ˆ= Impulsvariable (engl. momentum variable),<br />

M ˆ= Konfigurationsraum.<br />

Bemerkung 1.2.8. Bewegungsgleichungen der klassischen Mechanik führen auf autonome Hamiltonsches<br />

Systeme, siehe [1, Sect. I.3] für eine Einführung, [2] für eine umfassende Darstellung.<br />

△<br />

←→<br />

Hamiltonsches System (→ Def. 1.2.2) mit Konfigurationsraum M := R n \ {0}, q := r, und<br />

Hamilton-Funktion (Energie) H(p,q) := 1<br />

2m ‖p‖2 + G(‖q‖) (1.2.16)<br />

p := mṙ ˆ= Impuls, kinetische Energie potentielle Energie<br />

ṗ = −G ′ (‖q‖) q<br />

‖q‖ , ˙q = m−1 p . (1.2.17)<br />

✬<br />

Lemma 1.2.4 (Bahnebene).<br />

Jede Lösung ( p<br />

q<br />

)<br />

: J ⊂ R ↦→ R 2n von (1.2.17) erfüllt<br />

p(t),q(t) ∈ Span {p(t 0 ),q(t 0 )} ∀t 0 ,t ∈ J .<br />

✩<br />

1.2<br />

p. 30<br />

✫<br />

✪<br />

1.2<br />

p. 32

✬<br />

Lemma 1.2.5 (Drehmomenterhaltung).<br />

Für n = 3 ist das Drehmoment (bzgl. 0) M := p × q (engl. angular momentum) ein erstes<br />

Integral (→ Def. 1.2.1) von (1.2.17).<br />

✫<br />

✎ Notation: × ˆ= Vektorprodukt im R 3 :<br />

⎛<br />

a × b = ⎝ a ⎞<br />

2b 3 − a 3 b 2<br />

a 3 b 1 − a 1 b 3 ⎠ .<br />

a 1 b 2 − a 2 b 1<br />

✬<br />

Theorem 1.2.6 (2. Keplersches Gesetz). Löst<br />

t ↦→ q(t) die Differentialgleichung (1.2.17),<br />

so überstreicht der Vektor q(t) in gleichen<br />

Zeitspannen gleiche Flächen in der Bahnebene.<br />

✫<br />

✩<br />

✪<br />

✩<br />

✪<br />

Definition 1.3.1 (Maximale Fortsetzbarkeit einer Lösung).<br />

Eine Lösung y ∈ C 1 ([t 0 , t 1 [,D) (→ Def. 1.1.1) des AWP (1.1.6) heisst maximal (in die Zukunft)<br />

fortsetzbar<br />

⇔: Es gibt eine Lösung ỹ ∈ C 1 ([t 0 ,t + [,D) des AWP (1.1.6) mit t + ≥ t 1 , y(t) = ỹ(t)<br />

∀t 0 ≤ t < t 1 , wobei genau einer der drei folgenden Fälle zutrifft:<br />

(i) t + = ∞ (Lösung existiert für alle Zeiten)<br />

(ii) t + < ∞ ,<br />

lim ‖ỹ(t)‖ = ∞<br />

t→t +<br />

( Blow-up”) ”<br />

(iii) t + < ∞ ,<br />

lim dist((t,ỹ(t)),∂Ω) = 0 .<br />

t→t +<br />

( Kollaps”)) ”<br />

(Analog: Maximale Fortsetzbarkeit in die Vergangenheit auf ]t − , t 0 ])<br />

1. Keplersches Gesetz (für Gravitationspotential):<br />

Für G(r) = G 0 r sind die Lösungskurven von (1.2.14) Ellipsen mit Brennpunkt 0.<br />

1.3 Theorie [5, Sect. 2], [1, Ch. II]<br />

✸<br />

1.3<br />

p. 33<br />

y<br />

(i)<br />

1.3<br />

p. 35<br />

Zu gegebener rechter Seite f : Ω := I × D ↦→ R d , d ∈ N, I ⊂ R offenes Intervall, D ⊂ R d offene<br />

Menge, betrachte das Anfangswertproblem<br />

(iii)<br />

: ”<br />

Blow-Up”<br />

ẏ = f(t,y) , y(t 0 ) = y 0 für gegebenes (t 0 ,y 0 ) ∈ Ω . (1.1.6)<br />

(ii)<br />

: ”<br />

Kollaps”<br />

: J(t 0 , y 0 ) = R<br />

t<br />

1.3.1 Existenz und Eindeutigkeit von Lösungen<br />

Zwei wichtige Begriffe:<br />

Notation: J(t 0 ,y 0 ) =]t − ,t + [ = maximales Existenzintervall für Lösung von AWP (1.1.6).<br />

1.3<br />

p. 34<br />

1.3<br />

p. 36

Definition 1.3.2 (Lokale Lipschitz-Stetigkeit).<br />

f : Ω ↦→ R d heisst lokal Lipschitz-stetig<br />

⇔:<br />

∀(t,y) ∈ Ω: ∃δ > 0, L > 0:<br />

‖f(τ,z) − f(τ,w)‖ ≤ L ‖z − w‖<br />

∀z,w ∈ D: ‖z − y‖ < δ, ‖w − y‖ < δ, ∀τ ∈ I: |t − τ| < δ .<br />

Damit kann (1.3.1) auf dem Intervall [t 0 , t 1 ] als Fixpunktgleichung T(y) = y in F geschrieben werden.<br />

Aus der lokalen Lipschitz-Stetigkeit folgt für genügend kleines t 1 > t 0 , dass T eine Kontraktion<br />

ist. Mit dem Banachschen Fixpunktsatz folgt die Behauptung für das Zeitintervall (t 0 , t 1 ). Das maximale<br />

Existenzintervall erhält man über Fortsetzung.<br />

Bemerkung 1.3.1 (Definitionsintervalle von Lösungen von AWPen).<br />

Lokale Lipschitz-Stetigkeit impliziert globale Lipschitz-Stetigkeit auf jeder kompakten Teilmenge K<br />

von Ω:<br />

∃L = L(K) > 0: ‖f(τ,z) − f(τ,w)‖ ≤ L ‖z − w‖ ∀(τ,z), (τ,w) ∈ K .<br />

Die Lösung eines Anfangswertproblems sucht sich Ihren Definitionsbereich selbst”<br />

”<br />

!<br />

Definitionsbereich J(t 0 ,y 0 ) hängt (meist) von (t 0 ,y 0 ) ab !<br />

Terminologie: Falls J(t 0 ,y 0 ) = I ➥ Lösung y : I ↦→ R d ist global.<br />

△<br />

✎ Notation: D y f ˆ= Ableitung von f nach Zustandsvariablen (= Jacobimatrix ∈ R d,d !)<br />

Ein einfaches Kriterium für lokale Lipschitz-Stetigkeit (Beweis über Mittelwertsatz):<br />

✬<br />

✩<br />

1.3<br />

p. 37<br />

1.3<br />

p. 39<br />

Lemma 1.3.3 (Kriterium für lokale Lipschitz-Stetigkeit).<br />

Sind f und D y f stetig auf Ω, so ist f lokal Lipschitz-stetig (→ Def. 1.3.2).<br />

✫<br />

✪<br />

✬<br />

✩<br />

Theorem 1.3.4 (Satz von Peano & Picard-Lindelöf). [1, Satz II(7.6)]<br />

Falls f : ˆΩ ↦→ R d lokal Lipschitz-stetig in der Variablen y, so hat das AWP (1.1.6) ∀(t 0 ,y 0 ) ∈ ˆΩ<br />

eine eindeutige maximal fortsetzbare Lösung y : J(t 0 ,y 0 ) ↦→ D.<br />

✫<br />

✪<br />

Beweisidee: (→ [27, I.§6]) Integration von (1.1.6) liefert<br />

y(t) = y 0 +<br />

∫ t<br />

f(s,y(s)) ds,<br />

t 0<br />

t ≥ t 0 . (1.3.1)<br />

Definiere Raum<br />

F = {y ∈ C([t 0 , t 1 [), y(t 0 ) = y 0 }<br />

für ein t 1 > t 0 und den Operator<br />

∫ t<br />

T : F → F, T : y ↦→ z(t) = y 0 + f(s,y(s)) ds.<br />

1.3<br />

t 0<br />

p. 38<br />

Definition 1.3.5 (Evolutionsoperator).<br />

Die zweiparametrige Familie Φ s,t von Abbildungen Φ s,t : D ↦→ D heisst Evolutionsoperator<br />

zur Dgl. ẏ = f(t,y), wenn<br />

t ∈ J(s,z) ↦→ Φ s,t z Lösung des AWP<br />

{<br />

˜Ω ↦→ D<br />

Definitionsbereich: Φ :<br />

(t,s,y) ↦→ Φ s,t y<br />

ẏ = f(t,y) ,<br />

y(s) = z ,<br />

, ˜Ω :=<br />

⋃<br />

(s,y)∈Ω<br />

für alle (s,z) ∈ Ω .<br />

J(s,y) × {(s,y)}<br />

Satz 1.3.4 ⇒ Φ t,t = Id , Φ s,t y = (Φ r,t ◦ Φ s,r )y , t,r ∈ J(s,y), (s,y) ∈ Ω . (1.3.2)<br />

Konvention: Für autonome Differentialgleichungen (1.1.3) (→ Bem. 1.1.5): Φ t := Φ 0,t<br />

➣ Falls J(0,y) = R ∀y ∈ D aus (1.3.2):<br />

Gruppe von Abbildungen von D: Φ s ◦ Φ t = Φ s+t , Φ −t ◦ Φ t = Id ∀t ∈ R . (1.3.3)<br />

1.3<br />

p. 40

Bemerkung 1.3.2 (Numerische Integratoren als approximative Evolutionsoperatoren).<br />

MATLAB-Lösung eines , vgl. Bem. 1.2.2<br />

[t,y] = solver(odefun,[t0 T,y0])<br />

1<br />

0.9<br />

0.8<br />

0.7<br />

0.6<br />

0.014<br />

0.012<br />

0.01<br />

0.008<br />

y(t)<br />

0.5<br />

y(t)<br />

Φ s,t y<br />

0.4<br />

0.3<br />

0.006<br />

0.004<br />

☞<br />

Numerische Lösungsverfahren für Anfangswertprobleme für eine gewöhnliche Differentialgleichung<br />

realisieren Approximationen von Evolutionsoperatoren → Def. 2.1.1.<br />

△<br />

0.2<br />

0.1<br />

0<br />

0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8<br />

t<br />

Fig. 16<br />

0.002<br />

0<br />

t<br />

0.768 0.769<br />

Fig. 17<br />

0.76 0.761 0.762 0.763 0.764 0.765 0.766 0.767<br />

Beispiel 1.3.3 (Autonome skalare Differentialgleichungen). ✄ d = 1<br />

✸<br />

• f(t,y) = −λy, λ ∈ R Lösung des AWP y(t) = y 0 e −λt , t ∈ R<br />

existiert für alle Zeiten, d.h. ]t − ,t + [= R für jedes y 0 : globale Lösung.<br />

Zugehöriger Evolutionsoperator:<br />

Φ t : R ↦→ R , Φ t (y 0 ) = e −λt y 0 .<br />

1.3.2 Lineare AWPe<br />

• f(t,y) = λy 2 , λ ∈ R: ẏ = λy 2 , y(0) = y 0 ∈ R p. 41<br />

1.3<br />

Vorbereitung:<br />

Basiswechsel im Zustandsraum (kovariante Transformation):<br />

ŷ = S −1 y , S ∈ R d,d reguläre Matrix (zeitunabhängig). p. 43<br />

1.3<br />

Lösung:<br />

⎧<br />

⎨ 1<br />

y(t) = y0 −1<br />

⎩<br />

−λt , falls y 0 ≠ 0 , (Blow-up)<br />

,<br />

0 , falls y 0 = 0 .<br />

λ, y 0 > 0 ⇒ J(0, y 0 ) =] − ∞, 1/λy 0 [ .<br />

Lösungskurven für λ = 1<br />

✄<br />

y(t)<br />

10<br />

8<br />

6<br />

4<br />

2<br />

0<br />

−2<br />

−4<br />

−6<br />

−8<br />

y 0<br />

= −0.5<br />

y 0<br />

= −1<br />

y 0<br />

= 1<br />

y 0<br />

= 0.5<br />

−10<br />

−3 −2 −1 0<br />

t<br />

1 2 3<br />

Fig. 15<br />

y löst<br />

{<br />

ẏ = f(t,y) ,<br />

y(t 0 ) = y 0<br />

⇔ ŷ := S −1 y löst<br />

{ ˙ŷ = ̂f(t,ŷ) ,<br />

ŷ(t 0 ) = S −1 y 0<br />

mit ̂f(t,ŷ) = S −1 f(t,Sŷ) .<br />

Betrachte Lineare Differentialgleichung mit konstanten Koeffizienten im R d :<br />

(1.3.4)<br />

D = R d , Ω = I × R d<br />

Koeffizientenmatrix A ∈ R d,d<br />

ẏ = Ay + g(t) . (1.3.5)<br />

” Quellterm”: stetige Funktion g : I ↦→ Rd<br />

Annahme:<br />

A diagonalisierbar, ∃S ∈ R d,d regulär: S −1 AS = diag(λ 1 ,...,λ d ), λ i ∈ C<br />

• f(t,y) = − 1 √ y<br />

, D = R + , Anfangswert y(0) = 1<br />

➣ y(t) = (1 − 3t/2) 2/3 , t − = −∞, t + = 2/3<br />

(Lösung läuft zum Rand y = 0 des erweiterten Zustandraums: Kollaps)<br />

• f(t,y) = sin(1/y) − 2, D = R + , Anfangswert y(0) = 1 [5, Bsp. 2.14]<br />

Lösung y(t) erfüllt ẏ ≤ −1 ➥ y(t) ≤ 1 − t ➥ Kollaps für t ∗ < 1.<br />

1.3<br />

p. 42<br />

• g ≡ 0: ẏ = Ay (autonome homogene lineare Dgl., allgemeinere Diskussion [5, Sect. 3.2.2])<br />

ŷ := S −1 y löst<br />

˙ŷ 1 = λ 1 ŷ 1 ,<br />

. ⇒ ŷ i (t) = (S −1 y 0 ) i e λit , t ∈ R .<br />

˙ŷ d = λ d ŷ<br />

⎛ d<br />

e λ ⎞<br />

1t<br />

y(t) = S⎜<br />

...<br />

⎟<br />

⎝ . .. ⎠ S−1 y 0 .<br />

e λ dt<br />

} {{ }<br />

Matrixexponentialfunktion exp(At)<br />

1.3<br />

p. 44

Allgemeine Definition der Matrixexponentialfunktion durch<br />

Wichtige Eigenschaft:<br />

∞∑ 1<br />

“Matrixexponentialreihe”: exp(M) =<br />

k! Mk . (1.3.6)<br />

k=0<br />

Matrixexponentialfunktion kommutiert mit Ähnlichkeitstransformationen<br />

M = S −1 AS ⇒ exp(M) = S −1 exp(A)S ∀A,M,S ∈ C d,d , S regulär. (1.3.7)<br />

• Inhomogener Fall<br />

Ansatz:<br />

ẏ(t) = Ay(t) + g(t) partikuläre Lösung durch ”<br />

Variation der Konstanten”:<br />

y(t) = exp(At)z(t) mit z ∈ C 1 (R, R d ) → [1, Thm I(5.14)]<br />

ẏ(t) = A exp(At)z(t) + exp(At)ż(t) = Ay(t) + g(t) = A exp(At)z(t) + g(t)<br />

∫ t<br />

ż(t) = exp(−At)g(t) ⇒ z(t) = y 0 + exp(−Aτ)g(τ) dτ<br />

t 0<br />

y(t) = exp(At)y 0 + ∫ t<br />

t0<br />

exp(A(t − τ))g(τ) dτ<br />

Lsg. des homogenen Problems<br />

Faltung mit Inhomogenität<br />

Bemerkung 1.3.5 (Bedeutung linearer AWPe).<br />

Linearisierung um einen stationären Punkt f(y ∗ ) = 0:<br />

y ≈ y ∗ : f(y) = D y f(y ∗ )(y − y ∗ ) + O(|y − y ∗ | 2 ) ,<br />

falls f ∈ C 2 .<br />

➣ Lösungen von ẏ = f(y) verhalten sich in der Umgebung von y ∗ (qualitativ) wie Lösungen der<br />

linearen ODE ẏ = D y f(y ∗ )y.<br />

△<br />

1.3.3 Sensitivität [5, Sect. 3.1]<br />

1.3.3.1 Grundbegriffe<br />

1.3<br />

p. 45<br />

Erinnerung<br />

(→ Vorlesung ”<br />

Numerische Methoden”):<br />

1.3<br />

p. 47<br />

Allgemeinere Betrachtungen<br />

→ [1, Kap. III]:<br />

Bemerkung 1.3.4 (Allgemeine Variation-der-Konstanten-Formel). → [1, Thm. (11.13)]<br />

Problem = Abbildung Π : X ↦→ Y von Datenraum X in den Ergebnisraum Y<br />

(beide versehen mit Metriken d X , d Y )<br />

A : J ⊂ R ↦→ R d,d stetige Matrixfunktion, J ⊂ R Intervall<br />

g : J ↦→ R d stetig<br />

✗<br />

✖<br />

Problem ist wohlgestellt (engl. well-posed), wenn Π stetig.<br />

✔<br />

✕<br />

(s, t) ↦→ E(s, t) ∈ R d,d beschreibt Evolutionsoperator, definiert durch<br />

∂E<br />

(s, t) = A(t)E(s, t) ∀(s, t) ∈ J × J , E(s, s) = I . (1.3.8)<br />

∂t<br />

Dann ist die (eindeutige → Thm. 1.3.4) Lösung des nicht-autonomen linearen Anfangswertproblems<br />

gegeben durch<br />

ẏ = A(t)y + g(t) , y(t 0 ) = y 0 ,<br />

Kondition/Sensitivität eines Problems:<br />

Mass für Einfluss von Störungen in den Daten auf das Ergebnis<br />

d<br />

Absolute Kondition: κ abs := sup Y (Π(x), Π(x ′ ))<br />

x,x ′ ∈X,x≠x ′ d X (x,x ′ . (1.3.10)<br />

)<br />

Sprachgebrauch: Problem ist ”<br />

gut konditioniert”, wenn ”<br />

κ abs ≈ 1”<br />

∫t<br />

y(t) = E(t, t 0 )y 0 +<br />

t 0<br />

E(t, s)g(s) ds , t ∈ J . (1.3.9)<br />

△<br />

1.3<br />

p. 46<br />

• Wohlgestelltheit und Gutkonditioniertheit eines Problems hängen entscheidend von den<br />

gewählten Metriken ab. Diese sind bei praktischen Problemen dadurch bestimmt, “woran der<br />

Anwender interessiert ist”.<br />

1.3<br />

p. 48

• Als Folge von unvermeidlichen Eingabefehlern, macht nur die numerische Lösung von<br />

➡<br />

wohlgestellten Problemen Sinn.<br />

• Absolute Konditionszahl ist die globale Lipschitz-Konstante der Problemabbildung (bzgl. der<br />

gewählten Metriken).<br />

Asymptotische (absolute) Kondition (linearisierte Störungstheorie):<br />

κ ∞ d<br />

abs := lim sup Y (Π(x), Π(x ′ ))<br />

δ→0 0 0 ,<br />

1 für λ < 0 .<br />

(1.3.14)<br />

(1.3.15)<br />

1.3.3.2 Unser Problem: das Anfangswertproblem<br />

1.3<br />

p. 49<br />

1.3.3.3 Wohlgestelltheit<br />

✸<br />

1.3<br />

p. 51<br />

Anwendung (der abstrakten Konzepte) auf Anfangswertproblem (1.1.6):<br />

Szenario ➊:<br />

✬<br />

Annahme:<br />

Rechte Seite f : I × D ↦→ R d von (1.1.6) erfüllt globale Lipschitzbedingung<br />

(vgl. lokale Lipschitzbedingung aus Def. 1.3.2)<br />

✩<br />

Eingabedatum y 0 ➥ Datenraum R d , Metrik: Euklidische Vektornorm<br />

Ausgabe y(T) zu Endzeitpunkt T > t 0 ➥ Ergebnisraum R d , Metrik: Euklidische Vektornorm<br />

Szenario ➋:<br />

Eingabedatum y 0 ➥ Datenraum R d , Metrik: Euklidische Vektornorm<br />

Ausgabe: Lösungsfunktion t ∈ J ⊂ I ↦→ y(T)<br />

➥ Ergebnisraum C 0 (J, R d ), Metrik: Maximumnorm ‖·‖ L ∞ (J)<br />

Szenario ➌:<br />

∀t ∈ I: ∃L(t) > 0: ‖f(t,x) − f(t,y)‖ ≤ L(t) ‖x − y‖ ∀x,y ∈ D ⊂ R d , (1.3.16)<br />

für geeignete Vektornorm ‖·‖ auf R d .<br />

✫<br />

✬<br />

Theorem 1.3.6 (Lipschitz-stetige Abhängigkeit vom Anfangswert).<br />

Es seien y,ỹ Lösungen des AWP (1.1.6) zu Anfangswerten y 0 ∈ D bzw. ỹ 0 ∈ D. Unter der<br />

Annahme (1.3.16) mit stetigem L(t) gilt<br />

(∫ t )<br />

‖y(t) − ỹ(t)‖ ≤ ‖y 0 − ỹ 0 ‖ · exp L(τ) dτ ∀t ∈ I .<br />

t 0<br />

✫<br />

Hilfsmittel beim Beweis:<br />

✪<br />

✩<br />

✪<br />

Eingabedaten: Anfangswert y 0 und rechte Seite f<br />

➥ Datenraum R d ×C 1 (I ×R d , R d ), Metrik: Euklidische Vektornorm & Maximumnorm<br />

1.3<br />

p. 50<br />

1.3<br />

p. 52

✬<br />

Lemma 1.3.7 (Gronwalls Lemma). → [1, Sect. II.6], [5, Lemma 3.9]<br />

Sei J ⊂ R Intervall, t 0 ∈ J, u,a,β ∈ C 0 (J, R + ), a monoton wachsend. Dann gilt<br />

∫ t<br />

∫ t<br />

u(t) ≤ a(|t − t 0 |) + β(τ)u(τ) dτ ⇒ u(t) ≤ a(|t − t 0 |) exp<br />

∣ β(τ) dτ<br />

∣ .<br />

t 0 t 0<br />

✫<br />

➤ AWP (1.1.6) is wohlgestellt unter Annahme (1.3.16) !<br />

➤ Schranke für absolute punktweise Kondition (für Endzeitpunkt T )<br />

( ∫ ) T<br />

κ abs ≤ exp L(τ) dτ . (1.3.18)<br />

t 0<br />

Bemerkung 1.3.7 ( ”<br />

Gronwall-Schranke” für Kondition).<br />

Schranke aus (1.3.18) oft extrem pessimistisch !<br />

für skalares lineares AWP mit λ < 0, punktweise Kondition, Endzeit-<br />

Beispiel (siehe Bsp. 1.3.6):<br />

punkt T > 0 (1.3.12)<br />

(1.3.18) ➣ κ abs ≤ e |λ|T T →∞<br />

↦−→ ∞ ←→ κ abs = e λT T →∞<br />

↦−→ 0 .<br />

1.3.3.4 Asymptotische Kondition<br />

✩<br />

✪<br />

1.3<br />

△ p. 53<br />

(Annahme:<br />

( )<br />

∂ ∂Φ<br />

∂t ∂y (t 0, t,y) = d<br />

dy f(t,Φt0,t y) = ∂f<br />

∂y (t,Φt0,t y) d<br />

dy Φt0,t y .<br />

f nach y stetig differenzierbar)<br />

Die Propagationsmatrix (Wronski-Matrix),<br />

zum AWP (1.1.6) erfüllt Anfangswertproblem für<br />

Beachte:<br />

✗<br />

✖<br />

Variationsgleichung<br />

W(t; t 0 ,z) := d<br />

dy Φt0,t ∈ R y|y=z<br />

d,d , (1.3.19)<br />

d<br />

dt W(t; t 0,y 0 ) = ∂f<br />

∂y (t,Φt0,t y 0 )W(t;t 0 ,y 0 ) , (1.3.20)<br />

W(t 0 ;t 0 ,y 0 ) = I .<br />

Variationsgleichung = lineare Differentialgleichung mit D = R d,d<br />

(☞ Matrix-Differentialgleichung)<br />

y 0 ← y 0 + δy 0 ➣ δy(t) ≈ W(t;t 0 ,y 0 )δy 0 für ”<br />

kleine δy 0 ”<br />

Intervallweise asymptotische Kondition des AWP (1.1.6) auf [t 0 , T] (bzgl. Norm ‖·‖ auf R d ):<br />

1.3.3.5 Schlecht konditionierte AWPe<br />

κ ∞ abs := max{‖W(t;t 0,y 0 )‖ : t 0 ≤ t ≤ T } . (1.3.21)<br />

✔<br />

✕<br />

1.3<br />

p. 55<br />

Szenario ➊:<br />

Wie wirken sich kleine Störungen im Anfangswert y 0 in (1.1.6) auf die Lösung y(t)<br />

aus ?<br />

Beispiel 1.3.8 (Lorenz-System). → [23, 18]<br />

Asymptotische absolute Konditionszahl durch differentielle Konditionsanalyse, siehe (1.3.11):<br />

Erforderlich: ”<br />

Differenzieren der Lösung eins Anfagswertproblems nach dem Anfangswert y 0 ”<br />

(Dabei wird die Zeit t als fester ”<br />

Parameter” behandelt.)<br />

➣ Zu betrachten ist, mit Evolution Φ s,t y = Φ(s, t,y)<br />

dy(t)<br />

dy 0<br />

∣ ∣∣∣t<br />

fest<br />

←→ ∂Φ<br />

∂y (t 0,t,y 0 ) .<br />

Autonome Differentialgleichung, D = R 3 ,<br />

σ,ρ, β ∈ R + :<br />

ẋ =σ(y − x) ,<br />

ẏ =x(ρ − z) − y ,<br />

ż =xy − βz .<br />

(1.3.22)<br />

d<br />

dy<br />

d<br />

dt Φt 0,t y = f(t,Φ<br />

t 0 ,t y) für festes y .<br />

(<br />

d ∂<br />

y)<br />

dy ∂t Φt0,t = d<br />

dy f(t,Φt0,t y)<br />

1.3<br />

p. 54<br />

1.3<br />

p. 56

−20<br />

σ = 10, ρ = 28, β = 2.666667e+00<br />

— : Anfangswert y 0 := (8, 9, 9.5) T<br />

— : Anfangswert y 0 := (8, 9, 9.5+10 −5 ) T<br />

3<br />

m 1<br />

= 2, m 2<br />

= 1, l 1<br />

= 1, l 2<br />

= 1.732051e+00<br />

3<br />

m 1<br />

= 2, m 2<br />

= 1, l 1<br />

= 1, l 2<br />

= 1.732051e+00<br />

45<br />

40<br />

35<br />

30<br />

Aus der Theorie der<br />

reellen dynamischen Systeme [18]:<br />

Lorenz-System ist chaotisches System<br />

2<br />

1<br />

2<br />

1<br />

z<br />

25<br />

20<br />

15<br />

10<br />

Anfängliche exponetielle Divergenz der<br />

beschränkten Trajektorien<br />

(Schranke (1.3.18) gilt für kleine T !)<br />

0<br />

−1<br />

0<br />

−1<br />

5<br />

−10<br />

0<br />

10<br />

x<br />

20 −30<br />

−20<br />

0<br />

−10<br />

y<br />

10<br />

20<br />

30<br />

Fig. 18<br />

Winzige Störungen der Anfangswerte<br />

➤ völlig verschiedene Zustände nach exponentiell<br />

kurzer Zeit”.<br />

”<br />

✸<br />

−2<br />

−3<br />

Fig. 20<br />

−4 −3 −2 −1 0 1 2 3 4<br />

θ 1 (0) = − π 2 , θ 2(0) = π, p 1 (0) = p 2 (0) = 0<br />

−2<br />

−3<br />

Fig. 21<br />

−4 −3 −2 −1 0 1 2 3 4<br />

θ 1 (0) = − π 2 , θ 2(0) = π + 10 −2 ,<br />

p 1 (0) = p 2 (0) = 0<br />

Ziel numerischer Simulation chaotischer dynamischer Systeme:<br />

Indentifikation des ”<br />

typischen” Verhaltens von Trajektorien<br />

[Simulation, MATLAB, ode45, Zeit [0, 20], Schrittweite 10 −3 ]<br />

✸<br />

★<br />

✥<br />

Essentiell:<br />

✧<br />

Beispiel 1.3.9 (Doppelpendel).<br />

Korrekte Behandlung von Erhaltungsgrössen, z.B. Gesamtenergie<br />

(→ Erste Integrale, Def. 1.2.1)<br />

✦<br />

1.3<br />

p. 57<br />

1.4 Polygonzugverfahren<br />

1.4<br />

p. 59<br />

l 2<br />

l 1<br />

θ 1<br />

θ 2<br />

m 1<br />

m 2<br />

Fig. 19<br />

✁<br />

(Mathematisches) Doppelpendel mit fester Aufhängung und masselosen<br />

Stäben.<br />

Minimalkoordinaten: Auslenkungswinkel θ 1 , θ 2<br />

Konfigurationsraum D = [0, 2π[ 2 (Torus)<br />

Hamilton-Funktion (→ Def. 1.2.2) = Summe kinetischer und potentieller<br />

Energie:<br />

H(p 1 ,p 2 ,θ 1 ,θ 2 ) =<br />

l 2 2 m 2p 2 1 + l2 1 (m 1 + m 2 )p 2 2 − 2m 2l 1 l 2 p 1 p 2 cos(θ 1 − θ 2 )<br />

2l 2 1 l2 2 m 2(m 1 + sin 2 (θ 1 − θ 2 )m 2 )<br />

− m 2 gl 2 cos θ 2 − (m 1 + m 2 )gl 1 cosθ 1 .<br />

Gegeben:<br />

Rechte Seite f : Ω ↦→ R d , lokal Lipschitz-stetig (→ Def. 1.3.2) auf<br />

erweitertem Zustandsraum Ω := I × D ⊂ R d+1<br />

Anfangsbedingungen y 0 ∈ D zum Anfangszeitpunkt t 0<br />

Thm. 1.3.4 (Peano & Picard-Lindelöf) ➤ Existenz & Eindeutigkeit von Lösungen (→ Def. 1.1.2)<br />

des AWP<br />

ẏ = f(t,y) , y(t 0 ) = y 0 . (1.4.1)<br />

Ziel: ☞ Approximation von y(T) für Endzeitpunkt T ∈ J(t 0 ,y 0 ) ✄ y h (T).<br />

☞ Approximation der Funktion t ↦→ y(t), t ∈ [t 0 , T], T ∈ J(t 0 ,y 0 ) ✄ t ↦→ y h (t).<br />

Beobachtung (in Experiment und Simulation):<br />

Extrem sensitive Abhängigkeit der Pendelbewegung von Anfangsbedingungen<br />

1.3<br />

p. 58<br />

1.4.1 Das explizite Euler-Verfahren (Euler 1768)<br />

Idee: ➊ ”<br />

Vorantasten” in der Zeit: (1.4.1) = Komposition von AWPe zu gegebenen<br />

kleinen Zeitintervallen [t k−1 , t k ], k = 1, ...,N, t N := T<br />

➋<br />

Approximation der zeitlokalen Lösungskurven durch Tangente im aktuellen<br />

1.4<br />

Anfangszeitpunkt. p.<br />

60

y<br />

y h (t 1 )<br />

y(t)<br />

y 0<br />

✁<br />

t<br />

t 0 t 1 Fig. 22<br />

Explizites Euler-Verfahren<br />

(Eulersches Polygonzugverfahren)<br />

Erster Schritt des expliziten Euler-Verfahrens<br />

(d = 1):<br />

Steigung der Tangente = f(t 0 ,y 0 )<br />

y h (t 1 ) ist Startwert für nächsten Schritt !<br />

In Formeln: durch explizites Eulerverfahren erzeugte Näherungen für y(t k ) erfüllen die Rekursion<br />

y k+1 := y h (t k+1 ) = y h (t k ) + h k f(t k ,y h (t k )) , k = 0,...,N − 1 , (1.4.2)<br />

mit lokaler (Zeit)schrittweite h k := t k+1 − t k .<br />

Beispiel 1.4.2 (Konvergenz(-geschwindigkeit) des expliziten Euler-Verfahrens).<br />

AWP für Riccati-Dgl. (1.1.2) auf [0, 1]<br />

Explizites Euler-Verfahren (1.4.2) mit<br />

uniformem Zeitschritt h = 1/n,<br />

n ∈ {5, 10, 20, 40, 80, 160, 320, 640}.<br />

Beobachtung:<br />

Fehler err h := |y(1) − y h (1)|<br />

Algebraische Konvergenz<br />

err h = O(h)<br />

error (Euclidean norm)<br />

10 0<br />

10 −1<br />

10 −2<br />

y0 = 0.10<br />

y0 = 0.20<br />

y0 = 0.40<br />

y0 = 0.80<br />

O(h)<br />

10 −3<br />

10 −3 10 −2 10 −1 10 0<br />

10 1 timestep h<br />

Fig. 24 ✸<br />

✎ Notation “Landau-O”:<br />

✎ Alternative Notation: y k := y h (t k )<br />

e(h) = O(g(h)) für h → 0 :⇔ ∃h 0 > 0, C > 0: |e(h)| ≤ Cg(h) ∀0 ≤ h ≤ h 0 .<br />

1.4<br />

p. 61<br />

1.4<br />

p. 63<br />

Veranschaulichung: Explizites Eulerverfahren<br />

Anfangswertproblem<br />

für<br />

Riccati-Differentialgleichung, siehe Bsp. 1.1.1<br />

y 0 = 2 1 , t 0 = 0, T = 1,<br />

gleichgrosse Zeitschritte h = 0.2<br />

ẏ = y 2 + t 2 . (1.1.2)<br />

↦→ ˆ= Richtungsfeld der Riccati-Dgl.<br />

✄<br />

y<br />

2.4<br />

2.2<br />

2<br />

1.8<br />

1.6<br />

1.4<br />

1.2<br />

1<br />

0.8<br />

0.6<br />

exact solution<br />

explicit Euler<br />

Bemerkung 1.4.1 (Explizites Eulerverfahren als Differenzenverfahren).<br />

0.4<br />

0 0.2 0.4 0.6 0.8 1 1.2 1.4<br />

t<br />

Fig. 23<br />

Definition 1.4.1 (Arten der Konvergenz).<br />

Sei err h der Diskretisierungsfehler eines Verfahrens zum Diskretisierungsparameter/Schrittweite<br />

h, h > 0.<br />

err h = O(h α ) :⇔ Algebraische Konvergenz der Ordnung α > 0<br />

err h = O(exp(−βh −γ )), :⇔ exponentielle Konvergenz, falls β,γ > 0<br />

Fehlerplots bei algebraischer Konvergenz (h i = (3/2) −i , i = 1, ...,10)<br />

(1.4.2) aus Approximation von Ableitung<br />

dt d durch Vorwärtsdifferenzenquotienten auf Zeitgitter G :=<br />

{t 0 , t 1 ,...,t N }:<br />

ẏ = f(t,y) ←→ y h(t k+1 ) − y h (t k )<br />

h k<br />

= f(t k ,y h (t k )) , k = 0,...,N − 1 .<br />

Frage: Wie genau ist die Näherungslösung ?<br />

△<br />

1.4<br />

p. 62<br />

1.4<br />

p. 64

0 0.1 0.2 0.3 0.4 0.5 0.6 0.7<br />

0.9<br />

0.8<br />

0.7<br />

α = 1/2<br />

α = 1<br />

α = 2<br />

Error plots for algebraic convergence (linear scale)<br />

10 0 Error plots for algebraic convergence (log scale<br />

10 −1<br />

Error plots for exponential convergence (h −γ lin−log scale)<br />

10 0 β = 0.5, γ = 0.5<br />

10 −1<br />

β = 1.0, γ = 0.5<br />

β = 2.0, γ = 0.5<br />

β = 1.0, γ = 1.0<br />

10 −2<br />

β = 1.0, γ = 1/3<br />

error<br />

0.6<br />

0.5<br />

0.4<br />

0.3<br />

0.2<br />

error<br />

10 −2<br />

10 −3<br />

error<br />

10 −3<br />

10 −4<br />

10 −5<br />

10 −6<br />

10 −7<br />

10 −8<br />

✁ (h −γ<br />

i , ǫ i ) (h i ˆ= Schrittweiten, ǫ i ˆ= zugehörige<br />

Diskretisierungsfehler ) liegen auf Geraden mit<br />

Steigung −β<br />

0.1<br />

0<br />

h<br />

lineare Skalen<br />

Fig. 25<br />

α = 1/2<br />

α = 1<br />

α = 2<br />

10 −4<br />

10 −2 10 −1 10 0<br />

h<br />

Fig. 26<br />

logarithmische Skalen<br />

10 −9<br />

10 −10<br />

0 5 10 15 20 25 30<br />

h −γ<br />

Fig. 29<br />

Beispiel 1.4.3 (Explizites Euler-Verfahren für logistische Dgl.).<br />

Fehlerplots bei exponentieller Konvergenz (h i = (3/2) −i , i = 1, ...,10)<br />

Anfangswertproblem für logistische Differentialgleichung, siehe Bsp. 1.2.1<br />

1.4<br />

p. 65<br />

ẏ = λy(1 − y) , y(0) = 0.01 .<br />

Explizites Euler-Verfahren (1.4.2) mit uniformem Zeitschritt h = 1/n,<br />

n ∈ {5, 10, 20, 40, 80, 160, 320, 640}.<br />

Fehler zum Endzeitpunkt T = 1<br />

1.4<br />

p. 67<br />

0.7<br />

0.6<br />

Error plots for exponential convergence (linear scale)<br />

β = 0.5, γ = 0.5<br />

β = 1.0, γ = 0.5<br />

β = 2.0, γ = 0.5<br />

β = 1.0, γ = 1.0<br />

β = 1.0, γ = 1/3<br />

10 0 Error plots for exponential convergence (log scale)<br />

10 −1<br />

10 −2<br />

10 0<br />

λ = 1.000000<br />

λ = 3.000000<br />

λ = 6.000000<br />

λ = 9.000000<br />

10 120<br />

10 100<br />

λ = 10.000000<br />

λ = 30.000000<br />

λ = 60.000000<br />

λ = 90.000000<br />

error<br />

0.5<br />

0.4<br />

0.3<br />

0.2<br />

error<br />

10 −3<br />

10 −4<br />

10 −5<br />

10 −6<br />

10 −7<br />

error (Euclidean norm)<br />

10 1 timestep h<br />

10 −1<br />

10 −2<br />

10 −3<br />

error (Euclidean norm)<br />

10 140 timestep h<br />

10 80<br />

10 60<br />

10 40<br />

10 20<br />

0.1<br />

0<br />

0 0.1 0.2 0.3 0.4 0.5 0.6 0.7<br />

h<br />

Fig. 27<br />

lineare Skalen<br />

10 −8<br />

β = 0.5, γ = 0.5<br />

β = 1.0, γ = 0.5<br />

β = 2.0, γ = 0.5<br />

10 −9<br />

β = 1.0, γ = 1.0<br />

β = 1.0, γ = 1/3<br />

10 −10<br />

h<br />

Fig. 28<br />

10 −2 10 −1 10 0<br />

logarithmische Skalen<br />

10 −4<br />

10 −5<br />

10 −3 10 −2 10 −1 10 0<br />

λ klein: O(h)-Konvergenz (asymptotisch)<br />

Fig. 30<br />

10 0<br />

10 −20<br />

10 −3 10 −2 10 −1 10 0<br />

λ gross: Explosion von y k für grosse<br />

Zeitschrittweiten h<br />

Fig. 31<br />

1.4<br />

p. 66<br />

1.4<br />

p. 68

0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1<br />

1.4<br />

Anwendung auf kleine Zeitintervalle [t 0 ,t 1 ], [t 1 ,t 2 ], ..., [t N−1 , t N ] ➤ implizites Euler-Verfahren<br />

y<br />

1.2<br />

1<br />

0.8<br />

0.6<br />

0.4<br />

0.2<br />

0<br />

−0.2<br />

−0.4<br />

exact solution<br />

explicit Euler<br />

✁ λ = 90, — ˆ= exakte Lösung, — ˆ= Eulerpolygon<br />

y k schiessen über den stark attraktiven<br />

Fixpunkt y = 1 hinaus.<br />

➥ Beobachtung: exponentiell anwachsende<br />

Oszillationen der y k<br />

durch implizites Eulerverfahren erzeugte Näherung für y(t k ) erfüllt<br />

y k+1 := y h (t k+1 ) = y h (t k ) + h k f(t k+1 ,y k+1 ) , k = 0,...,N − 1 , (1.4.9)<br />

mit lokaler (Zeit)schrittweite h k := t k+1 − t k .<br />

Beachte: (1.4.9) erfordert Auflösen einer (evtl. nichtlinearen) Gleichung nach y k+1 !<br />

(➤ Terminologie ”<br />

implizit”)<br />

Bemerkung 1.4.4 (Implizites Eulerverfahren als Differenzenverfahren).<br />

t<br />

Fig. 32<br />

✸<br />

(1.4.9) aus Approximation der Zeitableitung<br />

dt d durch Rückwärtsdifferenzenquotienten auf Zeitgitter<br />

G := {t 0 , t 1 ,...,t N }:<br />

Einsicht durch Modellproblemanalyse: einfachste Dgl. mit stark attraktivem Fixpunkt y = 0<br />

Homogene lineare skalare Dgl., Sect. 1.3.2 : ẏ = f(y) := λy , λ < 0 . (1.4.6)<br />

ẏ = λy , y(0) = y 0 ⇒ y(t) = y 0 exp(λt) → 0 für t → ∞ . (1.4.7)<br />

ẏ = f(t,y) ←→ y h(t k+1 ) − y h (t k )<br />

h k<br />

= f(t k+1 ,y h (t k+1 )) , k = 0,...,N − 1 .<br />

△<br />

Rekursion des expliziten Eulerverfahrens für (1.4.6) (uniforme Zeitschrittweite h > 0)<br />

Beispiel 1.4.5 (Implizites Eulerverfahren für logistische Differentialgleichung). → Bps. 1.4.3<br />

(1.4.2) for f(y) = λy: y k+1 = y k (1 + λh) . (1.4.8)<br />

1.4<br />

p. 69<br />

Wiederholung der numerischen Experimente aus Beispiel 1.4.3 für implizites Eulerverfahren (1.4.9):<br />

1.4<br />

p. 71<br />

y k = y 0 (1 + λh) k ⇒ |y k | →<br />

{<br />

0 , wenn λh > −2 (qualitativ richtig) ,<br />

∞ , wenn λh < −2 (qualitativ falsch) .<br />

10 0<br />

λ = 1.000000<br />

λ = 3.000000<br />

λ = 6.000000<br />

λ = 9.000000<br />

O(h)<br />

10 0<br />

10 −2<br />

λ = 10.000000<br />

λ = 30.000000<br />

λ = 60.000000<br />

λ = 90.000000<br />

O(h)<br />

1.4.2 Das implizite Euler-Verfahren<br />

error (Euclidean norm)<br />

10 −1<br />

10 −2<br />

10 −3<br />

error (Euclidean norm)<br />

10 −4<br />

10 −6<br />

10 −8<br />

10 −10<br />

10 −12<br />

10 −4<br />

10 −14<br />

Wie vermeidet man das Überschiessen des expliziten Eulerverfahrens bei stark attraktiven Fixpunkten<br />

und grossen Zeitschrittweiten ?<br />

y<br />

y h (t 1 ) y(t)<br />

y 0<br />

t<br />

t 0 t 1 Fig. 33<br />

Idee: Approximiere Lösung durch (t 0 , y 0 ) auf<br />

[t 0 ,t 1 ] durch<br />

• Strecke duch (t 0 , y 0 )<br />

• mit Steigung f(t 1 , y 1 )<br />

✁ — ˆ= Lösungkurve durch (t 0 , y 0 ),<br />

— ˆ= Lösungkurve durch (t 1 , y 1 ),<br />

— ˆ= Tangente an — in (t 1 ,y 1 ).<br />

1.4<br />

p. 70<br />

10 1 timestep h<br />

10 −5<br />

10 −3 10 −2 10 −1 10 0<br />

λ klein: O(h)-Konvergenz (asymptotisch)<br />

Fig. 34<br />

Modellproblemanalyse (wie in Abschnitt 1.4.1):<br />

( ) 1 k<br />

y k = y 0 ⇒ |y<br />

1 − λh k | →<br />

10 2 timestep h<br />

10 −16<br />

10 −3 10 −2 10 −1 10 0<br />

Fig. 35<br />

λ gross: stabil für alle Zeitschrittweiten h !<br />

(1.4.9) for f(y) = λy: y k+1 = y k<br />

1<br />

1 − λh . (1.4.10)<br />

⎧<br />

⎪⎨ 0 , wenn λh < 0 (qualitativ richtig) ,<br />

∞ , wenn 0 < λh < 1 (qualitativ richtig) ,<br />

⎪⎩<br />

∞ , wenn λh > 1 (Oszillationen, qualitativ falsch) .<br />

✸<br />

1.4<br />

p. 72

p<br />

p<br />

p<br />

Beispiel 1.4.6 (Euler-Verfahren für Pendelgleichung).<br />

Mathematisches Pendel → Bsp. 1.2.7: Hamiltonsche Form (1.2.11) der Bewegungsgleichungen<br />

Winkelgeschwindigkeit p := ˙α ⇒ d ( ) ( )<br />

α p<br />

=<br />

dt p − g l sin α , g = 9.8, l = 1 . (1.2.11)<br />

Approximative numerische Lösung mit explizitem/implizitem Eulerverfahren (1.4.2)/(1.4.9),<br />

Konstante Zeitschrittweite h = T/N, T = 5 Endzeitpunkt, N ∈ {50, 100, 200},<br />

2<br />

1.5<br />

1<br />

0.5<br />

0<br />

Erstes Integral (→ Def. 1.2.1):<br />

I(y) = ‖y‖<br />

(Bewegung mit konstanter Geschwindigkeit auf Kreisbahn)<br />

40 timesteps on [0,10.000000]<br />

160 timesteps on [0,10.000000]<br />

1.5<br />

exact solution<br />

exact solution<br />

explicit Euler<br />

explicit Euler<br />

implicit Euler<br />

implicit Euler<br />

1<br />

0.5<br />

Startwert: α(0) = π/4, p(0) = 0.<br />

y 2<br />

−0.5<br />

−1<br />

y 2<br />

0<br />

−1.5<br />

−0.5<br />

6<br />

4<br />

exact solution<br />

explicit Euler<br />

implicit Euler<br />

50 timesteps on [0,5.000000]<br />

6<br />

4<br />

100 timesteps on [0,5.000000]<br />

4<br />

3<br />

200 timesteps on [0,5.000000]<br />

−2<br />

−2.5<br />

−1<br />

2<br />

2<br />

0<br />

2<br />

0<br />

1<br />

0<br />

−3<br />

−4 −3 −2 −1 0 1 2<br />

y 1<br />

3<br />

Fig. 41<br />

−1.5<br />

−1.5 −1 −0.5 0<br />

y 1<br />

0.5 1 1.5<br />

Fig. 42<br />

−2<br />

−4<br />

−6<br />

−8<br />

−10 −8 −6 −4 −2 0 2 4<br />

α<br />

−2<br />

−4<br />

exact solution<br />

explicit Euler<br />

implicit Euler<br />

Fig. 36<br />

−6<br />

−2 −1.5 −1 −0.5 0 0.5 1 1.5 2 2.5<br />

Fig. 37<br />

−4<br />

−1.5 −1 −0.5 0 0.5 1 1.5<br />

Fig. 38<br />

α<br />

−1<br />

−2<br />

−3<br />

exact solution<br />

explicit Euler<br />

implicit Euler<br />

α<br />

☞ Expliziter Euler: Numerische Lösung wird aus der Kurve getragen”<br />

”<br />

☞ Impliziter Euler: Numerische Lösung stürzt ins Zentrum”<br />

”<br />

✸<br />

Verhalten der approximativen Energien: kinetische Enegie : E kin (t) = 1 2 p(t)2<br />

1.4<br />

potentielle Energie : E pot (t) = − g l cosα(t) p. 73<br />

9<br />

8<br />

Energies for explicit Euler discrete evolution<br />

kinetic energy<br />

potential energy<br />

total energy<br />

3<br />

Energies for implicit Euler discrete evolution<br />

kinetic energy<br />

potential energy<br />

total energy<br />

1.4.3 Implizite Mittelpunktsregel<br />

1.4<br />

p. 75<br />

7<br />

6<br />

2.5<br />

2<br />

Wie vermeidet man die Energiedrift für explizites/implizites Euler-Verfahren angewandt auf konservative<br />

Systeme ?<br />

energy<br />

5<br />

4<br />

3<br />

2<br />

1<br />

0<br />

0 0.5 1 1.5 2 2.5 3 3.5 4 4.5 5<br />

time t<br />

Fig. 39<br />

☞ Expliziter Euler: Anwachsen der Gesamtenergie des Pendels<br />

☞ Impliziter Euler: Pendel kommt zur Ruhe ( numerische Reibung”)<br />

”<br />

Beispiel 1.4.7 (Eulerverfahren für längenerhaltende Evolution).<br />

Anfagswertproblem für , D = R 2 :<br />

( )<br />

y2<br />

ẏ =<br />

−y 1<br />

, y(0) = y 0 ➤ y(t) =<br />

energy<br />

1.5<br />

1<br />

0.5<br />

0<br />

0 0.5 1 1.5 2 2.5 3 3.5 4 4.5 5<br />

time t<br />

Fig. 40<br />

( )<br />

cost sint<br />

y<br />

− sin t cost 0 .<br />

✸<br />

1.4<br />

p. 74<br />

y<br />

y ∗ y h (t 1 )<br />

y 0<br />

t 0 t 1<br />

t ∗ f(t ∗ ,y ∗ )<br />

t<br />

Fig. 43<br />

Idee: Approximiere Lösung durch (t 0 ,y 0 ) auf<br />

[t 0 ,t 1 ] durch<br />

• lineares Polynom durch (t 0 ,y 0 )<br />

• mit Steigung f(t ∗ ,y ∗ ),<br />

t ∗ := 1 2 (t 0 + t 1 ), y ∗ = 1 2 (y 0 + y 1 )<br />

✁ — ˆ= Lösungkurve durch (t 0 , y 0 ),<br />

— ˆ= Lösungkurve durch (t ∗ , y ∗ ),<br />

— ˆ= Tangente an — in (t ∗ ,y ∗ ).<br />

Anwendung auf kleine Zeitintervalle [t 0 ,t 1 ], [t 1 , t 2 ], . .., [t N−1 , t N ] ➤ implizite Mittelpunktsregel<br />

durch implizite Mittelpunktsregel erzegte Näherung y k+1 für y(t k ) erfüllt<br />

y k+1 := y h (t k+1 ) = y k + h k f( 1 2 (t k + t k+1 ), 1 2 (y k + y k+1 )) , k = 0, ...,N − 1 , (1.4.11)<br />

mit lokaler (Zeit)schrittweite h k := t k+1 − t k . p. 76<br />

1.4

p<br />

p<br />

p<br />

Beachte: (1.4.11) erfordert Auflösen einer (evtl. nichtlinearen) Gleichung nach y k+1 !<br />

(➤ Terminologie ”<br />

implizit”)<br />

Bemerkung 1.4.8 (Implizite Mittelpunktsregel als Differenzenverfahren).<br />

2<br />

1.5<br />

1<br />

exact solution<br />

explicit Euler<br />

implicit Euler<br />

implicit midpoint<br />

40 timesteps on [0,10.000000]<br />

1.5<br />

1<br />

exact solution<br />

explicit Euler<br />

implicit Euler<br />

implicit midpoint<br />

160 timesteps on [0,10.000000]<br />

(1.4.11) aus Approximation der Zeitableitung<br />

dt d durch zentralen Differenzenquotienten auf Zeitgitter<br />

G := {t 0 , t 1 ,...,t N }:<br />

ẏ = f(t,y) ←→ y h(t k+1 ) − y h (t k )<br />

h k<br />

= f( 1 2 (t k + t k+1 ), 1 2 (y h(t k ) + y(t k+1 )), k = 0, ...,N − 1 .<br />

Beispiel 1.4.9 (Implizite Mittelpunktsregel für logistische Dgl.).<br />

△<br />

y 2<br />

0.5<br />

0<br />

−0.5<br />

−1<br />

−1.5<br />

−2<br />

−2.5<br />

−3<br />

−4 −3 −2 −1 0 1 2<br />

y 1<br />

3<br />

Fig. 46<br />

y 2<br />

0.5<br />

0<br />

−0.5<br />

−1<br />

−1.5<br />

−1.5 −1 −0.5 0<br />

y 1<br />

0.5 1 1.5<br />

Fig. 47<br />

Wiederholung der numerischen Experimente aus Beispiel 1.4.3 für implizite Mittelpunktsregel (1.4.11):<br />

☞ Implizite Mittelpunktsregel: Perfekte Längenerhaltung !<br />

✸<br />

✬<br />

Lemma 1.4.2 (Erhaltung quadratischer erster Integrale durch implizite Mittelpunktsregel).<br />

Falls I : D ⊂ R d ↦→ R, I(y) := 2 1yT Ay, A ∈ R d,d , erstes Integral (→ Def. 1.2.1) der<br />

autonomen Dgl. ẏ = f(y) mit global differenzierbarer rechter Seite f : D ↦→ R d , dann gilt<br />

✩<br />

1.4<br />

p. 77<br />

✫<br />

I(y k ) = I(y 0 ) ∀k ∈ Z für y k gemäss (1.4.11)<br />

Beispiel 1.4.11 (Implizite Mittelpunktsregel für Pendelgleichung).<br />

✪<br />

1.4<br />

p. 79<br />

10 −1<br />

10 −2<br />

error (Euclidean norm)<br />

10 −3<br />

10 −4<br />

10 −5<br />

10 −6<br />

10 −6<br />

10 −8<br />

10 −10<br />

10 −7<br />

10 −8<br />

λ = 1.000000<br />

λ = 2.000000<br />

λ = 5.000000<br />

λ = 10.000000<br />

10 −12<br />

10 −14<br />

10 0 timestep h<br />

10 −2<br />

10 −4<br />

error (Euclidean norm)<br />

λ = 10.000000<br />

λ = 20.000000<br />

λ = 50.000000<br />

λ = 90.000000<br />

O(h 2 )<br />

10 −9<br />

10 −3 10 −2 10 −1 10 0<br />

Fig. 44<br />

λ klein: O(h 2 )-Konvergenz (asymptotisch)<br />

10 0 timestep h<br />

Anfangswertproblem und numerische Experimente wie in Bsp. 1.4.6<br />

6<br />

4<br />

2<br />

0<br />

exact solution<br />

explicit Euler<br />

implicit Euler<br />

implicit midpoint<br />

50 timesteps on [0,5.000000]<br />

6<br />

4<br />

2<br />

100 timesteps on [0,5.000000]<br />

4<br />

3<br />

2<br />

1<br />

200 timesteps on [0,5.000000]<br />

−2<br />

−4<br />

0<br />

−2<br />

0<br />

−1<br />

−2<br />

O(h 2 )<br />

10 −16<br />

10 −3 10 −2 10 −1 10 0<br />

Fig. 45<br />

λ gross: stabil für alle Zeitschrittweiten h ! ✸<br />

−6<br />

−8<br />

−10 −8 −6 −4 −2 0 2 4<br />

α<br />

−4<br />

exact solution<br />

explicit Euler<br />

implicit Euler<br />

implicit midpoint<br />

Fig. 48<br />

−6<br />

−2 −1.5 −1 −0.5 0 0.5 1 1.5 2 2.5<br />

Fig. 49<br />

−4<br />

−1.5 −1 −0.5 0 0.5 1 1.5<br />

Fig. 50<br />

α<br />

−3<br />

exact solution<br />

explicit Euler<br />

implicit Euler<br />

implicit midpoint<br />

α<br />

Beispiel 1.4.10 (Implizite Mittelpunktregel für Kreisbewegung).<br />

1.4<br />

p. 78<br />

1.4<br />

p. 80

0 0.5 1 1.5 2 2.5 3 3.5 4 4.5 5<br />

3<br />

Energies for implicit midpoint discrete evolution<br />

Bemerkung 1.4.12 (Störmer-Verlet-Verfahren als Differenzenverfahren).<br />

energy<br />

2.5<br />

2<br />

1.5<br />

1<br />

0.5<br />

kinetic energy<br />

potential energy<br />

total energy<br />

0<br />

time t<br />

Fig. 51<br />

✁ Verhalten der Energien bei numerischer<br />

Integration mit impliziter Mittelpunktsregel<br />

(1.4.11), N = 50.<br />

Keine (sichtbare) Energiedrift im Vergleich zu<br />

Euler-Verfahren (trotz grosser Zeitschritte)<br />

✸<br />

(1.4.14) aus Approximation der zweiten Zeitableitung durch zweiten zentralen Differenzenquotienten<br />

auf Zeitgitter G := {t 0 ,t 1 , ...,t N }: für uniforme Zeitschrittweite h > 0<br />

ÿ = f(y) ←→<br />

y h (t k+1 )−y h (t k )<br />

h − y h(t k )−y h (t k−1 )<br />

h = y h(t k+1 ) − 2y h (t k ) + y h (t k−1 )<br />

h<br />

h 2 = f(y h (t k )) .<br />

Bemerkung 1.4.13 (Startschritt für Störmer-Verlet-Verfahren).<br />

Anfangswerte für (1.4.12), siehe Bem. 1.1.6: y(0) = y 0 , ẏ(0) = v 0<br />

△<br />

1.4.4 Störmer-Verlet-Verfahren [13]<br />

Benutze virtuellen Zeitpunkt t −1 := t 0 − h 0<br />

Wende (1.4.14) an auf [t −1 , t 1 ]:<br />

?<br />

Übertragung der Idee der Euler-Verfahren (→ Sect. 1.4.1, 1.4.2) auf Differentialgleichungen 2.<br />

Ordnung<br />

ÿ = f(t,y) . (1.4.12)<br />

1.4<br />

p. 81<br />

Zentraler Differenzenquotient auf [t −1 , t 1 ]:<br />

y 1 = −y −1 + 2y 0 + h 2 0 f(t 0,y 0 ) . (1.4.15)<br />

y 1 − y −1<br />

2h 0<br />

= v 0 . (1.4.16)<br />

1.4<br />

p. 83<br />

Gegeben y k−1 ≈ y(t k−1 ), y k ≈ y(t k ) approximiere y(t) auf [t k−1 ,t k+1 ] durch<br />

• Parabel p(t) durch (t k−1 ,y k−1 ), (t k ,y k ) (∗),<br />

• mit<br />

¨p(t k ) = f(y k ) (∗).<br />

Berechne y 1 aus (1.4.15) & (1.4.16)<br />

Beispiel 1.4.14 (Störmer-Verlet-Verfahren für Pendelgleichung).<br />

△<br />

(∗) ➜<br />

Parabel eindeutig bestimmt.<br />

y k+1 := p(t k+1 ) ≈ y(t k+1 )<br />

(1.4.14) angewandt auf (1.2.10)<br />

Startschritt gemäss Bem. 1.4.13<br />

5<br />

4<br />

3<br />

Pendulum g = 9.800000, l = 1.000000,α(0)=1.570796,p(0)=0.000000<br />

Störmer-Verlet-Verfahren für (1.4.12) (Zeitgitter G := {t 0 ,t 1 , ...,t N }):<br />

y k+1 = − h (<br />

k<br />

y<br />

h k−1 + 1 + h )<br />

k<br />

y<br />