O+P Fluidtechnik 7-8/2023

O+P Fluidtechnik 7-8/2023

O+P Fluidtechnik 7-8/2023

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

INTERVIEW<br />

Herr Makansi, Sie haben Ihre Ideen für ein Forschungsvorhaben<br />

zur agentenbasierten Regelung und Steuerung von Fluidsystemen<br />

bereits mehrfach einem Fachpublikum vorgestellt. Was ist<br />

kurz gesagt der Kern Ihres Ansatzes? Wer sind die Agenten? Was<br />

ist das Ziel?<br />

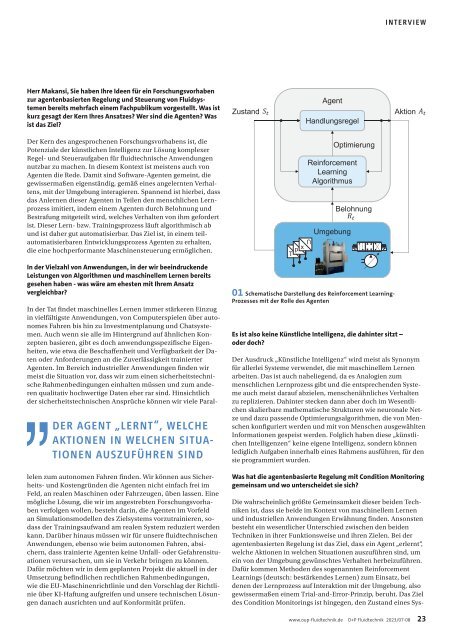

Zustand<br />

Agent<br />

Handlungsregel<br />

Aktion<br />

Der Kern des angesprochenen Forschungsvorhabens ist, die<br />

Potenziale der künstlichen Intelligenz zur Lösung komplexer<br />

Regel- und Steueraufgaben für fluidtechnische Anwendungen<br />

nutzbar zu machen. In diesem Kontext ist meistens auch von<br />

Agenten die Rede. Damit sind Software-Agenten gemeint, die<br />

gewissermaßen eigenständig, gemäß eines angelernten Verhaltens,<br />

mit der Umgebung interagieren. Spannend ist hierbei, dass<br />

das Anlernen dieser Agenten in Teilen den menschlichen Lernprozess<br />

imitiert, indem einem Agenten durch Belohnung und<br />

Bestrafung mitgeteilt wird, welches Verhalten von ihm gefordert<br />

ist. Dieser Lern- bzw. Trainingsprozess läuft algorithmisch ab<br />

und ist daher gut automatisierbar. Das Ziel ist, in einem teilautomatisierbaren<br />

Entwicklungsprozess Agenten zu erhalten,<br />

die eine hochperformante Maschinensteuerung ermöglichen.<br />

T<br />

p x<br />

U<br />

U<br />

Reinforcement<br />

Learning<br />

Algorithmus<br />

U<br />

Umgebung<br />

Optimierung<br />

Belohnung<br />

In der Vielzahl von Anwendungen, in der wir beeindruckende<br />

Leistungen von Algorithmen und maschinellem Lernen bereits<br />

gesehen haben - was wäre am ehesten mit Ihrem Ansatz<br />

vergleichbar?<br />

DER AGENT „LERNT“, WELCHE<br />

AKTIONEN IN WELCHEN SITUA-<br />

TIONEN AUSZUFÜHREN SIND<br />

In der Tat findet maschinelles Lernen immer stärkeren Einzug<br />

in vielfältigste Anwendungen, von Computerspielen über autonomes<br />

Fahren bis hin zu Investmentplanung und Chatsystemen.<br />

Auch wenn sie alle im Hintergrund auf ähnlichen Konzepten<br />

basieren, gibt es doch anwendungsspezifische Eigenheiten,<br />

wie etwa die Beschaffenheit und Verfügbarkeit der Daten<br />

oder Anforderungen an die Zuverlässigkeit trainierter<br />

Agenten. Im Bereich industrieller Anwendungen finden wir<br />

meist die Situation vor, dass wir zum einen sicherheitstechnische<br />

Rahmenbedingungen einhalten müssen und zum anderen<br />

qualitativ hochwertige Daten eher rar sind. Hinsichtlich<br />

der sicherheitstechnischen Ansprüche können wir viele Parallelen<br />

zum autonomen Fahren finden. Wir können aus Sicherheits-<br />

und Kostengründen die Agenten nicht einfach frei im<br />

Feld, an realen Maschinen oder Fahrzeugen, üben lassen. Eine<br />

mögliche Lösung, die wir im angestrebten Forschungsvorhaben<br />

verfolgen wollen, besteht darin, die Agenten im Vorfeld<br />

an Simulationsmodellen des Zielsystems vorzutrainieren, sodass<br />

der Trainingsaufwand am realen System reduziert werden<br />

kann. Darüber hinaus müssen wir für unsere fluidtechnischen<br />

Anwendungen, ebenso wie beim autonomen Fahren, absichern,<br />

dass trainierte Agenten keine Unfall- oder Gefahrensituationen<br />

verursachen, um sie in Verkehr bringen zu können.<br />

Dafür möchten wir in dem geplanten Projekt die aktuell in der<br />

Umsetzung befindlichen rechtlichen Rahmenbedingungen,<br />

wie die EU-Maschinenrichtlinie und den Vorschlag der Richtlinie<br />

über KI-Haftung aufgreifen und unsere technischen Lösungen<br />

danach ausrichten und auf Konformität prüfen.<br />

01 Schematische Darstellung des Reinforcement Learning-<br />

Prozesses mit der Rolle des Agenten<br />

Es ist also keine Künstliche Intelligenz, die dahinter sitzt –<br />

oder doch?<br />

Der Ausdruck „Künstliche Intelligenz“ wird meist als Synonym<br />

für allerlei Systeme verwendet, die mit maschinellem Lernen<br />

arbeiten. Das ist auch naheliegend, da es Analogien zum<br />

menschlichen Lernprozess gibt und die entsprechenden Systeme<br />

auch meist darauf abzielen, menschenähnliches Verhalten<br />

zu replizieren. Dahinter stecken dann aber doch im Wesentlichen<br />

skalierbare mathematische Strukturen wie neuronale Netze<br />

und dazu passende Optimierungsalgorithmen, die von Menschen<br />

konfiguriert werden und mit von Menschen ausgewählten<br />

Informationen gespeist werden. Folglich haben diese „künstlichen<br />

Intelligenzen“ keine eigene Intelligenz, sondern können<br />

lediglich Aufgaben innerhalb eines Rahmens ausführen, für den<br />

sie programmiert wurden.<br />

Was hat die agentenbasierte Regelung mit Condition Monitoring<br />

gemeinsam und wo unterscheidet sie sich?<br />

Die wahrscheinlich größte Gemeinsamkeit dieser beiden Techniken<br />

ist, dass sie beide im Kontext von maschinellem Lernen<br />

und industriellen Anwendungen Erwähnung finden. Ansonsten<br />

besteht ein wesentlicher Unterschied zwischen den beiden<br />

Techniken in ihrer Funktionsweise und ihren Zielen. Bei der<br />

agentenbasierten Regelung ist das Ziel, dass ein Agent „erlernt“,<br />

welche Aktionen in welchen Situationen auszuführen sind, um<br />

ein von der Umgebung gewünschtes Verhalten herbeizuführen.<br />

Dafür kommen Methoden des sogenannten Reinforcement<br />

Learnings (deutsch: bestärkendes Lernen) zum Einsatz, bei<br />

denen der Lernprozess auf Interaktion mit der Umgebung, also<br />

gewissermaßen einem Trial-and-Error-Prinzip, beruht. Das Ziel<br />

des Condition Monitorings ist hingegen, den Zustand eines Sys-<br />

www.oup-fluidtechnik.de <strong>O+P</strong> <strong>Fluidtechnik</strong> <strong>2023</strong>/07-08 23