22,2 MB - RegJo

22,2 MB - RegJo

22,2 MB - RegJo

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

14 professorengespräch regjo südniedersachsen<br />

regjo südniedersachsen Professorengespräch 15<br />

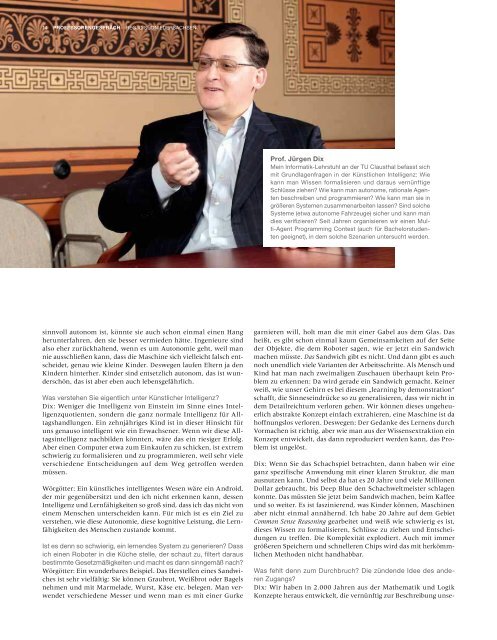

Prof. Jürgen Dix<br />

Mein Informatik-Lehrstuhl an der TU Clausthal befasst sich<br />

mit Grundlagenfragen in der Künstlichen Intelligenz: Wie<br />

kann man Wissen formalisieren und daraus vernünftige<br />

Schlüsse ziehen? Wie kann man autonome, rationale Agenten<br />

beschreiben und programmieren? Wie kann man sie in<br />

größeren Systemen zusammenarbeiten lassen? Sind solche<br />

Systeme (etwa autonome Fahrzeuge) sicher und kann man<br />

dies verifizieren? Seit Jahren organisieren wir einen Multi-Agent<br />

Programming Contest (auch für Bachelorstudenten<br />

geeignet), in dem solche Szenarien untersucht werden.<br />

Prof. Florentin Wörgötter<br />

Wir arbeiten im Bereich Computational Neuroscience an der<br />

Universität Göttingen in erster Linie an Fragen der theoretischen<br />

Hirnforschung: Wie kann das Nervensystem von Tieren<br />

und Menschen komplexe Szenen „verstehen“ und daraus<br />

Handlungen ableiten? Wie schafft es das Nervensystem<br />

zu lernen, das Verhalten zu verbessern? Dies sind die zentralen<br />

Probleme, mit denen sich unser Lehrstuhl auseinandersetzt.<br />

Dies führt auch direkt zu dem Versuch, das Verhalten<br />

von Lebewesen mit Maschinen (Robotern) nachzuahmen,<br />

wobei sich hier sofort die Frage nach Autonomie und Intelligenz<br />

künstlicher Agenten in den Vordergrund drängt.<br />

sinnvoll autonom ist, könnte sie auch schon einmal einen Hang<br />

herunterfahren, den sie besser vermieden hätte. Ingenieure sind<br />

also eher zurückhaltend, wenn es um Autonomie geht, weil man<br />

nie ausschließen kann, dass die Maschine sich vielleicht falsch entscheidet,<br />

genau wie kleine Kinder. Deswegen laufen Eltern ja den<br />

Kindern hinterher. Kinder sind entsetzlich autonom, das ist wunderschön,<br />

das ist aber eben auch lebensgefährlich.<br />

Was verstehen Sie eigentlich unter Künstlicher Intelligenz?<br />

Dix: Weniger die Intelligenz von Einstein im Sinne eines Intelligenzquotienten,<br />

sondern die ganz normale Intelligenz für Alltagshandlungen.<br />

Ein zehnjähriges Kind ist in dieser Hinsicht für<br />

uns genauso intelligent wie ein Erwachsener. Wenn wir diese Alltagsintelligenz<br />

nachbilden könnten, wäre das ein riesiger Erfolg.<br />

Aber einen Computer etwa zum Einkaufen zu schicken, ist extrem<br />

schwierig zu formalisieren und zu programmieren, weil sehr viele<br />

verschiedene Entscheidungen auf dem Weg getroffen werden<br />

müssen.<br />

Wörgötter: Ein künstliches intelligentes Wesen wäre ein Android,<br />

der mir gegenübersitzt und den ich nicht erkennen kann, dessen<br />

Intelligenz und Lernfähigkeiten so groß sind, dass ich das nicht von<br />

einem Menschen unterscheiden kann. Für mich ist es ein Ziel zu<br />

verstehen, wie diese Autonomie, diese kognitive Leistung, die Lernfähigkeiten<br />

des Menschen zustande kommt.<br />

Ist es denn so schwierig, ein lernendes System zu generieren? Dass<br />

ich einen Roboter in die Küche stelle, der schaut zu, filtert daraus<br />

bestimmte Gesetzmäßigkeiten und macht es dann sinngemäß nach?<br />

Wörgötter: Ein wunderbares Beispiel. Das Herstellen eines Sandwiches<br />

ist sehr vielfältig: Sie können Graubrot, Weißbrot oder Bagels<br />

nehmen und mit Marmelade, Wurst, Käse etc. belegen. Man verwendet<br />

verschiedene Messer und wenn man es mit einer Gurke<br />

garnieren will, holt man die mit einer Gabel aus dem Glas. Das<br />

heißt, es gibt schon einmal kaum Gemeinsamkeiten auf der Seite<br />

der Objekte, die dem Roboter sagen, wie er jetzt ein Sandwich<br />

machen müsste. Das Sandwich gibt es nicht. Und dann gibt es auch<br />

noch unendlich viele Varianten der Arbeitsschritte. Als Mensch und<br />

Kind hat man nach zweimaligen Zuschauen überhaupt kein Problem<br />

zu erkennen: Da wird gerade ein Sandwich gemacht. Keiner<br />

weiß, wie unser Gehirn es bei diesem „learning by demonstration“<br />

schafft, die Sinneseindrücke so zu generalisieren, dass wir nicht in<br />

dem Detailreichtum verloren gehen. Wir können dieses ungeheuerlich<br />

abstrakte Konzept einfach extrahieren, eine Maschine ist da<br />

hoffnungslos verloren. Deswegen: Der Gedanke des Lernens durch<br />

Vormachen ist richtig, aber wie man aus der Wissensextraktion ein<br />

Konzept entwickelt, das dann reproduziert werden kann, das Problem<br />

ist ungelöst.<br />

Dix: Wenn Sie das Schachspiel betrachten, dann haben wir eine<br />

ganz spezifische Anwendung mit einer klaren Struktur, die man<br />

ausnutzen kann. Und selbst da hat es 20 Jahre und viele Millionen<br />

Dollar gebraucht, bis Deep Blue den Schachweltmeister schlagen<br />

konnte. Das müssten Sie jetzt beim Sandwich machen, beim Kaffee<br />

und so weiter. Es ist faszinierend, was Kinder können, Maschinen<br />

aber nicht einmal annähernd. Ich habe 20 Jahre auf dem Gebiet<br />

Common Sense Reasoning gearbeitet und weiß wie schwierig es ist,<br />

dieses Wissen zu formalisieren, Schlüsse zu ziehen und Entscheidungen<br />

zu treffen. Die Komplexität explodiert. Auch mit immer<br />

größeren Speichern und schnelleren Chips wird das mit herkömmlichen<br />

Methoden nicht handhabbar.<br />

Was fehlt denn zum Durchbruch? Die zündende Idee des anderen<br />

Zugangs?<br />

Dix: Wir haben in 2.000 Jahren aus der Mathematik und Logik<br />

Konzepte heraus entwickelt, die vernünftig zur Beschreibung unserer<br />

physikalischen Erfahrungswelt waren. Vielleicht sind diese<br />

Methoden nicht angemessen, um menschliches, rationales Handeln<br />

vollständig zu beschreiben? Einzelne Aspekte ja, aber nicht<br />

das Ganze.<br />

Wörgötter: Abgesehen davon, dass viele Kleinigkeiten noch fehlen,<br />

angefangen von guter Mechanik. Wir stehen zur Zeit fast wie<br />

die Physik des 19. Jahrhunderts da – wir wissen eigentlich nicht,<br />

warum wir nicht weiterkommen. Es herrscht eine gewisse Frustration<br />

bei vielen von uns, menschliche Fähigkeiten nicht auf eine<br />

Maschine übertragen zu können. Der Progress ist eher schleppend<br />

und wird manchmal einfach nur durch pure Rechenpower und<br />

nicht durch Intelligenz erreicht.<br />

Ein Szenario, an dem bereits gearbeitet wird, ist ein autonomer Verkehr.<br />

Zum Beispiel autonomes Einparken, Carsharing-Autos, die<br />

nach Bestellung allein bis vor die eigene Haustür kommen – da sind<br />

der Fantasie wenig Grenzen gesetzt.<br />

Wörgötter: Im Verkehr funktioniert das ganz gut, weil gerade Straßensituationen<br />

immer noch vergleichsweise strukturiert sind. Interessant<br />

ist die Analogie. Vor 20 Jahren war Schach das Problem, das<br />

uns strukturiert genug erschien, um es endlich anzugehen. Jetzt ist<br />

es das Fahren, das inzwischen im Prinzip „gelöst“ ist, zumindest<br />

schon recht gut funktioniert. Und so kommen wir langsam weiter<br />

in zunehmend unstrukturiertere, komplexere Bereiche der Welt<br />

des Menschen hinein. Aber auch beim autonomen Fahren wird im<br />

Prinzip die massive Rechenleistung eines Großcomputers verwendet,<br />

um diese ganzen Situationen auszuwerten, wenn zum Beispiel<br />

die Straßenmarkierung fehlt.<br />

Dix: Und vergessen wir nicht: Im Auto ist mittlerweile viel Elektronik<br />

drin – und es wird immer mehr. Die Systeme werden dadurch<br />

anfälliger. Und es wird irgendwann der erste Unfall passieren, bei<br />

dem die Leute sich drüber streiten werden, ob nun ein Programmierfehler<br />

ursächlich war oder nicht.<br />

Wörgötter: Wir sehen das an Einzelfällen, wo leichtautonome<br />

Systeme aus dem Ruder laufen. Wer hat dann mehr Schuld – der<br />

Computer, der durch eine Firma programmiert wurde, oder der<br />

Mensch? Auch im Internet treten Probleme auf. Wenn Inhalte automatisch<br />

aufgerufen werden, die sie gar nicht sehen wollen – das<br />

kann bis hin zu kriminellen Machenschaften gehen. Wer ist da der<br />

Schuldige? Das ist sicher ein großes juristisches Thema und wird es<br />

für die Zukunft bleiben.<br />

Speziell die militärische Nutzung von Drohnen, deren Autonomiegrad<br />

wächst, wird sehr kritisch gesehen. Gibt es Grenzen der Autonomie,<br />

die man nicht überschreiten darf?<br />

Dix: Es gibt keine Grenzen, alles was gemacht werden kann, wird<br />

gemacht. Das war schon immer so.<br />

Wörgötter: Forschungsmoratorien sind deshalb nicht sinnvoll, weil<br />

die im globalen Maßstab ohnehin durchbrochen werden. Nehmen<br />

Sie die Stammzellforschung – in Deutschland verboten, in anderen<br />

Ländern wird daran geforscht. Ich glaube, man kann den Umgang<br />

mit gefährlichen Technologien gleich welcher Art nur durch verständnisvolle,<br />

moralisch fundierte Selbstkontrolle erreichen. Es<br />

muss ein Konsens bestehen, dass man bestimmte Dinge einfach<br />

nicht tun kann, wie das Abwerfen von Atombomben oder eben<br />

auch das Bauen von Kampfrobotern. Aber das einfach naiv zu verbieten<br />

hat keinen Sinn, denn wenn ich einen autonomen humanoiden<br />

Roboter habe, dann kann ich dem auch einfach so ein Gewehr<br />

in die Hand drücken.<br />

Dix: Nehmen wir Gesichtserkennung als ganz konkretes Beispiel.<br />

Man kann heute durch ein paar biometrische Daten Gesichter sehr