Algoritmo das Projeções Sucessivas Para Seleção de ... - PPGQ

Algoritmo das Projeções Sucessivas Para Seleção de ... - PPGQ

Algoritmo das Projeções Sucessivas Para Seleção de ... - PPGQ

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

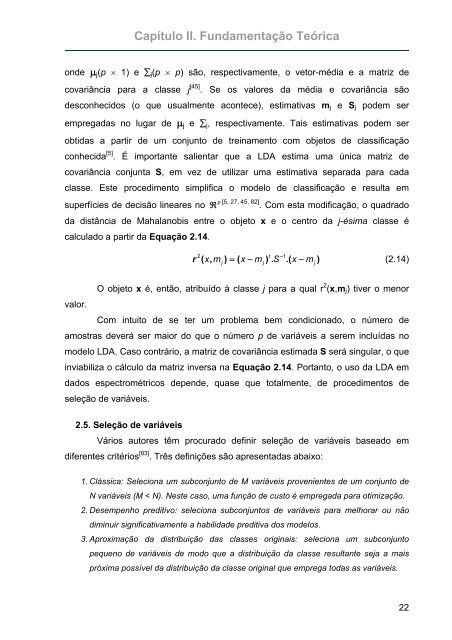

Capítulo II. Fundamentação Teórica<br />

on<strong>de</strong> μ j (p × 1) e ∑ j (p × p) são, respectivamente, o vetor-média e a matriz <strong>de</strong><br />

covariância para a classe j [45] . Se os valores da média e covariância são<br />

<strong>de</strong>sconhecidos (o que usualmente acontece), estimativas m j e S j po<strong>de</strong>m ser<br />

emprega<strong>das</strong> no lugar <strong>de</strong> μ j e ∑ j , respectivamente. Tais estimativas po<strong>de</strong>m ser<br />

obti<strong>das</strong> a partir <strong>de</strong> um conjunto <strong>de</strong> treinamento com objetos <strong>de</strong> classificação<br />

conhecida [5] . É importante salientar que a LDA estima uma única matriz <strong>de</strong><br />

covariância conjunta S, em vez <strong>de</strong> utilizar uma estimativa separada para cada<br />

classe. Este procedimento simplifica o mo<strong>de</strong>lo <strong>de</strong> classificação e resulta em<br />

superfícies <strong>de</strong> <strong>de</strong>cisão lineares no<br />

p<br />

R [5, 27, 45, 82] . Com esta modificação, o quadrado<br />

da distância <strong>de</strong> Mahalanobis entre o objeto x e o centro da j-ésima classe é<br />

calculado a partir da Equação 2.14.<br />

2<br />

t −1<br />

r x,<br />

m ) = ( x − m ) . S .( x − m )<br />

(2.14)<br />

(<br />

j<br />

j<br />

j<br />

O objeto x é, então, atribuído à classe j para a qual r 2 (x,m j ) tiver o menor<br />

valor.<br />

Com intuito <strong>de</strong> se ter um problema bem condicionado, o número <strong>de</strong><br />

amostras <strong>de</strong>verá ser maior do que o número p <strong>de</strong> variáveis a serem incluí<strong>das</strong> no<br />

mo<strong>de</strong>lo LDA. Caso contrário, a matriz <strong>de</strong> covariância estimada S será singular, o que<br />

inviabiliza o cálculo da matriz inversa na Equação 2.14. Portanto, o uso da LDA em<br />

dados espectrométricos <strong>de</strong>pen<strong>de</strong>, quase que totalmente, <strong>de</strong> procedimentos <strong>de</strong><br />

seleção <strong>de</strong> variáveis.<br />

2.5. <strong>Seleção</strong> <strong>de</strong> variáveis<br />

Vários autores têm procurado <strong>de</strong>finir seleção <strong>de</strong> variáveis baseado em<br />

diferentes critérios [83] . Três <strong>de</strong>finições são apresenta<strong>das</strong> abaixo:<br />

1. Clássica: Seleciona um subconjunto <strong>de</strong> M variáveis provenientes <strong>de</strong> um conjunto <strong>de</strong><br />

N variáveis (M < N). Neste caso, uma função <strong>de</strong> custo é empregada para otimização.<br />

2. Desempenho preditivo: seleciona subconjuntos <strong>de</strong> variáveis para melhorar ou não<br />

diminuir significativamente a habilida<strong>de</strong> preditiva dos mo<strong>de</strong>los.<br />

3. Aproximação da distribuição <strong>das</strong> classes originais: seleciona um subconjunto<br />

pequeno <strong>de</strong> variáveis <strong>de</strong> modo que a distribuição da classe resultante seja a mais<br />

próxima possível da distribuição da classe original que emprega to<strong>das</strong> as variáveis.<br />

22