Untitled - WWW Ircam

Untitled - WWW Ircam

Untitled - WWW Ircam

- No tags were found...

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

4 RECHERCHE ET DÉVELOPPEMENT, L’UMR STMS<br />

Projet eJam avec Orange Labs<br />

Orange Labs développe avec le projet eJam un système de<br />

musique participative de chant en réseau. Une première<br />

étape de collaboration entre Orange Labs et l’<strong>Ircam</strong> a été<br />

initiée en fin 2011 en prévoyant, à plus long terme, des développements<br />

de composants technologiques à partir de 2012.<br />

Dans cette première collaboration, l’équipe contribue au<br />

développement de deux composants « plugins » de traitement<br />

sonore : une réverbération et un composant qui corrige<br />

automatiquement la hauteur d’un enregistrement de chant,<br />

sur la base d’un alignement à un enregistrement référence.<br />

Le développement du plugin de réverbération utilise la<br />

bibliothèque <strong>Ircam</strong> Reverb développée par l’équipe Espaces<br />

acoustiques et cognitifs. La correction de la hauteur s’appuie<br />

sur une nouvelle bibliothèque d’alignement entre deux<br />

fichiers audio ainsi que les bibliothèques MuBu, ZsaZsa et<br />

RTA. Plusieurs prototypes Max/MSP ont été développés pour<br />

ce projet.<br />

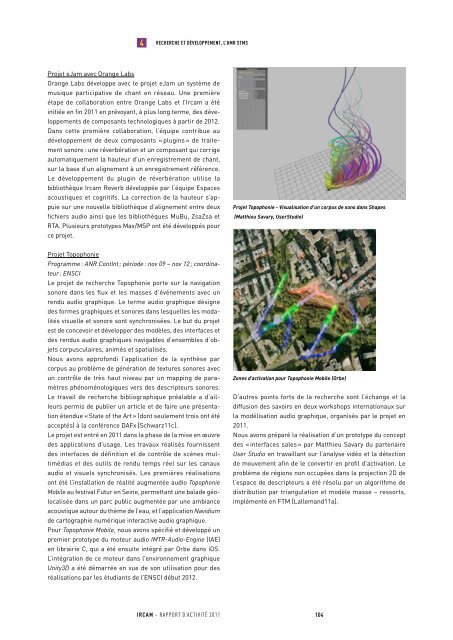

Projet Topophonie - Visualisation d’un corpus de sons dans Shapes<br />

(Matthieu Savary, UserStudio)<br />

Projet Topophonie<br />

Programme : ANR ContInt ; période : nov 09 – nov 12 ; coordinateur<br />

: ENSCI<br />

Le projet de recherche Topophonie porte sur la navigation<br />

sonore dans les flux et les masses d’événements avec un<br />

rendu audio graphique. Le terme audio graphique désigne<br />

des formes graphiques et sonores dans lesquelles les modalités<br />

visuelle et sonore sont synchronisées. Le but du projet<br />

est de concevoir et développer des modèles, des interfaces et<br />

des rendus audio graphiques navigables d’ensembles d’objets<br />

corpusculaires, animés et spatialisés.<br />

Nous avons approfondi l’application de la synthèse par<br />

corpus au problème de génération de textures sonores avec<br />

un contrôle de très haut niveau par un mapping de paramètres<br />

phénoménologiques vers des descripteurs sonores.<br />

Le travail de recherche bibliographique préalable a d’ailleurs<br />

permis de publier un article et de faire une présentation<br />

étendue « State of the Art » (dont seulement trois ont été<br />

acceptés) à la conférence DAFx [Schwarz11c].<br />

Le projet est entré en 2011 dans la phase de la mise en œuvre<br />

des applications d’usage. Les travaux réalisés fournissent<br />

des interfaces de définition et de contrôle de scènes multimédias<br />

et des outils de rendu temps réel sur les canaux<br />

audio et visuels synchronisés. Les premières réalisations<br />

ont été l’installation de réalité augmentée audio Topophonie<br />

Mobile au festival Futur en Seine, permettant une balade géolocalisée<br />

dans un parc public augmentée par une ambiance<br />

acoustique autour du thème de l’eau, et l’application Navidium<br />

de cartographie numérique interactive audio graphique.<br />

Pour Topophonie Mobile, nous avons spécifié et développé un<br />

premier prototype du moteur audio IMTR-Audio-Engine (IAE)<br />

en librairie C, qui a été ensuite intégré par Orbe dans iOS.<br />

L’intégration de ce moteur dans l’environnement graphique<br />

Unity3D a été démarrée en vue de son utilisation pour des<br />

réalisations par les étudiants de l’ENSCI début 2012.<br />

Zones d’activation pour Topophonie Mobile (Orbe)<br />

D’autres points forts de la recherche sont l’échange et la<br />

diffusion des savoirs en deux workshops internationaux sur<br />

la modélisation audio graphique, organisés par le projet en<br />

2011.<br />

Nous avons préparé la réalisation d’un prototype du concept<br />

des « interfaces sales » par Matthieu Savary du partenaire<br />

User Studio en travaillant sur l’analyse vidéo et la détection<br />

de mouvement afin de le convertir en profil d’activation. Le<br />

problème de régions non occupées dans la projection 2D de<br />

l’espace de descripteurs a été résolu par un algorithme de<br />

distribution par triangulation et modèle masse – ressorts,<br />

implémenté en FTM [Lallemand11a].<br />

IRCAM – RAPPORT D’ACTIVITÉ 2011<br />

104