180 181Meta-informācijas izmantošana klasifikācijas uzdevumosUsing Meta-Information in Classification TasksInese Poļaka, Rīgas Tehniskās universitātes absolventeDarba zinātniskais vadītājs: Dr.hab.sc.comp. Arkādijs BorisovsRezumējumsKlasifikācijas uzdevums ir populārs datu ieguves uzdevums dažādās sfērās – medicīnā, finansēs,bioloģijā u.c., un tā risināšanai ir izstrādātas daudzas metodes. Viena no populārākajām pieejāmklasifikācijas uzdevuma risināšanā ir lēmumu koku izmantošana, jo modeļu izveide aizņem salīdzinošimaz resursu un tos ir viegli interpretēt arī konkrētās sfēras speciālistiem, kas nepārzina šīs metodes.Darbā tiek apskatīta datu struktūras meta-informācijas izmantošana datu ieguves klasifikācijasuzdevumā. Meta-informācija var tikt izmantota piemērotākā klasifikatora un tā parametru izvēlē, kāarī datiem piemērotāka klasifikatora projektēšanā. Tiek aplūkots modelis, pēc kura principa darbojasklasifikatoru izvēles sistēma, kas balstās uz meta-informācijas par datiem izmantošanu.Darbā apskatītas divas metodes, kas izmanto datu struktūras informāciju klasifikatoru projektēšanāar mērķi izveidot datiem pielāgotus, kompaktus un precīzus klasifikatorus. Klašu dekompozīcijā arhierarhiskās klasterizācijas palīdzību tiek aprakstīta klašu iekšējā struktūra, sadalot klases apakšklasēs,lai uzlabotu klasifikatoru precizitāti. Uz atribūtu vērtību taksonomiju pamata konstruētos lēmumuklasifikatoros tiek izmantota atribūtu iekšējā struktūra, lai konstruētu klasifikatorus, kas izmanto atribūtuvērtības dažādos abstrakcijas līmeņos.Datu struktūras meta-informācijas izmantošanas ietekme uz klasifikatoriem tiek eksperimentālipārbaudīta, izmantojot reālās dzīves datus. Abu aplūkoto metožu izmantošana zīmīgi uzlabo klasifikatoruveiktspēju, salīdzinot ar klasifikatoriem, kas konstruēti, neizmantojot šīs metodes, kas pierāda metainformācijasizmantošanas lietderīgumu. Tāpat tiek apskatīti sarežģījumi, ar kuriem nākas saskarties,veidojot uz meta-informācijas balstītas klasifikatoru izvēles sistēmas, un veidoti ieteikumi tālākajamdarbam.AbstractClassification task is a popular data mining task in various fields – health, finance, biology etc. andmany methods have been developed to solve it. One of the most popular approaches is using decisiontrees for classification because building models does not require much resource and the models areinterpretable for experts who do not know these methods.classifiers. Attribute-value taxonomy based decision tree design uses structure of attribute values tobuild classifiers that use attribute values in different abstraction levels.The impact of the use of data structure meta-information on classifiers is experimentally proven usingreal-life data. The use of both methods significantly improves the performance of classifiers whencompared to classifiers that were built without the use of these methods. This proves the utility of metainformation.The article also examines complications than can arise when building meta-informationbased classifier selection systems and gives recommendations for future work.Atslēgas vārdi: datu ieguve, klasifikācija, meta-informācija datu ieguvē, klašu dekompozīcija, atribūtuvērtību taksonomija.IevadsKlasifikācijas uzdevums ir populārs datu ieguves uzdevums dažādās sfērās – medicīnā, finansēs,bioloģijā u.tml., un tā risināšanai ir izveidotas daudzas metodes. Taču šo metožu veiktspēja nav vienlīdzlaba visās datu kopās. Ir grūti izvēlēties piemērotāko klasifikatoru, tāpēc pastāv ideja izveidot sistēmu,kas, balstoties uz datu meta-īpašībām, izvēlēsies piemērotāko algoritmu un tā parametrus. Šī mērķasasniegšanai ir nepieciešamas zināšanas par to, kā datu īpašības ietekmē klasifikatoru veiktspēju.Problēma ir tajā, ka šobrīd nav pieejama matemātiska apraksta metožu izvēles procesam, kā arī trūkstempīrisku aprakstu, kas būtu apkopoti un tieši saistīti ar tēmu. Tāpēc darbā piedāvāta eksperimentālāanalīze, kas apskata klašu iekšējās struktūras un atribūtu vērtību struktūras ietekmi uz klasifikatoruveiktspēju. Tas ļauj noteikt arī šīs meta-informācijas ietekmi uz klasifikatora izvēli.Darbā tiek izmantotas divas metodes, kas izmanto datu struktūras īpašības klasifikatoru konstruēšanā:klašu dekompozīcija (izmanto hierarhisko klasterizāciju, lai izpētītu klašu iekšējo struktūru) un uztaksonomijas balstīta klasifikācijas koku konstruēšana (izmanto AVT-Learner metodi, lai izpētītuatribūtu vērtību sakarības). Klasifikācijai tiek izmantoti algoritmi C<strong>4.</strong>5 un CART, izmantojot 10-kārtīgušķērsvalidāciju rezultātu novērtēšanai.Teorētiskais pamatojumsKlasifikatora izvēles sistēmas pamatā ir datu bāze, kas satur informāciju par datu kopām, to metaīpašībāmun dažādu klasifikatoru veiktspēju, izmantojot šos datus. Katra jauna datu kopa, kurā irparedzēts veikt klasifikāciju, tiek analizēta, iegūstot meta-informāciju par to, kas tiek salīdzināta ardatu bāzē esošajām zināšanām par citām datu kopām. Pēc datu kopu līdzības ir paredzēts noteiktpiemērotāko klasifikācijas stratēģiju – līdzīgās datu kopās klasifikatoru veiktspēja ir līdzīga. Sistēmasshēma ir parādīta 1. attēlā.The article examines possibilities of using meta-information about data structure in data miningclassification task. Meta-information can be used in choosing the most suitable classifier and itsparameters as well as building a classifier that fits the data. The research also outlines a model of aclassifier selection system that is based on the use of meta-information about data.The research analyzes two methods that use information about data structure in building classifiersto design classifiers that fit data, are compact and accurate. Class decomposition uses hierarchicalclassification to describe class structures by dividing them into subclasses to increase efficiency of<strong>Vidzemes</strong> <strong>Augstskolas</strong> <strong>4.</strong><strong>Studentu</strong> pētniecisko darbu konferences rakstu krājums<strong>Vidzemes</strong> <strong>Augstskolas</strong> <strong>4.</strong><strong>Studentu</strong> pētniecisko darbu konferences rakstu krājums

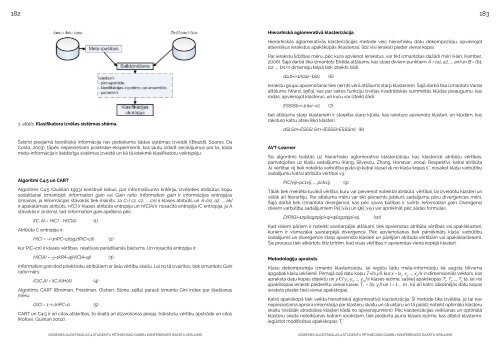

182 183Hierarhiskā aglomeratīvā klasterizācijaHierarhiskās aglomeratīvās klasterizācijas metode veic hierarhisku datu dekompozīciju, apvienojotatsevišķus ierakstus apakškopās (klasteros), līdz visi ieraksti pieder vienai kopai.Par ierakstu līdzības mēru, pēc kura apvienot ierakstus, var tikt izmantotas dažādi mēri (Han, Kamber,2006). Šajā darbā tika izmantots Eiklīda attālums, kas starp diviem punktiem A = (a1, a2, …, an) un B = (b1,b2, …, bn) n dimensiju telpā tiek izteikts šādi:da,b=i=1n(ai2−bi2), (6)Ierakstu grupu apvienošanai tiek ņemts vērā attālums starp klasteriem. Šajā darbā tika izmantots Vardaattālums (Ward, 1963), kas par saites funkciju izvēlas kvadrātiskās summētās kļūdas pieaugumu, kasrodas, apvienojot klasterus, un kuru var izteikt šādi:ESS(Sl)=i=1nlxi−x2, (7)1. attēls. Klasifikatora izvēles sistēmas shēma.Šobrīd pieejamā teorētiskā informācija nav pietiekama šādas sistēmas izveidē ((Brazdil, Soares, DaCosta, 2003), tāpēc nepieciešami praktiskie eksperimenti, kas ļautu izdarīt secinājumus par to, kādameta-informācija ir lietderīga sistēmas izveidē un kā tā ietekmē klasifikatoru veiktspēju.Algoritmi C<strong>4.</strong>5 un CARTAlgoritms C<strong>4.</strong>5 (Quinlan 1993) konstruē kokus, par informatīvuma kritēriju, izvēloties atribūtus kopusadalīšanai izmantojot Information gain vai Gain ratio. Information gain ir informācijas entropijasizmaiņas, ja informācijas stāvoklis tiek mainīts. Ja C={ c1, c2, …, cn} ir klases atribūts un A={a1, a2, …, ak}ir apskatāmais atribūts, H(C) ir klases atribūta entropija un H(C|A) ir nosacītā entropija (C entropija, ja Astāvoklis ir zināms), tad Information gain aprēķina pēc:I(C, A) = H(C) - H(C|A) (1)Atribūta C entropija ir:H(C) = −i=1nPC=cilog2(P(C=ci)) (2)kur P(C=cnβ) ir klases vērtības β relatīvais parādīšanās biežums. un nosacītā entropija ir:H(C|A) = −j=1kPA=ajH(C|A=aj) (3)Information gain dod priekšroku atribūtiem ar lielu vērtību skaitu. Lai no tā izvairītos, tiek izmantots Gainratio mērs:IG(C,A) = I(C,A)H(A) (4)Algoritms CART (Breiman, Friedman, Olshen, Stone, 1984) parasti izmanto Gini index par šķelšanasmēru:G(C) = 1−i=1nPC=ci (5)CART un C<strong>4.</strong>5 ir arī citas atšķirības, to skaitā arī atzarošanas pieeja, trūkstošu vērtību apstrāde un citas(Kohavi, Quinlan 2002).bet attālums starp klasteriem ir starpība starp kļūdu, kas raksturo apvienoto klasteri, un kļūdām, kasraksturo katru atsevišķo klasteri:AVT-LearnerdSl,Sm=ESSSl Sm−[ESSSl+ESSSm]. (8)Šis algoritms balstās uz hierarhisko aglomeratīvo klasterizāciju, kas klasterizē atribūtu vērtības,pamatojoties uz klašu sadalījumu (Kang, Silvescu, Zhang, Honavar, 2004). Respektīvi, katrai atribūtaAi vērtībai vij tiek noteikta varbūtība p(ck|vij) katrai klasei ck no klašu kopas C, nosakot klašu varbūtībusadalījumu katrai atribūta vērtībai vij:P(C|vij)=pc1vij, …, pckvij, (9)Tālāk tiek meklēta tuvākā vērtība, kuru var pievienot noteiktai atribūta β vērtībai, lai izveidotu klasteri unvēlāk arī hierarhiju. Par attāluma mēru var tikt pieņemts jebkurš sadalījumu pāru diverģences mērs.Šajā darbā tiek izmantota diverģence, kas pēc savas būtības ir svērts Information gain. Diverģencidiviem varbūtību sadalījumiem βp(C|vix) un Q(C|viy) var aprēķināt pēc šādas formulas:D(P||Q)=12pilog2pipi+qi+qilog2qipi+qi, (10)Kad visiem pāriem ir noteikti savstarpējie attālumi, tiek apvienotas atribūta vērtības vai apakšklasteri,kuriem ir vismazākā savstarpējā diverģence. Pēc apvienošanas tiek pārrēķināts klašu varbūtībusadalījums un diverģence starp apvienoto klasteri un pārējām atribūta vērtībām vai apakšklasteriem.Šis process tiek atkārtots līdz brīdim, kad visas vērtības ir apvienotas vienā kopējā klasterī.Metodoloģiju aprakstsKlašu dekompozīcija izmanto klasterizāciju, lai iegūtu tādu meta-informāciju kā augsta blīvumaapgabali klašu iekšienē. Pirmajā solī datu kopu T={(x,y)}, kur x = {x 1, x 2, …, x n) ir n-dimensionāls vektors, kasapraksta datu kopas objektu un y Є{ y 1, y 2, ..., y m} ir klases iezīme, sašķeļ apakškopās T 1, T 2, …, T ktā, lai visiapakškopas ieraksti piederētu vienai klasei T i= {(x, y i)} un i = 1 ... m , kā arī katrs sākotnējās datu kopasieraksts pieder tieši vienai apakškopai.Katrā apakškopā tiek veikta hierarhiskā aglomeratīvā klasterizācija. Šī metode tika izvēlēta, jo tai navnepieciešama apriora informācija par klasteru skaitu un struktūru un tā palīdz noteikt optimālo klasteruskaitu (vistālāk atrodošies klasteri kādā no apvienojumiem). Pēc klasterizācijas veikšanas un optimālāklasteru skaita noteikšanas katram ierakstam, tiek piešķirta jauna klases iezīme, kas atbilst klasterim,iegūstot modificētas apakškopas T i’.<strong>Vidzemes</strong> <strong>Augstskolas</strong> <strong>4.</strong><strong>Studentu</strong> pētniecisko darbu konferences rakstu krājums<strong>Vidzemes</strong> <strong>Augstskolas</strong> <strong>4.</strong><strong>Studentu</strong> pētniecisko darbu konferences rakstu krājums