traitement d'images par modèles discrets sur ... - Olivier Lezoray

traitement d'images par modèles discrets sur ... - Olivier Lezoray

traitement d'images par modèles discrets sur ... - Olivier Lezoray

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

66 Chapitre 3 - Classification de données d’images <strong>par</strong> apprentissage<br />

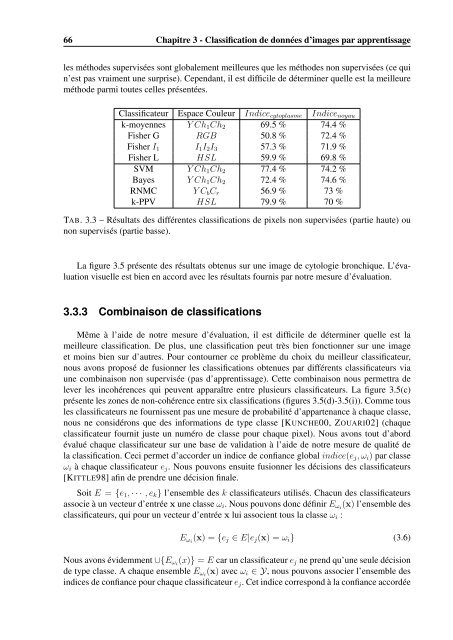

les méthodes supervisées sont globalement meilleures que les méthodes non supervisées (ce qui<br />

n’est pas vraiment une <strong>sur</strong>prise). Cependant, il est difficile de déterminer quelle est la meilleure<br />

méthode <strong>par</strong>mi toutes celles présentées.<br />

Classificateur Espace Couleur Indice cytoplasme Indice noyau<br />

k-moyennes Y Ch 1 Ch 2 69.5 % 74.4 %<br />

Fisher G RGB 50.8 % 72.4 %<br />

Fisher I 1 I 1 I 2 I 3 57.3 % 71.9 %<br />

Fisher L HSL 59.9 % 69.8 %<br />

SVM Y Ch 1 Ch 2 77.4 % 74.2 %<br />

Bayes Y Ch 1 Ch 2 72.4 % 74.6 %<br />

RNMC Y C b C r 56.9 % 73 %<br />

k-PPV HSL 79.9 % 70 %<br />

TAB. 3.3 – Résultats des différentes classifications de pixels non supervisées (<strong>par</strong>tie haute) ou<br />

non supervisés (<strong>par</strong>tie basse).<br />

La figure 3.5 présente des résultats obtenus <strong>sur</strong> une image de cytologie bronchique. L’évaluation<br />

visuelle est bien en accord avec les résultats fournis <strong>par</strong> notre me<strong>sur</strong>e d’évaluation.<br />

3.3.3 Combinaison de classifications<br />

Même à l’aide de notre me<strong>sur</strong>e d’évaluation, il est difficile de déterminer quelle est la<br />

meilleure classification. De plus, une classification peut très bien fonctionner <strong>sur</strong> une image<br />

et moins bien <strong>sur</strong> d’autres. Pour contourner ce problème du choix du meilleur classificateur,<br />

nous avons proposé de fusionner les classifications obtenues <strong>par</strong> différents classificateurs via<br />

une combinaison non supervisée (pas d’apprentissage). Cette combinaison nous permettra de<br />

lever les incohérences qui peuvent ap<strong>par</strong>aître entre plusieurs classificateurs. La figure 3.5(c)<br />

présente les zones de non-cohérence entre six classifications (figures 3.5(d)-3.5(i)). Comme tous<br />

les classificateurs ne fournissent pas une me<strong>sur</strong>e de probabilité d’ap<strong>par</strong>tenance à chaque classe,<br />

nous ne considérons que des informations de type classe [KUNCHE00, ZOUARI02] (chaque<br />

classificateur fournit juste un numéro de classe pour chaque pixel). Nous avons tout d’abord<br />

évalué chaque classificateur <strong>sur</strong> une base de validation à l’aide de notre me<strong>sur</strong>e de qualité de<br />

la classification. Ceci permet d’accorder un indice de confiance global indice(e j , ω i ) <strong>par</strong> classe<br />

ω i à chaque classificateur e j . Nous pouvons ensuite fusionner les décisions des classificateurs<br />

[KITTLE98] afin de prendre une décision finale.<br />

Soit E = {e 1 , · · · , e k } l’ensemble des k classificateurs utilisés. Chacun des classificateurs<br />

associe à un vecteur d’entrée x une classe ω i . Nous pouvons donc définir E ωi (x) l’ensemble des<br />

classificateurs, qui pour un vecteur d’entrée x lui associent tous la classe ω i :<br />

E ωi (x) = {e j ∈ E|e j (x) = ω i } (3.6)<br />

Nous avons évidemment ∪{E ωi (x)} = E car un classificateur e j ne prend qu’une seule décision<br />

de type classe. A chaque ensemble E ωi (x) avec ω i ∈ Y, nous pouvons associer l’ensemble des<br />

indices de confiance pour chaque classificateur e j . Cet indice correspond à la confiance accordée