- Page 1:

THÈSE DE DOCTORAT DE L’UNIVERSIT

- Page 5:

Computational role of correlations

- Page 8 and 9:

viii différent, indispensable. Je

- Page 10 and 11:

x 3.4 Fiabilité de la décharge ne

- Page 12 and 13:

xii

- Page 14 and 15:

xiv 3.8 Fiabilité neuronale in vit

- Page 16 and 17:

xvi 9.5 Quality and stability of el

- Page 18 and 19:

2 entrée sens (perception) périph

- Page 20 and 21:

4 3. L’étude de la sensibilité

- Page 23:

Contexte scientifique 7

- Page 26 and 27:

10 Sommaire 1.1 Introduction . . .

- Page 28 and 29:

12 Anatomie et physiologie du syst

- Page 30 and 31:

14 Anatomie et physiologie du syst

- Page 32 and 33:

16 Anatomie et physiologie du syst

- Page 34 and 35:

18 Anatomie et physiologie du syst

- Page 36 and 37:

20 Anatomie et physiologie du syst

- Page 38 and 39: 22 Anatomie et physiologie du syst

- Page 40 and 41: 24 Anatomie et physiologie du syst

- Page 42 and 43: 26 Anatomie et physiologie du syst

- Page 44 and 45: 28 Anatomie et physiologie du syst

- Page 46 and 47: 30 Anatomie et physiologie du syst

- Page 48 and 49: 32 Anatomie et physiologie du syst

- Page 50 and 51: 34 Anatomie et physiologie du syst

- Page 52 and 53: 36 Anatomie et physiologie du syst

- Page 54 and 55: 38 Anatomie et physiologie du syst

- Page 56 and 57: 40 Anatomie et physiologie du syst

- Page 58 and 59: 42 Anatomie et physiologie du syst

- Page 60 and 61: 44 Anatomie et physiologie du syst

- Page 62 and 63: 46 Modélisation impulsionnelle de

- Page 64 and 65: 48 Modélisation impulsionnelle de

- Page 66 and 67: 50 Modélisation impulsionnelle de

- Page 68 and 69: 52 Modélisation impulsionnelle de

- Page 70 and 71: 54 Modélisation impulsionnelle de

- Page 72 and 73: 56 Modélisation impulsionnelle de

- Page 74 and 75: 58 Modélisation impulsionnelle de

- Page 76 and 77: 60 Modélisation impulsionnelle de

- Page 78 and 79: 62 Modélisation impulsionnelle de

- Page 80 and 81: 64 Modélisation impulsionnelle de

- Page 82 and 83: 66 Modélisation impulsionnelle de

- Page 84 and 85: 68 Modélisation impulsionnelle de

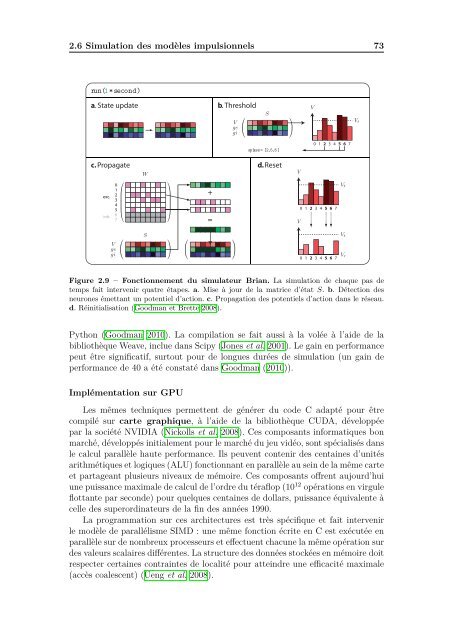

- Page 86 and 87: 70 Modélisation impulsionnelle de

- Page 90 and 91: 74 Modélisation impulsionnelle de

- Page 92 and 93: 76 Codage neuronal et computation S

- Page 94 and 95: 78 Codage neuronal et computation c

- Page 96 and 97: 80 Codage neuronal et computation N

- Page 98 and 99: 82 Codage neuronal et computation F

- Page 100 and 101: 84 Codage neuronal et computation F

- Page 102 and 103: 86 Codage neuronal et computation F

- Page 104 and 105: 88 Codage neuronal et computation F

- Page 106 and 107: 90 Codage neuronal et computation F

- Page 108 and 109: 92 Codage neuronal et computation d

- Page 110 and 111: 94 Codage neuronal et computation n

- Page 112 and 113: 96 Codage neuronal et computation F

- Page 114 and 115: 98 Codage neuronal et computation 3

- Page 116 and 117: 100 Codage neuronal et computation

- Page 118 and 119: 102 Codage neuronal et computation

- Page 120 and 121: 104 Oscillations, corrélations et

- Page 122 and 123: 106 Oscillations, corrélations et

- Page 124 and 125: 108 Oscillations, corrélations et

- Page 126 and 127: 110 Oscillations, corrélations et

- Page 128 and 129: 112 Oscillations, corrélations et

- Page 130 and 131: 114 Oscillations, corrélations et

- Page 132 and 133: 116 Oscillations, corrélations et

- Page 134 and 135: 118 Oscillations, corrélations et

- Page 136 and 137: 120 Oscillations, corrélations et

- Page 138 and 139:

122 Oscillations, corrélations et

- Page 140 and 141:

124 Oscillations, corrélations et

- Page 142 and 143:

126 Oscillations, corrélations et

- Page 144 and 145:

128 Oscillations, corrélations et

- Page 146 and 147:

130 Oscillations, corrélations et

- Page 148 and 149:

132 Oscillations, corrélations et

- Page 150 and 151:

134 Oscillations, corrélations et

- Page 152 and 153:

136 Oscillations, corrélations et

- Page 154 and 155:

138 Oscillations, corrélations et

- Page 156 and 157:

140 Oscillations, corrélations et

- Page 158 and 159:

142 Oscillations, corrélations et

- Page 160 and 161:

144 Oscillations, corrélations et

- Page 162 and 163:

146 Oscillations, corrélations et

- Page 164 and 165:

148

- Page 166 and 167:

150

- Page 168 and 169:

152 Adaptation automatique de modè

- Page 170 and 171:

154 Adaptation automatique de modè

- Page 172 and 173:

156 Adaptation automatique de modè

- Page 174 and 175:

158 Adaptation automatique de modè

- Page 176 and 177:

160 Adaptation automatique de modè

- Page 178 and 179:

162 Adaptation automatique de modè

- Page 180 and 181:

164 Adaptation automatique de modè

- Page 182 and 183:

166 Adaptation automatique de modè

- Page 184 and 185:

168 Adaptation automatique de modè

- Page 186 and 187:

170 Adaptation automatique de modè

- Page 188 and 189:

172 Calibrage de modèles impulsion

- Page 190 and 191:

174 Calibrage de modèles impulsion

- Page 192 and 193:

176 Calibrage de modèles impulsion

- Page 194 and 195:

178 Calibrage de modèles impulsion

- Page 196 and 197:

180 Calibrage de modèles impulsion

- Page 198 and 199:

182 Calibrage de modèles impulsion

- Page 200 and 201:

184 Playdoh : une librairie de calc

- Page 202 and 203:

186 Playdoh : une librairie de calc

- Page 204 and 205:

188 Playdoh : une librairie de calc

- Page 206 and 207:

190 Playdoh : une librairie de calc

- Page 208 and 209:

192 Playdoh: une librairie de calcu

- Page 210 and 211:

194 Playdoh : une librairie de calc

- Page 212 and 213:

196 Playdoh : une librairie de calc

- Page 214 and 215:

198 Playdoh : une librairie de calc

- Page 216 and 217:

200 Playdoh : une librairie de calc

- Page 218 and 219:

202 Détection de coïncidences dan

- Page 220 and 221:

204 Détection de coïncidences dan

- Page 222 and 223:

206 Détection de coïncidences dan

- Page 224 and 225:

208 Détection de coïncidences dan

- Page 226 and 227:

210 Détection de coïncidences dan

- Page 228 and 229:

212 Détection de coïncidences dan

- Page 230 and 231:

214 Détection de coïncidences dan

- Page 232 and 233:

216 Détection de coïncidences dan

- Page 234 and 235:

218 Détection de coïncidences dan

- Page 236 and 237:

220 Détection de coïncidences dan

- Page 238 and 239:

222 Détection de coïncidences dan

- Page 240 and 241:

224 Détection de coïncidences dan

- Page 242 and 243:

226 Détection de coïncidences dan

- Page 244 and 245:

228 Détection de coïncidences dan

- Page 246 and 247:

230 Détection de coïncidences dan

- Page 248 and 249:

232 Compensation d’électrode san

- Page 250 and 251:

234 Compensation d’électrode san

- Page 252 and 253:

236 Compensation d’électrode san

- Page 254 and 255:

238 Compensation d’électrode san

- Page 256 and 257:

240 Compensation d’électrode san

- Page 258 and 259:

242 Compensation d’électrode san

- Page 260 and 261:

244 A B 20 mV 100 ms C EPSP spike D

- Page 262 and 263:

246 A B Neuron resistance (MΩ) El

- Page 264 and 265:

248 A 20 mV B C D -15 mV threshold

- Page 266 and 267:

250 Discussion

- Page 268 and 269:

252 Discussion de haute conductance

- Page 270 and 271:

254 Discussion Implications sur la

- Page 272 and 273:

256 Discussion des neurones aux co

- Page 274 and 275:

258 exemples incluent un modèle r

- Page 276 and 277:

260

- Page 278 and 279:

262 Réponse à London et al. Somma

- Page 280 and 281:

264 Réponse à London et al. a b 2

- Page 282 and 283:

266 Réponse à London et al. spike

- Page 284 and 285:

268 Publications 2. Rossant, C. & B

- Page 286 and 287:

270 Bibliographie Allen, P., Fish,

- Page 288 and 289:

272 Bibliographie Bar-Gad, I., Rito

- Page 290 and 291:

274 Bibliographie Brette, R. (2003)

- Page 292 and 293:

276 Bibliographie Buzsáki, G. (200

- Page 294 and 295:

278 Bibliographie Dan, Y. et Poo, M

- Page 296 and 297:

280 Bibliographie El Boustani, S. e

- Page 298 and 299:

282 Bibliographie Fusi, S. et Matti

- Page 300 and 301:

284 Bibliographie Graupner, M. et B

- Page 302 and 303:

286 Bibliographie Henze, D. et Buzs

- Page 304 and 305:

288 Bibliographie Jolivet, R., Rauc

- Page 306 and 307:

290 Bibliographie Krumin, M. et Sho

- Page 308 and 309:

292 Bibliographie Lim, D., Ong, Y.,

- Page 310 and 311:

294 Bibliographie McCulloch, W. et

- Page 312 and 313:

296 Bibliographie Nickolls, J., Buc

- Page 314 and 315:

298 Bibliographie Peyrache, A., Kha

- Page 316 and 317:

300 Bibliographie Robbe, D. et Buzs

- Page 318 and 319:

302 Bibliographie Schneidman, E., B

- Page 320 and 321:

304 Bibliographie Smith, P. (1995).

- Page 322 and 323:

306 Bibliographie Takeda, K. et Fun

- Page 324 and 325:

308 Bibliographie Uhlhaas, P., Pipa

- Page 326 and 327:

310 Bibliographie Weliky, M. et Kat