Schriftliche Ausarbeitung herunterladen

Schriftliche Ausarbeitung herunterladen

Schriftliche Ausarbeitung herunterladen

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

3.2. LÖSUNGSANSATZ 19<br />

Direkt hinter der Stereokamera ist ein Inertialsensor montiert. Dieser Aufbau ermöglicht es auf die<br />

bildbasierte Berechnung der Blickrichtung zu verzichten. Somit verbleibt ausreichend CPU-Leistung,<br />

um die zur Positionsbestimmung notwendigen Stereodisparitätsbilder „echtzeitnahe“ zu berechnen und<br />

diese mit dem 3D-Modell zu vergleichen. In den folgenden Abschnitten wird eine Methode vorgestellt,<br />

mit deren Hilfe die Position des Sensormoduls aus den Modell- und Sensordaten berechnet werden kann.<br />

3.2.2 Positionsbestimmung der Kamera<br />

Der hier verfolgte Lösungsansatz ermöglicht die Positionsbestimmung und Unterstützung bei der Navigation<br />

durch das Angleichen einer simulierten Umgebung an real gemessenen Daten. Zu diesem Zweck<br />

wird das im OpenSceneGraph-Format [24] vorliegende Gebäudemodell um eine virtuelle Kamera erweitert<br />

und diese solange im Modell verschoben, bis die simulierten Messungen mit den realen Daten<br />

übereinstimmen. Zu diesem Zweck durchläuft der Navigationsassistent die in den folgenden Absätzen<br />

beschriebenen Schritte.<br />

Ausrichtung der virtuellen Kamera<br />

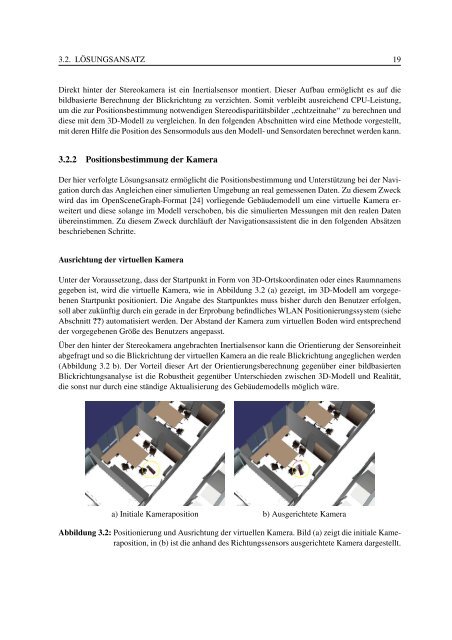

Unter der Voraussetzung, dass der Startpunkt in Form von 3D-Ortskoordinaten oder eines Raumnamens<br />

gegeben ist, wird die virtuelle Kamera, wie in Abbildung 3.2 (a) gezeigt, im 3D-Modell am vorgegebenen<br />

Startpunkt positioniert. Die Angabe des Startpunktes muss bisher durch den Benutzer erfolgen,<br />

soll aber zukünftig durch ein gerade in der Erprobung befindliches WLAN Positionierungssystem (siehe<br />

Abschnitt ??) automatisiert werden. Der Abstand der Kamera zum virtuellen Boden wird entsprechend<br />

der vorgegebenen Größe des Benutzers angepasst.<br />

Über den hinter der Stereokamera angebrachten Inertialsensor kann die Orientierung der Sensoreinheit<br />

abgefragt und so die Blickrichtung der virtuellen Kamera an die reale Blickrichtung angeglichen werden<br />

(Abbildung 3.2 b). Der Vorteil dieser Art der Orientierungsberechnung gegenüber einer bildbasierten<br />

Blickrichtungsanalyse ist die Robustheit gegenüber Unterschieden zwischen 3D-Modell und Realität,<br />

die sonst nur durch eine ständige Aktualisierung des Gebäudemodells möglich wäre.<br />

a) Initiale Kameraposition b) Ausgerichtete Kamera<br />

Abbildung 3.2: Positionierung und Ausrichtung der virtuellen Kamera. Bild (a) zeigt die initiale Kameraposition,<br />

in (b) ist die anhand des Richtungssensors ausgerichtete Kamera dargestellt.