Schriftliche Ausarbeitung herunterladen

Schriftliche Ausarbeitung herunterladen

Schriftliche Ausarbeitung herunterladen

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

3.2. LÖSUNGSANSATZ 33<br />

Die Selbstlokalisation des Navigationsassistenten über Stereokamera und Richtungssensor gibt dem<br />

blinden Benutzer Auskunft über seinen aktuellen Aufenthaltsraum. Ein Abtaststrahl im Zentrum des virtuellen<br />

Blickfeldes ermöglicht ihm zudem die Erforschung der Umgebung durch einfaches „Umsehen“.<br />

Die Namen und die Distanzen der vom virtuellen Abtaststrahl getroffenen Objekte (siehe Abbildung<br />

3.14 (a) orange markiert) können Aufschluss über die Beschaffenheit der Umgebung geben. Durch die<br />

Extrapolation der augenblicklichen Bewegung kann über eine modellbasierte Kollisionserkennung vor<br />

Hindernissen gewarnt werden (siehe Abbildung 3.14 (b)). Der Vergleich zwischen realen und virtuellen<br />

Abständen ermöglicht zudem einen Hinweis auf den Zustand von Türen (Abbildung 3.14 (c-d)).<br />

Der Blinde erhält vom Navigationsassistenten somit zusätzliche Informationen über seine Umgebung,<br />

welche ihm die Navigation durch das fremde Gebäude erleichtern können.<br />

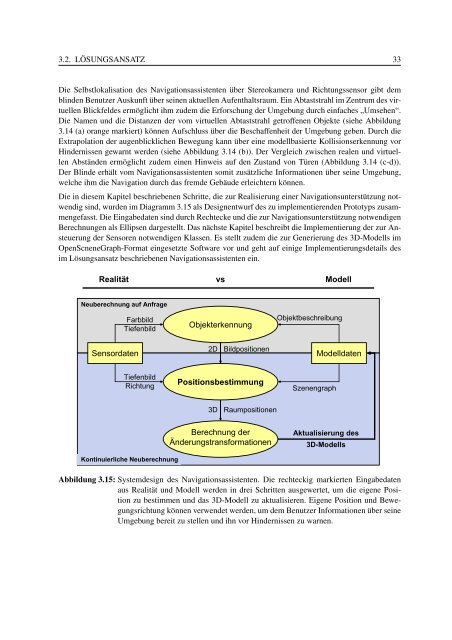

Die in diesem Kapitel beschriebenen Schritte, die zur Realisierung einer Navigationsunterstützung notwendig<br />

sind, wurden im Diagramm 3.15 als Designentwurf des zu implementierenden Prototyps zusammengefasst.<br />

Die Eingabedaten sind durch Rechtecke und die zur Navigationsunterstützung notwendigen<br />

Berechnungen als Ellipsen dargestellt. Das nächste Kapitel beschreibt die Implementierung der zur Ansteuerung<br />

der Sensoren notwendigen Klassen. Es stellt zudem die zur Generierung des 3D-Modells im<br />

OpenScneneGraph-Format eingesetzte Software vor und geht auf einige Implementierungsdetails des<br />

im Lösungsansatz beschriebenen Navigationsassistenten ein.<br />

Realität vs<br />

Modell<br />

Neuberechnung auf Anfrage<br />

Farbbild<br />

Tiefenbild<br />

Objekterkennung<br />

Objektbeschreibung<br />

2D Bildpositionen<br />

Sensordaten Modelldaten<br />

Tiefenbild<br />

Richtung<br />

Positionsbestimmung<br />

Szenengraph<br />

Kontinuierliche Neuberechnung<br />

3D Raumpositionen<br />

Berechnung der<br />

Änderungstransformationen<br />

Aktualisierung des<br />

3D-Modells<br />

Abbildung 3.15: Systemdesign des Navigationsassistenten. Die rechteckig markierten Eingabedaten<br />

aus Realität und Modell werden in drei Schritten ausgewertet, um die eigene Position<br />

zu bestimmen und das 3D-Modell zu aktualisieren. Eigene Position und Bewegungsrichtung<br />

können verwendet werden, um dem Benutzer Informationen über seine<br />

Umgebung bereit zu stellen und ihn vor Hindernissen zu warnen.