Schriftliche Ausarbeitung herunterladen

Schriftliche Ausarbeitung herunterladen

Schriftliche Ausarbeitung herunterladen

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

3.2. LÖSUNGSANSATZ 31<br />

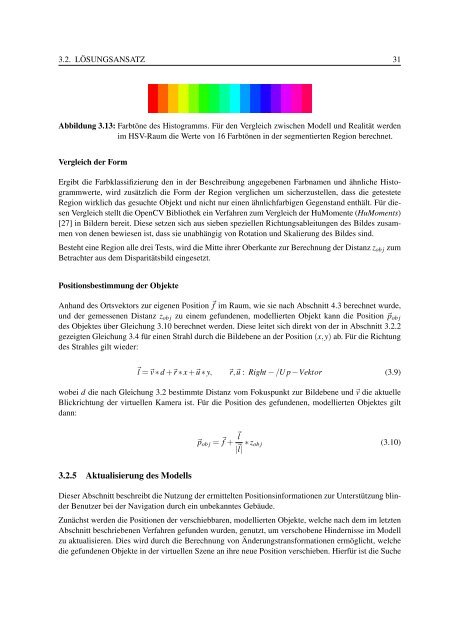

Abbildung 3.13: Farbtöne des Histogramms. Für den Vergleich zwischen Modell und Realität werden<br />

im HSV-Raum die Werte von 16 Farbtönen in der segmentierten Region berechnet.<br />

Vergleich der Form<br />

Ergibt die Farbklassifizierung den in der Beschreibung angegebenen Farbnamen und ähnliche Histogrammwerte,<br />

wird zusätzlich die Form der Region verglichen um sicherzustellen, dass die getestete<br />

Region wirklich das gesuchte Objekt und nicht nur einen ähnlichfarbigen Gegenstand enthält. Für diesen<br />

Vergleich stellt die OpenCV Bibliothek ein Verfahren zum Vergleich der HuMomente (HuMoments)<br />

[27] in Bildern bereit. Diese setzen sich aus sieben speziellen Richtungsableitungen des Bildes zusammen<br />

von denen bewiesen ist, dass sie unabhängig von Rotation und Skalierung des Bildes sind.<br />

Besteht eine Region alle drei Tests, wird die Mitte ihrer Oberkante zur Berechnung der Distanz zob j zum<br />

Betrachter aus dem Disparitätsbild eingesetzt.<br />

Positionsbestimmung der Objekte<br />

Anhand des Ortsvektors zur eigenen Position �f im Raum, wie sie nach Abschnitt 4.3 berechnet wurde,<br />

und der gemessenen Distanz zob j zu einem gefundenen, modellierten Objekt kann die Position �pob j<br />

des Objektes über Gleichung 3.10 berechnet werden. Diese leitet sich direkt von der in Abschnitt 3.2.2<br />

gezeigten Gleichung 3.4 für einen Strahl durch die Bildebene an der Position (x,y) ab. Für die Richtung<br />

des Strahles gilt wieder:<br />

�l =�v ∗ d +�r ∗ x +�u ∗ y, �r,�u : Right − /U p −Vektor (3.9)<br />

wobei d die nach Gleichung 3.2 bestimmte Distanz vom Fokuspunkt zur Bildebene und �v die aktuelle<br />

Blickrichtung der virtuellen Kamera ist. Für die Position des gefundenen, modellierten Objektes gilt<br />

dann:<br />

3.2.5 Aktualisierung des Modells<br />

�pob j = �f + �l<br />

|�l| ∗ zob j<br />

(3.10)<br />

Dieser Abschnitt beschreibt die Nutzung der ermittelten Positionsinformationen zur Unterstützung blinder<br />

Benutzer bei der Navigation durch ein unbekanntes Gebäude.<br />

Zunächst werden die Positionen der verschiebbaren, modellierten Objekte, welche nach dem im letzten<br />

Abschnitt beschriebenen Verfahren gefunden wurden, genutzt, um verschobene Hindernisse im Modell<br />

zu aktualisieren. Dies wird durch die Berechnung von Änderungstransformationen ermöglicht, welche<br />

die gefundenen Objekte in der virtuellen Szene an ihre neue Position verschieben. Hierfür ist die Suche