Grammatiktheorie - German Grammar Group FU Berlin - Freie ...

Grammatiktheorie - German Grammar Group FU Berlin - Freie ...

Grammatiktheorie - German Grammar Group FU Berlin - Freie ...

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

318 11 Diskussion<br />

Wie die vier Fallstudien gezeigt haben, kann es Gründe dafür geben, das acquirendum<br />

abzulehnen. Wenn das acquirendum nicht erworben werden muss, dann liegt auch kein<br />

Beweis für angeborenes sprachliches Wissen vor. Das acquirendum muss zumindest beschreibungsadäquat<br />

sein. Das ist eine empirische Frage, die Linguisten lösen können. In<br />

drei von vier der von Pullum und Scholz diskutierten PoS-Argumente gab es Teile, die<br />

nicht beschreibungsadäquat sind. In den vorangegangenen Abschnitten haben wir bereits<br />

andere PoS-Argumente kennengelernt, die ebenfalls empirisch nicht haltbare Behauptungen<br />

bzgl. linguistischer Daten involvierten (z. B. das Subjazenzprinzip). Für die anderen<br />

Punkte in (60) ist interdisziplinäre Arbeit nötig: Die Lacuna-Spezifikation fällt in die Theorie<br />

der formalen Sprachen (Spezifikation einer Menge von Äußerungen), das Unverzichtbarkeitsargument<br />

ist eine mathematische Aufgabe aus dem Bereich der Lerntheorie, die<br />

Unzugänglichkeitsevidenz ist eine empirische Frage, die mit Zugriff auf Korpora angegangen<br />

werden kann, und die Acquisitionsevidenz ist eine Frage der experimentellen Entwicklungspsychologie<br />

(Pullum und Scholz: 2002, 19–20).<br />

Pullum und Scholz (2002, 46) weisen auf ein interessantes Paradox in Bezug auf (60c)<br />

hin: Ohne Ergebnisse aus der mathematischen Lerntheorie kann man (60c) nicht leisten.<br />

Wenn man funktionierende Poverty-of-the-Stimulus-Argumente führen will, muss das automatisch<br />

zu Verbesserungen in der Lerntheorie führen, d. h., man kann dann mehr lernen,<br />

als man vorher angenommen hatte.<br />

11.1.8.3 Unsupervised Data-Oriented Parsing (U-DOP)<br />

Bod (2009b) hat ein Verfahren entwickelt, mit dem man aus einem Korpus Strukturen<br />

ableiten kann. Das Verfahren benötigt keine Information über Wortarten oder Beziehungen<br />

zwischen Wörtern in Äußerungen. Die einzige Annahme, die man machen muss, ist, dass<br />

es überhaupt Struktur gibt. Das Verfahren besteht aus drei Schritten:<br />

1. Berechne alle möglichen (binär verzweigenden) Bäume (ohne Kategoriesymbole)<br />

für eine Menge gegebener Sätze.<br />

2. Teile diese Bäume in alle Teilbäume auf.<br />

3. Berechne den besten Baum für jeden Satz.<br />

Das Verfahren soll anhand der Sätze in (61) erklärt werden:<br />

(61) a. Watch the dog.<br />

b. The dog barks.<br />

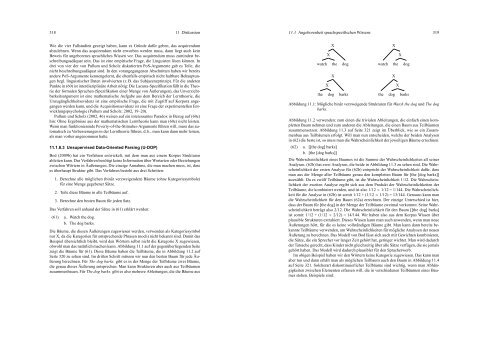

Die Bäume, die diesen Äußerungen zugewiesen werden, verwenden als Kategoriesymbol<br />

nur X, da die Kategorien für entsprechende Phrasen (noch) nicht bekannt sind. Damit das<br />

Beispiel übersichtlich bleibt, wird den Wörtern selbst nicht die Kategorie X zugewiesen,<br />

obwohl man das natürlich machen kann. Abbildung 11.1 auf der gegenüberliegenden Seite<br />

zeigt die Bäume für (61). Diese Bäume haben die Teilbäume, die in Abbildung 11.2 auf<br />

Seite 320 zu sehen sind. Im dritten Schritt müssen wir nun den besten Baum für jede Äußerung<br />

berechnen. Für The dog barks. gibt es in der Menge der Teilbäume zwei Bäume,<br />

die genau dieser Äußerung entsprechen. Man kann Strukturen aber auch aus Teilbäumen<br />

zusammenbauen. Für The dog barks. gibt es also mehrere Ableitungen, die die Bäume aus<br />

11.1 Angeborenheit sprachspezifischen Wissens 319<br />

X<br />

X<br />

watch the dog<br />

X<br />

X<br />

the dog barks<br />

X<br />

X<br />

watch the dog<br />

X<br />

X<br />

the dog barks<br />

Abbildung 11.1: Mögliche binär verzweigende Strukturen für Watch the dog und The dog<br />

barks.<br />

Abbildung 11.2 verwenden: zum einen die trivialen Ableitungen, die einfach einen kompletten<br />

Baum nehmen und zum anderen die Ableitungen, die einen Baum aus Teilbäumen<br />

zusammensetzen. Abbildung 11.3 auf Seite 321 zeigt im Überblick, wie so ein Zusammenbau<br />

aus Teilbäumen erfolgt. Will man nun entscheiden, welche der beiden Analysen<br />

in (62) die beste ist, so muss man die Wahrscheinlichkeit der jeweiligen Bäume errechnen.<br />

(62) a. [[the dog] barks]<br />

b. [the [dog barks]]<br />

Die Wahrscheinlichkeit eines Baumes ist die Summe der Wahrscheinlichkeiten all seiner<br />

Analysen. (62b) hat zwei Analysen, die beide in Abbildung 11.3 zu sehen sind. Die Wahrscheinlichkeit<br />

der ersten Analyse für (62b) entspricht der Wahrscheinlichkeit dafür, dass<br />

man aus der Menge aller Teilbäume genau den kompletten Baum für [the [dog barks]]<br />

auswählt. Da es zwölf Teilbäume gibt, ist die Wahrscheinlichkeit 1/12. Die Wahrscheinlichkeit<br />

der zweiten Analyse ergibt sich aus dem Produkt der Wahrscheinlichkeiten der<br />

Teilbäume, die kombiniert werden, und ist also 1/12 × 1/12 = 1/144. Die Wahrscheinlichkeit<br />

für die Analyse in (62b) ist somit 1/12 + (1/12 × 1/12) = 13/144. Genauso kann man<br />

die Wahrscheinlichkeit für den Baum (62a) errechnen. Der einzige Unterschied ist hier,<br />

dass der Baum für [the dog] in der Menge der Teilbäume zweimal vorkommt. Seine Wahrscheinlichkeit<br />

beträgt also 2/12. Die Wahrscheinlichkeit für den Baum [[the dog] barks]<br />

ist somit: 1/12 + (1/12 × 2/12) = 14/144. Wir haben also aus dem Korpus Wissen über<br />

plausible Strukturen extrahiert. Dieses Wissen kann man auch anwenden, wenn man neue<br />

Äußerungen hört, für die es keine vollständigen Bäume gibt. Man kann dann bereits bekannte<br />

Teilbäume verwenden, um Wahrscheinlichkeiten für mögliche Analysen der neuen<br />

Äußerung zu berechnen. Das Modell von Bod lässt sich auch mit Gewichten kombinieren,<br />

die Sätze, die ein Sprecher vor langer Zeit gehört hat, geringer wichtet. Man wird dadurch<br />

der Tatsache gerecht, dass Kinder nicht gleichzeitig über alle Sätze verfügen, die sie jemals<br />

gehört haben. Das Modell wird dadurch plausibler für den Spracherwerb.<br />

Im obigen Beispiel haben wir den Wörtern keine Kategorie zugewiesen. Das kann man<br />

aber tun und dann erhält man als möglichen Teilbaum auch den Baum in Abbildung 11.4<br />

auf Seite 321. Solcherart diskontinuierlicher Teilbäume sind wichtig, wenn man Abhängigkeiten<br />

zwischen Elementen erfassen will, die in verschiedenen Teilbäumen eines Baumes<br />

stehen. Beispiele sind: