Diplomarbeit von Michael Schindler

Diplomarbeit von Michael Schindler

Diplomarbeit von Michael Schindler

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

2.1 Die Kopplung <strong>von</strong> Lern- und Systemdynamik 47<br />

<strong>von</strong> lokalen Momenten statt. Auch hier lässt sich eine ähnliche Gleichheit <strong>von</strong> zweitem<br />

lokalem Moment σ2 S des Systems und σ2krit vermuten, die den nächsten Phasenübergang<br />

verursacht. Insgesamt ist der univar-Algorithmus auf randomisierten Daten also ein<br />

Raumskalendetektor.<br />

Randomisierte Daten<br />

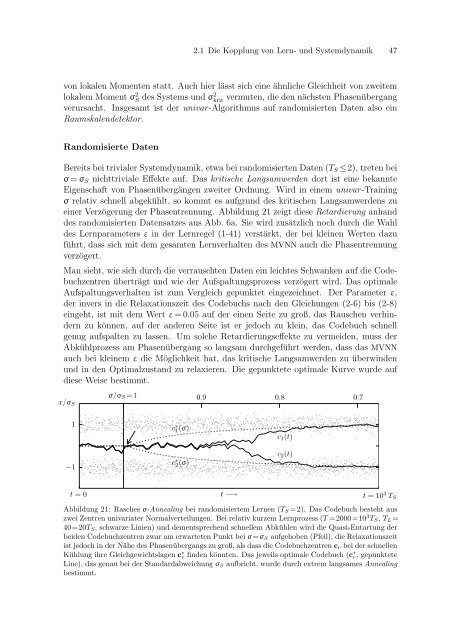

Bereits bei trivialer Systemdynamik, etwa bei randomisierten Daten (TS ≤2), treten bei<br />

σ = σS nichttriviale Effekte auf. Das kritische Langsamwerden dort ist eine bekannte<br />

Eigenschaft <strong>von</strong> Phasenübergängen zweiter Ordnung. Wird in einem univar-Training<br />

σ relativ schnell abgekühlt, so kommt es aufgrund des kritischen Langsamwerdens zu<br />

einer Verzögerung der Phasentrennung. Abbildung 21 zeigt diese Retardierung anhand<br />

des randomisierten Datensatzes aus Abb. 6a. Sie wird zusätzlich noch durch die Wahl<br />

des Lernparameters ε in der Lernregel (1-41) verstärkt, der bei kleinen Werten dazu<br />

führt, dass sich mit dem gesamten Lernverhalten des MVNN auch die Phasentrennung<br />

verzögert.<br />

Man sieht, wie sich durch die verrauschten Daten ein leichtes Schwanken auf die Codebuchzentren<br />

überträgt und wie der Aufspaltungsprozess verzögert wird. Das optimale<br />

Aufspaltungsverhalten ist zum Vergleich gepunktet eingezeichnet. Der Parameter ε,<br />

der invers in die Relaxationszeit des Codebuchs nach den Gleichungen (2-6) bis (2-8)<br />

eingeht, ist mit dem Wert ε = 0.05 auf der einen Seite zu groß, das Rauschen verhindern<br />

zu können, auf der anderen Seite ist er jedoch zu klein, das Codebuch schnell<br />

genug aufspalten zu lassen. Um solche Retardierungseffekte zu vermeiden, muss der<br />

Abkühlprozess am Phasenübergang so langsam durchgeführt werden, dass das MVNN<br />

auch bei kleinem ε die Möglichkeit hat, das kritische Langsamwerden zu überwinden<br />

und in den Optimalzustand zu relaxieren. Die gepunktete optimale Kurve wurde auf<br />

diese Weise bestimmt.<br />

x/σS<br />

1<br />

−1<br />

σ/σS =1 0.9 0.8 0.7<br />

c ∗ 1 (σ)<br />

c ∗ 2 (σ)<br />

t = 0 t −→ t = 10 3 TS<br />

Abbildung 21: Rasches σ-Annealing bei randomisiertem Lernen (TS =2). Das Codebuch besteht aus<br />

zwei Zentren univariater Normalverteilungen. Bei relativ kurzem Lernprozess (T =2000=10 3 TS, TL=<br />

40=20TS, schwarze Linien) und dementsprechend schnellem Abkühlen wird die Quasi-Entartung der<br />

beiden Codebuchzentren zwar am erwarteten Punkt bei σ=σS aufgehoben (Pfeil), die Relaxationszeit<br />

ist jedoch in der Nähe des Phasenübergangs zu groß, als dass die Codebuchzentren cr bei der schnellen<br />

Kühlung ihre Gleichgewichtslagen c ∗ r finden könnten. Das jeweils optimale Codebuch (c ∗ r, gepunktete<br />

Line), das genau bei der Standardabweichung σS aufbricht, wurde durch extrem langsames Annealing<br />

bestimmt.<br />

c1(t)<br />

c2(t)