Introduction à la commande stochastique v.0.9 - Jean-Pierre ...

Introduction à la commande stochastique v.0.9 - Jean-Pierre ...

Introduction à la commande stochastique v.0.9 - Jean-Pierre ...

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

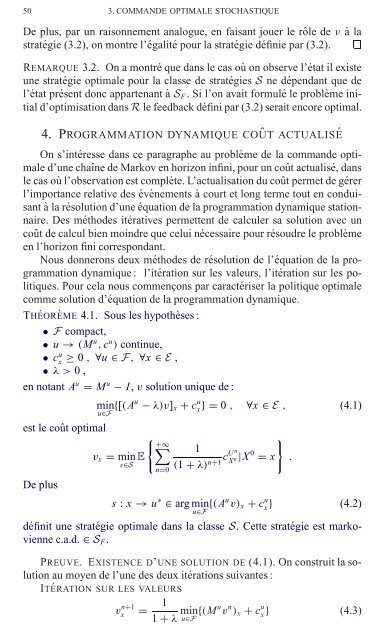

50 3. COMMANDE OPTIMALE STOCHASTIQUE<br />

De plus, par un raisonnement analogue, en faisant jouer le rôle de ν <strong>à</strong><strong>la</strong><br />

stratégie (3.2), on montre l’égalité pour <strong>la</strong> stratégie définie par (3.2).<br />

REMARQUE 3.2. On a montré que dans le cas oùonobservel’état il existe<br />

une stratégie optimale pour <strong>la</strong> c<strong>la</strong>sse de stratégies S ne dépendant que de<br />

l’état présent donc appartenant <strong>à</strong> S F . Si l’on avait formulé le problème initial<br />

d’optimisation dans R le feedback défini par (3.2) serait encore optimal.<br />

4. PROGRAMMATION DYNAMIQUE COÛT ACTUALISÉ<br />

On s’intéresse dans ce paragraphe au problème de <strong>la</strong> <strong>commande</strong> optimale<br />

d’une chaîne de Markov en horizon infini, pour un coût actualisé, dans<br />

le cas où l’observation est complète. L’actualisation du coût permet de gérer<br />

l’importance re<strong>la</strong>tive des évènements <strong>à</strong> court et long terme tout en conduisant<br />

<strong>à</strong><strong>la</strong>résolution d’une équation de <strong>la</strong> programmation dynamique stationnaire.<br />

Des méthodes itératives permettent de calculer sa solution avec un<br />

coût de calcul bien moindre que celui nécessaire pour résoudre le problème<br />

en l’horizon fini correspondant.<br />

Nous donnerons deux méthodes de résolution de l’équation de <strong>la</strong> programmation<br />

dynamique : l’itération sur les valeurs, l’itération sur les politiques.<br />

Pour ce<strong>la</strong> nous commençons par caractériser <strong>la</strong> politique optimale<br />

comme solution d’équation de <strong>la</strong> programmation dynamique.<br />

THÉORÈME 4.1. Sous les hypothèses :<br />

• F compact,<br />

• u → (M u , c u ) continue,<br />

• c u x<br />

≥ 0 , ∀u ∈ F, ∀x ∈ E ,<br />

• λ>0,<br />

en notant A u = M u − I , v solution unique de :<br />

min<br />

u∈F {[(Au − λ)v] x + c u x }=0 , ∀x ∈ E , (4.1)<br />

est le coût optimal<br />

{ }<br />

+∞<br />

v x = min E ∑ 1<br />

n<br />

cU<br />

s∈S (1 + λ)<br />

n+1 X |X 0 = x .<br />

n<br />

n=0<br />

De plus<br />

s : x → u ∗ ∈ arg min<br />

u∈F {(Au v) x + c u x } (4.2)<br />

définit une stratégie optimale dans <strong>la</strong> c<strong>la</strong>sse S. Cette stratégie est markovienne<br />

c.a.d. ∈ S F .<br />

PREUVE. EXISTENCE D’UNE SOLUTION DE (4.1). On construit <strong>la</strong> solution<br />

au moyen de l’une des deux itérations suivantes :<br />

ITÉRATION SUR LES VALEURS<br />

v n+1<br />

x = 1<br />

1 + λ min<br />

u∈F {(Mu v n ) x + c u x } (4.3)