Nichtlineare Methoden zur Quantifizierung von Abhängigkeiten und ...

Nichtlineare Methoden zur Quantifizierung von Abhängigkeiten und ...

Nichtlineare Methoden zur Quantifizierung von Abhängigkeiten und ...

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

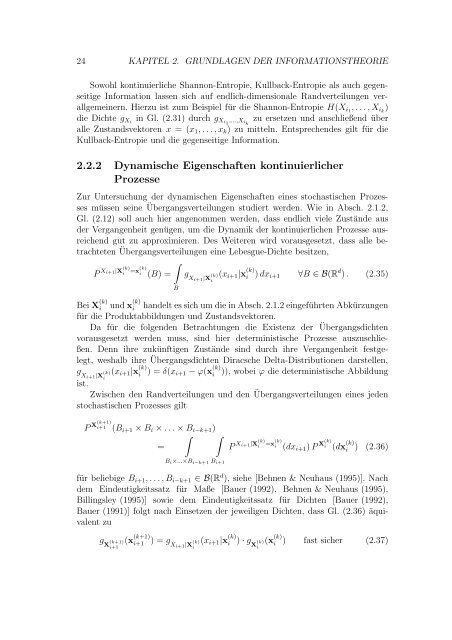

24 KAPITEL 2. GRUNDLAGEN DER INFORMATIONSTHEORIE<br />

Sowohl kontinuierliche Shannon-Entropie, Kullback-Entropie als auch gegenseitige<br />

Information lassen sich auf endlich-dimensionale Randverteilungen verallgemeinern.<br />

Hierzu ist zum Beispiel für die Shannon-Entropie H(X i1 , . . . , X ik )<br />

die Dichte g Xi in Gl. (2.31) durch g Xi1 ,...,X ik<br />

zu ersetzen <strong>und</strong> anschließend über<br />

alle Zustandsvektoren x = (x 1 , . . . , x k ) zu mitteln. Entsprechendes gilt für die<br />

Kullback-Entropie <strong>und</strong> die gegenseitige Information.<br />

2.2.2 Dynamische Eigenschaften kontinuierlicher<br />

Prozesse<br />

Zur Untersuchung der dynamischen Eigenschaften eines stochastischen Prozesses<br />

müssen seine Übergangsverteilungen studiert werden. Wie in Absch. 2.1.2,<br />

Gl. (2.12) soll auch hier angenommen werden, dass endlich viele Zustände aus<br />

der Vergangenheit genügen, um die Dynamik der kontinuierlichen Prozesse ausreichend<br />

gut zu approximieren. Des Weiteren wird vorausgesetzt, dass alle betrachteten<br />

Übergangsverteilungen eine Lebesgue-Dichte besitzen,<br />

P X i+1|X (k)<br />

i =x (k)<br />

i (B) =<br />

∫<br />

B<br />

g Xi+1<br />

(x<br />

|X (k) i+1 |x (k)<br />

i ) dx i+1 ∀B ∈ B(R d ) . (2.35)<br />

i<br />

Bei X (k)<br />

i <strong>und</strong> x (k)<br />

i handelt es sich um die in Absch. 2.1.2 eingeführten Abkürzungen<br />

für die Produktabbildungen <strong>und</strong> Zustandsvektoren.<br />

Da für die folgenden Betrachtungen die Existenz der Übergangsdichten<br />

vorausgesetzt werden muss, sind hier deterministische Prozesse auszuschließen.<br />

Denn ihre zukünftigen Zustände sind durch ihre Vergangenheit festgelegt,<br />

weshalb ihre Übergangsdichten Diracsche Delta-Distributionen darstellen,<br />

g Xi+1<br />

(x<br />

|X (k) i+1 |x (k)<br />

i ) = δ(x i+1 − ϕ(x (k)<br />

i )), wobei ϕ die deterministische Abbildung<br />

i<br />

ist.<br />

Zwischen den Randverteilungen <strong>und</strong> den Übergangsverteilungen eines jeden<br />

stochastischen Prozesses gilt<br />

P X(k+1)<br />

i+1 (B i+1 × B i × . . . × B i−k+1 )<br />

∫ ∫<br />

=<br />

P X i+1|X (k)<br />

i<br />

=x (k)<br />

i<br />

(dx i+1 ) P X(k) i (dx (k)<br />

i ) (2.36)<br />

B i ×...×B i−k+1 B i+1<br />

für beliebige B i+1 , . . . , B i−k+1 ∈ B(R d ), siehe [Behnen & Neuhaus (1995)]. Nach<br />

dem Eindeutigkeitssatz für Maße [Bauer (1992), Behnen & Neuhaus (1995),<br />

Billingsley (1995)] sowie dem Eindeutigkeitssatz für Dichten [Bauer (1992),<br />

Bauer (1991)] folgt nach Einsetzen der jeweiligen Dichten, dass Gl. (2.36) äquivalent<br />

zu<br />

g (k+1) X<br />

(x (k+1)<br />

i+1<br />

i+1 ) = g Xi+1 |X (k)<br />

i<br />

(x i+1 |x (k)<br />

i<br />

) · g X<br />

(k)<br />

i<br />

(x (k)<br />

i ) fast sicher (2.37)