Appunti di Teoria dell'Informazione e Codici - Università di Palermo

Appunti di Teoria dell'Informazione e Codici - Università di Palermo

Appunti di Teoria dell'Informazione e Codici - Università di Palermo

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

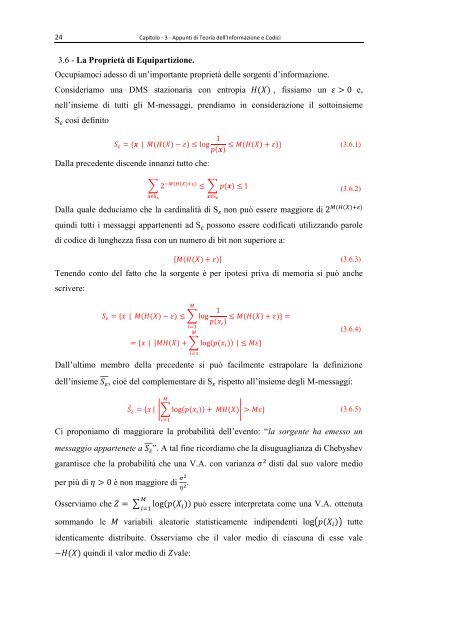

24 Capitolo - 3 - <strong>Appunti</strong> <strong>di</strong> <strong>Teoria</strong> dell’Informazione e Co<strong>di</strong>ci<br />

3.6 - La Proprietà <strong>di</strong> Equipartizione.<br />

Occupiamoci adesso <strong>di</strong> un’importante proprietà delle sorgenti d’informazione.<br />

Consideriamo una DMS stazionaria con entropia ( ) , fissiamo un e,<br />

nell’insieme <strong>di</strong> tutti gli M-messaggi, pren<strong>di</strong>amo in considerazione il sottoinsieme<br />

S così definito<br />

( ( ) )<br />

Dalla precedente <strong>di</strong>scende innanzi tutto che:<br />

( )<br />

( ( ) ) (3.6.1)<br />

∑<br />

( ( ) )<br />

S<br />

∑ ( )<br />

(3.6.2)<br />

( ( ) )<br />

Dalla quale deduciamo che la car<strong>di</strong>nalità <strong>di</strong> S non può essere maggiore <strong>di</strong><br />

quin<strong>di</strong> tutti i messaggi appartenenti ad S possono essere co<strong>di</strong>ficati utilizzando parole<br />

<strong>di</strong> co<strong>di</strong>ce <strong>di</strong> lunghezza fissa con un numero <strong>di</strong> bit non superiore a:<br />

( ( ) ) (3.6.3)<br />

Tenendo conto del fatto che la sorgente è per ipotesi priva <strong>di</strong> memoria si può anche<br />

scrivere:<br />

S<br />

( ( ) ) ∑<br />

( )<br />

( ) ∑ ( ( ))<br />

( ( ) )<br />

(3.6.4)<br />

Dall’ultimo membro della precedente si può facilmente estrapolare la definizione<br />

dell’insieme<br />

, cioè del complementare <strong>di</strong> S rispetto all’insieme degli M-messaggi:<br />

¯ |∑ ( ( )) ( )| (3.6.5)<br />

Ci proponiamo <strong>di</strong> maggiorare la probabilità dell’evento: “la sorgente ha emesso un<br />

messaggio appartenete a ”. A tal fine ricor<strong>di</strong>amo che la <strong>di</strong>suguaglianza <strong>di</strong> Chebyshev<br />

garantisce che la probabilità che una V.A. con varianza <strong>di</strong>sti dal suo valore me<strong>di</strong>o<br />

per più <strong>di</strong> è non maggiore <strong>di</strong> .<br />

Osserviamo che ∑ ( ( )) può essere interpretata come una V.A. ottenuta<br />

sommando le variabili aleatorie statisticamente in<strong>di</strong>pendenti ( ( )) tutte<br />

identicamente <strong>di</strong>stribuite. Osserviamo che il valor me<strong>di</strong>o <strong>di</strong> ciascuna <strong>di</strong> esse vale<br />

( ) quin<strong>di</strong> il valor me<strong>di</strong>o <strong>di</strong> vale: