Modelos para Dados de Contagem com Estrutura Temporal

Modelos para Dados de Contagem com Estrutura Temporal

Modelos para Dados de Contagem com Estrutura Temporal

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

os algoritmos <strong>de</strong> MCMC mais utilizados estão o amostrador <strong>de</strong> Gibbs e o algoritmo <strong>de</strong><br />

Metropolis-Hastings, que serão <strong>de</strong>scritos a seguir.<br />

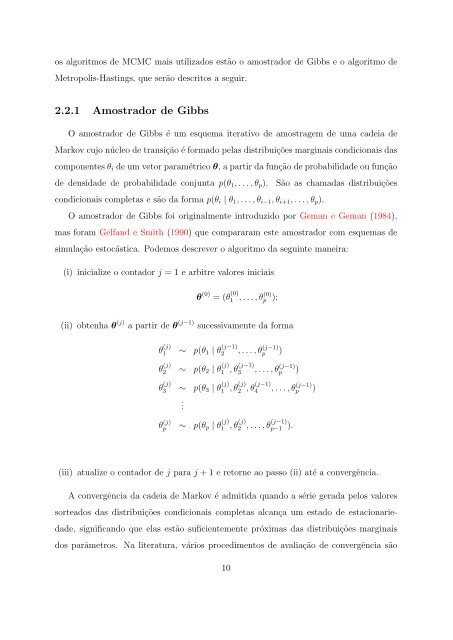

2.2.1 Amostrador <strong>de</strong> Gibbs<br />

O amostrador <strong>de</strong> Gibbs é um esquema iterativo <strong>de</strong> amostragem <strong>de</strong> uma ca<strong>de</strong>ia <strong>de</strong><br />

Markov cujo núcleo <strong>de</strong> transição é formado pelas distribuições marginais condicionais das<br />

<strong>com</strong>ponentes θ i <strong>de</strong> um vetor <strong>para</strong>métrico θ, a partir da função <strong>de</strong> probabilida<strong>de</strong> ou função<br />

<strong>de</strong> <strong>de</strong>nsida<strong>de</strong> <strong>de</strong> probabilida<strong>de</strong> conjunta p(θ 1 , . . . , θ p ).<br />

condicionais <strong>com</strong>pletas e são da forma p(θ i | θ 1 , . . . , θ i−1 , θ i+1 , . . . , θ p ).<br />

São as chamadas distribuições<br />

O amostrador <strong>de</strong> Gibbs foi originalmente introduzido por Geman e Geman (1984),<br />

mas foram Gelfand e Smith (1990) que <strong>com</strong><strong>para</strong>ram este amostrador <strong>com</strong> esquemas <strong>de</strong><br />

simulação estocástica. Po<strong>de</strong>mos <strong>de</strong>screver o algoritmo da seguinte maneira:<br />

(i) inicialize o contador j = 1 e arbitre valores iniciais<br />

θ (0) = (θ (0)<br />

1 , . . . , θ (0)<br />

p );<br />

(ii) obtenha θ (j) a partir <strong>de</strong> θ (j−1) sucessivamente da forma<br />

θ (j)<br />

1 ∼ p(θ 1 | θ (j−1)<br />

2 , . . . , θ (j−1)<br />

p )<br />

θ (j)<br />

2 ∼ p(θ 2 | θ (j)<br />

1 , θ (j−1)<br />

3 , . . . , θ (j−1)<br />

p )<br />

θ (j)<br />

3 ∼ p(θ 3 | θ (j)<br />

1 , θ (j)<br />

2 , θ (j−1)<br />

4 , . . . , θ (j−1)<br />

p )<br />

.<br />

θ (j)<br />

p ∼ p(θ p | θ (j)<br />

1 , θ (j)<br />

2 , . . . , θ (j−1)<br />

p−1 ).<br />

(iii) atualize o contador <strong>de</strong> j <strong>para</strong> j + 1 e retorne ao passo (ii) até a convergência.<br />

A convergência da ca<strong>de</strong>ia <strong>de</strong> Markov é admitida quando a série gerada pelos valores<br />

sorteados das distribuições condicionais <strong>com</strong>pletas alcança um estado <strong>de</strong> estacionarieda<strong>de</strong>,<br />

significando que elas estão suficientemente próximas das distribuições marginais<br />

dos parâmetros. Na literatura, vários procedimentos <strong>de</strong> avaliação <strong>de</strong> convergência são<br />

10