112 CHAPITRE 6. ESTIMATIONRemarque 2.1.2. La définition ci-dessus est valable que θ soit un réel ou un vecteur. Si l’on désire par exempleestimer les paramètres µ <strong>et</strong> σ pour une variable aléatoire de loi normale, on aura : θ = (θ 1 , θ 2 ) = (µ, σ) ∈ R 2 .Nous n’étudierons dans c<strong>et</strong>te section que le cas où la variable aléatoire sera à valeurs dans R <strong>et</strong> où le paramètresera un réel.Définition 2.1.3 (Estimateur – Estimation ponctuelle). Soit (P e )un problème d’estimation. On appelle estimateurtoute variable aléatoire T (Y 1 , . . . , Y n ), où (Y 1 , . . . , Y n ) est un n-échantillon aléatoire, ayant pour but d’estimer leparamètre θ. On appelle valeur estimée ou estimation ponctuelle ou estimation par point ou encore estimation laquantité ˆθ = T (y 1 , . . . , y n ) obtenue à partir d’un n-échantillon (y 1 , . . . , y n ).Définition 2.1.4 (Estimation par intervalle – Intervalle de confiance). Soit (P e ) un problème d’estimation où θest réel. On appelle estimation par intervalle ou intervalle de confiance au niveau 1 − α tout intervalle [ˆθ 1 ; ˆθ 2 ] telque la probabilité que c<strong>et</strong>te intervalle contienne la valeur du paramètre θ soit égale à 1 − α.Remarque 2.1.5. (i) L’avantage d’avoir un intervalle de confiance est que l’on a ainsi une idée de la précisionde l’estimation.(ii) Dire que l’intervalle recouvre la valeur du paramètre θ, c’est dire que θ est dans l’intervalle. Nous pouvonsdonc prendre comme définition d’un intervalle de confiance tout intervalle tel que :P (θ ∈ [ˆθ 1 ; ˆθ 2 ]) = 1 − α (6.1)Par abus de langage nous dirons que θ appartient à l’intervalle [ˆθ 1 ; ˆθ 2 ] au niveau 1−α. Il faut bien comprendreen eff<strong>et</strong> que dans l’équation ci-dessus θ est une constante (c’est ce que l’on cherche à estimer). C’est l’intervallequi est ici aléatoire. Si l’on désire par exemple avoir un intervalle de confiance d’un taux de germination, nousréaliserons concrètrement l’expérience consistant à m<strong>et</strong>tre à germer n graines. A partir des résultats de c<strong>et</strong>teexpérience, nous construirons l’intervalle de confiance du taux de germination (voir la sous section (3.3)) .Si nous réalisons une nouvelle fois c<strong>et</strong>te expérience nous obtiendrons un nouvel intervalle de confiance. C’estdonc bien c<strong>et</strong> intervalle qui varie <strong>et</strong> non pas le taux de germination qui est ce qu’il est. Par conséquent écrireθ ∈ [ˆθ 1 ; ˆθ 2 ] au niveau 1−α n’est pas très rigoureux car θ, qui est une constante soit appartient à c<strong>et</strong> intervalle,soit est hors de c<strong>et</strong> intervalle ; il ne peut y être avec une probabilité de 1 − α. La bonne formulation seraitde dire que l’intervalle [ˆθ 1 ; ˆθ 2 ] recouvre la vraie valeur du paramètre θ avec la probabilié de (1 − α). Maisl’habitude veut que l’on emploie la première formulation.Nous allons maintenant voir les propriétés que doit posséder tout ”bon” estimateur.2.2 Propriétés des estimateursLa première chose que l’on demande à un estimateur est de ne pas faire d’erreur systématique, c’est-à-dire quel’estimateur donne ”en moyenne” la bonne valeur du paramètre recherché. C’est la notion d’estimateur sans biais.Définition 2.2.1 (Estimation sans biais). Soit (P e ) un problème d’estimation. Un estimateur T est dit sans biaissi <strong>et</strong> seulement si l’espérance mathématique de T est égale à la valeur du paramètre θ cherchée :E(T ) = θDéfinition 2.2.2 (Estimation asymptotiquement sans biais). Soit (P e ) un problème d’estimation. Un estimateurT n est dit asymptotiquement sans biais si <strong>et</strong> seulement si l’espérance mathématique de T n tend vers la valeur duparamètre θ cherchée quand n tend vers +∞ :E(T n ) −→ θn −→ +∞Exemple 2.2.3. Considérons le problème de l’estimation d’une variance σ 2 dans le cas où la variable aléatoiresuit une loi normale. Soit donc (Y 1 , . . . , Y n ) un n-échantillon aléatoire Bernoullien de la variable aléatoire X donton cherche à estimer la variance. Considérons l’estimateurT (Y 1 , . . . , Y n ) = 1 nNous avons alors vu au théorème (4.4.2.1) que l’on an∑(Y i − Ȳ )2 = S 2 (Y )i=1E(T ) = E(S 2 ) = n − 1nσ2

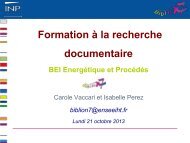

2. PRINCIPES GÉNÉRAUX 113Par suite S 2 n’est pas un estimateur sans biais de σ 2 . Pour obtenir un estimateur sans biais il faut en fait prendre :T (Y 1 , . . . , Y n ) = 1 n∑(Y i −n − 1 Ȳ )2 = nn − 1 S2 (Y )En eff<strong>et</strong> la propriété de linéarité le l’espérance mathématique donne immédiatement :( ) nEn − 1 S2 = nn − 1 E ( S 2) = σ 2i=1Illustrons ceci par la simulation. Construisons 5000 échantillons de taille 5 de données provenant d’une loi normaleN (100, 25). Pour chacun des 5000 échantillons nous calculons la quantité SCE/n. Nous obtenons ainsi5000 réalisations de la variable aléatoire S 2 . Traçons alors l’histogramme de ces 5000 nombres. Nous obtenons ledeuxième graphique de la figure (6.2). Si maintenant pour les mêmes 5000 échantillons nous calculons les quantitésSCE/(n − 1), nous obtenons 5000 réalisations de la variable aléatoire n/(n − 1)S 2 . L’histogramme de ces 5000valeurs nous donne alors le troisième graphique de la figure (6.2).0.1Données0.05SCE/n0.080.040.060.030.040.020.020.01085 90 95 100 105 110 11500 25 900.05SCE/(n−1)0.040.030.020.0100 25 90Fig. 6.2 – Echantillonnage de S 2 <strong>et</strong> de nS 2 /(n − 1)Nous pouvons observer que la valeur moyenne obtenue pour le troisème graphique est bien la valeur de lavariance σ 2 recherchée alors que sur le deuxième elle est inférieure (la valeur est de 4/5σ 2 )Remarque 2.2.4. Nous tenons a rapeller ici que l’illustration via la simulation informatique n’est qu’une illustration.Il faudrait en fait non pas prendre 5000 échantillons, mais une infinité. Ce sont les théorèmes mathématiquesqui nous perm<strong>et</strong>tent d’affirmer que le résultat est bien exact.n−1nS 2 n’est pas un estimateur de la variance sans biais, mais il est asymptotiquement sans biais puisque E(S 2 ) =σ2 tend vers σ 2 quand n tend vers +∞.Une deuxième propriété, qui est fondamentale, que doit avoir tout ”bon” estimateur est que si l’on a suffisammentde données la valeur de la variable aléatoire soit très proche de la valeur du paramètre recherché. Ceci ce traduit parle fait que l’estimateur soit asymptotiquement sans biais <strong>et</strong> qu’il fluctue peu autour de son espérance mathématiquelorsque n est grand, c’est-à-dire que sa variance soit p<strong>et</strong>ite pour n grand. Nous débouchons ainsi sur la notiond’estimateur convergent.Définition 2.2.5 (Estimateur convergent). Soit (P e ) un problème d’estimation. Un estimateur T n est dit convergentsi <strong>et</strong> seulement si il est asymptotiquement sans biais <strong>et</strong> si sa variance tend vers 0 quand n tend vers +∞ :E(T n ) −→ θ <strong>et</strong> V ar(T n ) −→ 0n −→ +∞ n −→ +∞Exemple 2.2.6. Considérons le problème de l’estimation d’une moyenne µ. Soit donc (Y 1 , . . . , Y n ) un n-échantillonaléatoire Bernoullien de la variable aléatoire X dont on cherche à estimer la moyenne. Considérons l’estimateurT n (Y 1 , . . . , Y n ) = Ȳn = 1 n∑Y inNous savons alors que : E(Ȳn) = µ pour tout n. Par suite c<strong>et</strong> estimateur est sans biais <strong>et</strong> donc asympotiquementsans biais. Quand à la variance de c<strong>et</strong> estimateur elle est :V ar(Ȳn) = σ2nPar suite c<strong>et</strong> estimateur est un estimateur convergent.i=1