Télécharger le texte intégral - ISPED-Enseignement à distance

Télécharger le texte intégral - ISPED-Enseignement à distance

Télécharger le texte intégral - ISPED-Enseignement à distance

- No tags were found...

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

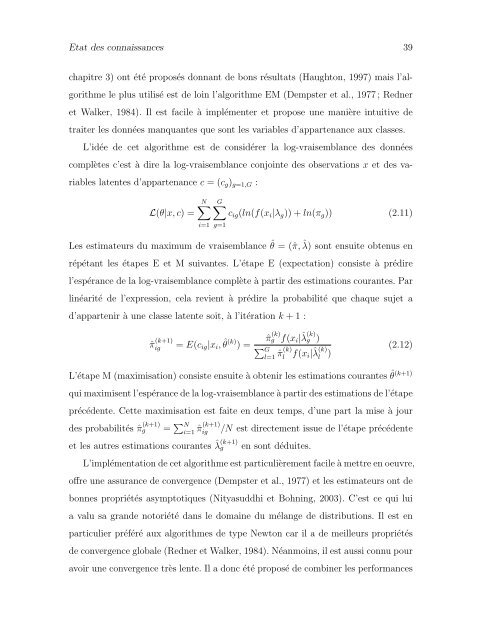

Etat des connaissances 39chapitre 3) ont été proposés donnant de bons résultats (Haughton, 1997) mais l’algorithme<strong>le</strong> plus utilisé est de loin l’algorithme EM (Dempster et al., 1977 ; Redneret Walker, 1984). Il est faci<strong>le</strong> <strong>à</strong> implémenter et propose une manière intuitive detraiter <strong>le</strong>s données manquantes que sont <strong>le</strong>s variab<strong>le</strong>s d’appartenance aux classes.L’idée de cet algorithme est de considérer la log-vraisemblance des donnéescomplètes c’est <strong>à</strong> dire la log-vraisemblance conjointe des observations x et des variab<strong>le</strong>slatentes d’appartenance c = (c g ) g=1,G :L(θ|x, c) =N∑ G∑c ig (ln(f(x i |λ g )) + ln(π g )) (2.11)i=1 g=1Les estimateurs du maximum de vraisemblance ˆθ = (ˆπ, ˆλ) sont ensuite obtenus enrépétant <strong>le</strong>s étapes E et M suivantes. L’étape E (expectation) consiste <strong>à</strong> prédirel’espérance de la log-vraisemblance complète <strong>à</strong> partir des estimations courantes. Parlinéarité de l’expression, cela revient <strong>à</strong> prédire la probabilité que chaque sujet ad’appartenir <strong>à</strong> une classe latente soit, <strong>à</strong> l’itération k + 1 :ˆπ (k+1)ig = E(c ig |x i , ˆθ (k) ) =ˆπ g(k) f(x i |ˆλ (k)g )∑ Gl=1 ˆπ(k) lf(x i |ˆλ (k)l)(2.12)L’étape M (maximisation) consiste ensuite <strong>à</strong> obtenir <strong>le</strong>s estimations courantesˆθ(k+1)qui maximisent l’espérance de la log-vraisemblance <strong>à</strong> partir des estimations de l’étapeprécédente. Cette maximisation est faite en deux temps, d’une part la mise <strong>à</strong> jourdes probabilités ˆπ (k+1)g= ∑ Ni=1 ˆπ(k+1) ig(k+1) ˆλ get <strong>le</strong>s autres estimations courantes/N est directement issue de l’étape précédenteen sont déduites.L’implémentation de cet algorithme est particulièrement faci<strong>le</strong> <strong>à</strong> mettre en oeuvre,offre une assurance de convergence (Dempster et al., 1977) et <strong>le</strong>s estimateurs ont debonnes propriétés asymptotiques (Nityasuddhi et Bohning, 2003). C’est ce qui luia valu sa grande notoriété dans <strong>le</strong> domaine du mélange de distributions. Il est enparticulier préféré aux algorithmes de type Newton car il a de meil<strong>le</strong>urs propriétésde convergence globa<strong>le</strong> (Redner et Walker, 1984). Néanmoins, il est aussi connu pouravoir une convergence très <strong>le</strong>nte. Il a donc été proposé de combiner <strong>le</strong>s performances