- Seite 1 und 2:

Einführung in die Methoden der Kü

- Seite 3 und 4:

Inhaltsverzeichnis 2.1.4 Prozeduren

- Seite 5 und 6:

Inhaltsverzeichnis 5.4.2.1 Lexikon

- Seite 7 und 8:

1 Einleitung 1.1 Themen und Literat

- Seite 9 und 10:

1.2 Was ist Künstliche Intelligenz

- Seite 11 und 12:

1.2 Was ist Künstliche Intelligenz

- Seite 13 und 14:

1.3 Philosophische Aspekte • Auto

- Seite 15 und 16:

1.3 Philosophische Aspekte durch Ge

- Seite 17 und 18:

1.4 KI-Paradigmen Die technische Hy

- Seite 19 und 20:

1.5 Bemerkungen zur Geschichte zur

- Seite 21 und 22:

1.6 Intelligente Agenten Agent Sens

- Seite 23 und 24:

1.6 Intelligente Agenten • Die ak

- Seite 25 und 26:

1.6 Intelligente Agenten Diese Besc

- Seite 27 und 28:

2 Suchverfahren 2.1 Algorithmische

- Seite 29 und 30:

2.1 Algorithmische Suche 1. Dame A-

- Seite 31 und 32:

2.1 Algorithmische Suche kommt, und

- Seite 33 und 34:

2.1 Algorithmische Suche 2.1.4 Proz

- Seite 35 und 36:

2.1 Algorithmische Suche Beachte, d

- Seite 37 und 38:

2.1 Algorithmische Suche bfs goal s

- Seite 39 und 40:

2.1 Algorithmische Suche Bemerkung

- Seite 41 und 42:

2.2 Informierte Suche, Heuristische

- Seite 43 und 44:

2.2 Informierte Suche, Heuristische

- Seite 45 und 46:

2.2 Informierte Suche, Heuristische

- Seite 47 und 48:

2.3 A ∗ -Algorithmus • Baum-Suc

- Seite 49 und 50:

2.3 A ∗ -Algorithmus Z S Rechnet

- Seite 51 und 52:

2.3 A ∗ -Algorithmus Dabei gehen

- Seite 53 und 54:

2.3 A ∗ -Algorithmus • Der Knot

- Seite 55 und 56:

2.3 A ∗ -Algorithmus dann nennt m

- Seite 57 und 58:

2.3 A ∗ -Algorithmus Beispiel 2.3

- Seite 59 und 60:

2.4 Suche in Spielbäumen 2.4 Suche

- Seite 61 und 62:

2.4 Suche in Spielbäumen Algorithm

- Seite 63 und 64:

2.4 Suche in Spielbäumen baum ab e

- Seite 65 und 66:

2.4 Suche in Spielbäumen 2.4.1 Alp

- Seite 67 und 68:

2.4 Suche in Spielbäumen Suche die

- Seite 69 und 70:

2.4 Suche in Spielbäumen Aktualisi

- Seite 71 und 72:

2.4 Suche in Spielbäumen Im Falle

- Seite 73 und 74:

2.4 Suche in Spielbäumen Allerding

- Seite 75 und 76:

2.5 Evolutionäre (Genetische) Algo

- Seite 77 und 78:

2.5 Evolutionäre (Genetische) Algo

- Seite 79 und 80:

2.5 Evolutionäre (Genetische) Algo

- Seite 81 und 82:

2.5 Evolutionäre (Genetische) Algo

- Seite 83 und 84:

2.5 Evolutionäre (Genetische) Algo

- Seite 85 und 86:

2.5 Evolutionäre (Genetische) Algo

- Seite 87 und 88:

3 Aussagenlogik In diesem Kapitel w

- Seite 89 und 90:

3.1 Syntax und Semantik der Aussage

- Seite 91 und 92:

3.2 Folgerungsbegriffe es keine bes

- Seite 93 und 94:

3.3 Tautologien und einige einfache

- Seite 95 und 96:

3.4 Normalformen sind, so dass Vert

- Seite 97 und 98:

3.5 Lineare CNF Beispiel 3.4.7. ((A

- Seite 99 und 100:

3.5 Lineare CNF Bemerkung 3.5.4. Se

- Seite 101 und 102:

3.6 Resolution für Aussagenlogik o

- Seite 103 und 104:

3.6 Resolution für Aussagenlogik T

- Seite 105 und 106:

3.7 DPLL-Verfahren 3.6.1.3 Subsumti

- Seite 107 und 108:

3.7 DPLL-Verfahren Das Entfernen de

- Seite 109 und 110:

3.7 DPLL-Verfahren Dies ergibt eine

- Seite 111 und 112:

3.7 DPLL-Verfahren höchstens einer

- Seite 113 und 114:

3.7 DPLL-Verfahren [[-4,-8,-15,5,-1

- Seite 115 und 116:

3.8 Modellierung von Problemen als

- Seite 117 und 118:

3.8 Modellierung von Problemen als

- Seite 119 und 120:

3.9 Tableaukalkül für Aussagenlog

- Seite 121 und 122:

3.9 Tableaukalkül für Aussagenlog

- Seite 123 und 124:

3.9 Tableaukalkül für Aussagenlog

- Seite 125 und 126:

3.9 Tableaukalkül für Aussagenlog

- Seite 127 und 128:

4 Prädikatenlogik 4.1 Syntax und S

- Seite 129 und 130:

4.1 Syntax und Semantik der Prädik

- Seite 131 und 132:

4.1 Syntax und Semantik der Prädik

- Seite 133 und 134:

4.1 Syntax und Semantik der Prädik

- Seite 135 und 136:

4.1 Syntax und Semantik der Prädik

- Seite 137 und 138:

4.1 Syntax und Semantik der Prädik

- Seite 139 und 140:

4.2 Resolution oder in Mengenschrei

- Seite 141 und 142:

4.2 Resolution Satz 4.2.3. Die Grun

- Seite 143 und 144:

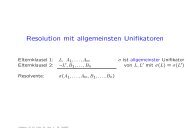

4.2 Resolution Die Operation auf ei

- Seite 145 und 146:

4.2 Resolution 4.2.3 Unifikation Di

- Seite 147 und 148:

4.2 Resolution f(s 1 , . . . , s n

- Seite 149 und 150:

4.4 Löschregeln: Subsumtion, Tauto

- Seite 151 und 152:

4.4 Löschregeln: Subsumtion, Tauto

- Seite 153 und 154:

4.5 Optimierungen und Varianten der

- Seite 155 und 156:

4.5 Optimierungen und Varianten der

- Seite 157 und 158:

4.5 Optimierungen und Varianten der

- Seite 159 und 160:

5.1 Von der Resolution zum Logische

- Seite 161 und 162:

5.1 Von der Resolution zum Logische

- Seite 163 und 164:

5.2 Semantik von Hornklauselprogram

- Seite 165 und 166:

5.2 Semantik von Hornklauselprogram

- Seite 167 und 168:

5.3 Implementierung logischer Progr

- Seite 169 und 170:

5.3 Implementierung logischer Progr

- Seite 171 und 172:

5.3 Implementierung logischer Progr

- Seite 173 und 174:

5.3 Implementierung logischer Progr

- Seite 175 und 176:

5.3 Implementierung logischer Progr

- Seite 177 und 178:

5.3 Implementierung logischer Progr

- Seite 179 und 180:

5.3 Implementierung logischer Progr

- Seite 181 und 182:

5.3 Implementierung logischer Progr

- Seite 183 und 184:

5.3 Implementierung logischer Progr

- Seite 185 und 186:

5.3 Implementierung logischer Progr

- Seite 187 und 188:

5.3 Implementierung logischer Progr

- Seite 189 und 190:

5.4 Sprachverarbeitung und Parsen i

- Seite 191 und 192:

5.4 Sprachverarbeitung und Parsen i

- Seite 193 und 194:

5.4 Sprachverarbeitung und Parsen i

- Seite 195 und 196:

5.4 Sprachverarbeitung und Parsen i

- Seite 197 und 198:

5.4 Sprachverarbeitung und Parsen i

- Seite 199 und 200:

5.4 Sprachverarbeitung und Parsen i

- Seite 201 und 202:

6.1 Allens Zeitintervall-Logik A1:

- Seite 203 und 204:

6.1 Allens Zeitintervall-Logik A

- Seite 205 und 206:

6.2 Darstellung Allenscher Formeln

- Seite 207 und 208:

6.3 Der Allensche Kalkül ≺ ≻ d

- Seite 209 und 210:

6.3 Der Allensche Kalkül • A R A

- Seite 211 und 212:

6.4 Untersuchungen zum Kalkül 6.4

- Seite 213 und 214:

6.4 Untersuchungen zum Kalkül Algo

- Seite 215 und 216:

6.5 Unvollständigkeiten des Allens

- Seite 217 und 218: 6.6 Einge Analysen zur Implementier

- Seite 219 und 220: 6.7 Komplexität Sei eine Instanz g

- Seite 221 und 222: 6.8 Eine polynomielle und vollstän

- Seite 223 und 224: 7.1 Ursprünge Ein Beispiel ist das

- Seite 225 und 226: 7.2 Attributive Konzeptbeschreibung

- Seite 227 und 228: 7.2 Attributive Konzeptbeschreibung

- Seite 229 und 230: 7.2 Attributive Konzeptbeschreibung

- Seite 231 und 232: 7.2 Attributive Konzeptbeschreibung

- Seite 233 und 234: 7.2 Attributive Konzeptbeschreibung

- Seite 235 und 236: 7.3 T-Box und A-Box • SNOMED CT (

- Seite 237 und 238: 7.3 T-Box und A-Box Da diese T-Box

- Seite 239 und 240: 7.3 T-Box und A-Box Als Graph wobei

- Seite 241 und 242: 7.3 T-Box und A-Box kommt aus Huhn

- Seite 243 und 244: 7.3 T-Box und A-Box Dabei sind Pete

- Seite 245 und 246: 7.3 T-Box und A-Box wobei a i Indiv

- Seite 247 und 248: 7.4 Inferenzen in Beschreibungslogi

- Seite 249 und 250: 7.4 Inferenzen in Beschreibungslogi

- Seite 251 und 252: 7.4 Inferenzen in Beschreibungslogi

- Seite 253 und 254: 7.4 Inferenzen in Beschreibungslogi

- Seite 255 und 256: 7.4 Inferenzen in Beschreibungslogi

- Seite 257 und 258: 7.5 Erweiterungen, weitere Frageste

- Seite 259 und 260: 7.5 Erweiterungen, weitere Frageste

- Seite 261 und 262: 7.6 OWL - Die Web Ontology Language

- Seite 263 und 264: 7.6 OWL - Die Web Ontology Language

- Seite 265 und 266: 8.1 Einführung: Maschinelles Lerne

- Seite 267: 8.1 Einführung: Maschinelles Lerne

- Seite 271 und 272: 8.3 Lernen mit Entscheidungsbäumen

- Seite 273 und 274: 8.3 Lernen mit Entscheidungsbäumen

- Seite 275 und 276: 8.3 Lernen mit Entscheidungsbäumen

- Seite 277 und 278: 8.3 Lernen mit Entscheidungsbäumen

- Seite 279 und 280: 8.3 Lernen mit Entscheidungsbäumen

- Seite 281: LITERATUR Russell, S. J. & Norvig,