Mélanges de GLMs et nombre de composantes : application ... - Scor

Mélanges de GLMs et nombre de composantes : application ... - Scor

Mélanges de GLMs et nombre de composantes : application ... - Scor

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

4.2. Sélection <strong>de</strong> modèle mélange<br />

peut donc être un regroupement <strong>de</strong> <strong>composantes</strong> du mélange, typiquement si ces <strong>composantes</strong><br />

se ressemblent. Dans notre étu<strong>de</strong> nous assimilerons les classes (clusters) aux <strong>composantes</strong><br />

du mélange, dans la mesure où notre objectif est justement d’obtenir un mélange final qui<br />

perm<strong>et</strong>te <strong>de</strong> bien distinguer les groupes (<strong>composantes</strong>) entre eux. Les contraintes imposées<br />

sur l’espace <strong>de</strong>s paramètres jouent un rôle prépondérant dans la panoplie <strong>de</strong>s formes que peut<br />

prendre une composante. Pensons par exemple dans le cas gaussien à une contrainte sur la<br />

matrice <strong>de</strong> covariance <strong>de</strong> type Σ i = σi 2 I, alors les <strong>composantes</strong> ne peuvent avoir qu’une forme<br />

d’ellipsoi<strong>de</strong> parallèle aux axes définissant l’espace <strong>de</strong>s observations. Il sera donc important<br />

<strong>de</strong> visualiser la contrainte imposée en fonction <strong>de</strong> la forme <strong>de</strong>s clusters que nous souhaitons<br />

considérer.<br />

4.2.2 Le maximum <strong>de</strong> vraisemblance classifiante conditionnelle<br />

L’estimation par maximum <strong>de</strong> vraisemblance classifiante conditionnelle fait intervenir une<br />

nouvelle quantité : la vraisemblance classifiante conditionnelle. C<strong>et</strong>te fonction est issue <strong>de</strong> la<br />

vision donnée par l’algorithme EM, <strong>et</strong> se rapproche <strong>de</strong> la vraisemblance <strong>de</strong>s données complètes<br />

dont nous avons parlé dans la section précé<strong>de</strong>nte. Dans c<strong>et</strong>te partie nous exhibons dans un<br />

premier temps le lien entre vraisemblance <strong>de</strong>s données observées <strong>et</strong> vraisemblance <strong>de</strong>s données<br />

complètes, afin d’en avoir une interprétation <strong>et</strong> une représentation plus précises. Puis nous<br />

développons un exemple qui non seulement explicite la différence majeure avec l’estimation<br />

par maximum <strong>de</strong> vraisemblance, mais expose également les nouveaux problèmes auxquels nous<br />

sommes confrontés avec l’utilisation <strong>de</strong> c<strong>et</strong>te fonction. L’accent est ensuite mis sur l’étu<strong>de</strong> <strong>de</strong>s<br />

propriétés <strong>de</strong> convergence <strong>de</strong> l’estimateur découlant <strong>de</strong> c<strong>et</strong>te quantité, grâce aux théorèmes<br />

résultant <strong>de</strong> la théorie asymptotique classique que nous adaptons à notre contexte d’étu<strong>de</strong>.<br />

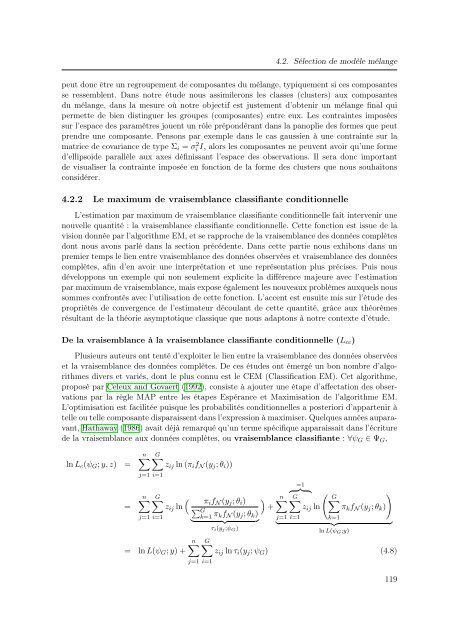

De la vraisemblance à la vraisemblance classifiante conditionnelle (L cc )<br />

Plusieurs auteurs ont tenté d’exploiter le lien entre la vraisemblance <strong>de</strong>s données observées<br />

<strong>et</strong> la vraisemblance <strong>de</strong>s données complètes. De ces étu<strong>de</strong>s ont émergé un bon <strong>nombre</strong> d’algorithmes<br />

divers <strong>et</strong> variés, dont le plus connu est le CEM (Classification EM). C<strong>et</strong> algorithme,<br />

proposé par Celeux and Govaert (1992), consiste à ajouter une étape d’affectation <strong>de</strong>s observations<br />

par la règle MAP entre les étapes Espérance <strong>et</strong> Maximisation <strong>de</strong> l’algorithme EM.<br />

L’optimisation est facilitée puisque les probabilités conditionnelles a posteriori d’appartenir à<br />

telle ou telle composante disparaissent dans l’expression à maximiser. Quelques années auparavant,<br />

Hathaway (1986) avait déjà remarqué qu’un terme spécifique apparaissait dans l’écriture<br />

<strong>de</strong> la vraisemblance aux données complètes, ou vraisemblance classifiante : ∀ψ G ∈ Ψ G ,<br />

ln L c (ψ G ; y, z) =<br />

=<br />

n∑<br />

j=1 i=1<br />

n∑<br />

j=1 i=1<br />

G∑<br />

z ij ln (π i f N (y j ; θ i ))<br />

G∑<br />

(<br />

z ij ln<br />

= ln L(ψ G ; y) +<br />

π i f N (y j ; θ i )<br />

∑ G<br />

k=1 π kf N (y j ; θ k )<br />

} {{ }<br />

τ i (y j ;ψ G )<br />

n∑<br />

j=1 i=1<br />

)<br />

+<br />

=1<br />

{ }} {<br />

(<br />

n∑ G∑<br />

G<br />

)<br />

∑<br />

z ij ln π k f N (y j ; θ k )<br />

j=1 i=1<br />

k=1<br />

} {{ }<br />

ln L(ψ G ;y)<br />

G∑<br />

z ij ln τ i (y j ; ψ G ) (4.8)<br />

119