Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

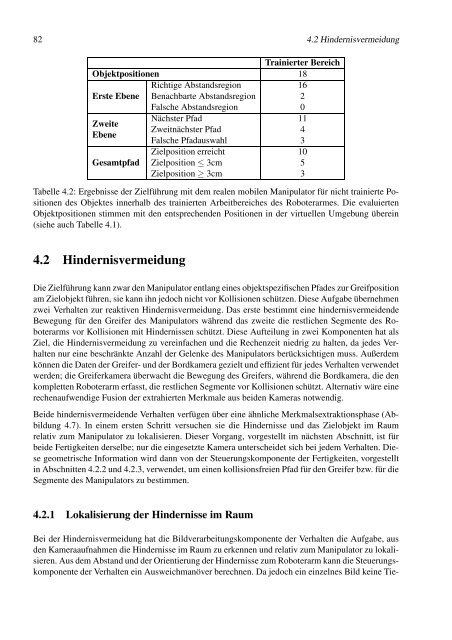

82 4.2 Hindernisvermeidung<br />

Objektpositionen<br />

Trainierter Bereich<br />

18<br />

Richtige Abstandsregion 16<br />

Erste Ebene Benachbarte Abstandsregion 2<br />

Falsche Abstandsregion 0<br />

Zweite<br />

Ebene<br />

Nächster Pfad<br />

Zweitnächster Pfad<br />

Falsche Pfadauswahl<br />

11<br />

4<br />

3<br />

Zielposition erreicht 10<br />

Gesamtpfad Zielposition ≤ 3cm 5<br />

Zielposition ≥ 3cm 3<br />

Tabelle 4.2: Ergebnisse der Zielführung mit dem realen mobilen Manipulator für nicht trainierte Positionen<br />

des Objektes innerhalb des trainierten Arbeitbereiches des Roboterarmes. Die evaluierten<br />

Objektpositionen stimmen mit den entsprechenden Positionen in der virtuellen Umgebung überein<br />

(siehe auch Tabelle 4.1).<br />

4.2 Hindernisvermeidung<br />

Die Zielführung kann zwar den Manipulator entlang eines objektspezifischen Pfades zur Greifposition<br />

am Zielobjekt führen, sie kann ihn jedoch nicht vor Kollisionen schützen. Diese Aufgabe übernehmen<br />

zwei Verhalten zur reaktiven Hindernisvermeidung. Das erste bestimmt eine hindernisvermeidende<br />

Bewegung für den Greifer des Manipulators während das zweite die restlichen Segmente des Roboterarms<br />

vor Kollisionen mit Hindernissen schützt. Diese Aufteilung in zwei Komponenten hat als<br />

Ziel, die Hindernisvermeidung zu vereinfachen und die Rechenzeit niedrig zu halten, da jedes Verhalten<br />

nur eine beschränkte Anzahl der Gelenke des Manipulators berücksichtigen muss. Außerdem<br />

können die Daten der Greifer- und der Bordkamera gezielt und effizient für jedes Verhalten verwendet<br />

werden; die Greiferkamera überwacht die Bewegung des Greifers, während die Bordkamera, die den<br />

kompletten Roboterarm erfasst, die restlichen Segmente vor Kollisionen schützt. Alternativ wäre eine<br />

rechenaufwendige Fusion der extrahierten Merkmale aus beiden Kameras notwendig.<br />

Beide hindernisvermeidende Verhalten verfügen über eine ähnliche Merkmalsextraktionsphase (Abbildung<br />

4.7). In einem ersten Schritt versuchen sie die Hindernisse und das Zielobjekt im Raum<br />

relativ zum Manipulator zu lokalisieren. Dieser Vorgang, vorgestellt im nächsten Abschnitt, ist für<br />

beide Fertigkeiten derselbe; nur die eingesetzte Kamera unterscheidet sich bei jedem Verhalten. Diese<br />

geometrische Information wird dann von der Steuerungskomponente der Fertigkeiten, vorgestellt<br />

in Abschnitten 4.2.2 und 4.2.3, verwendet, um einen kollisionsfreien Pfad für den Greifer bzw. für die<br />

Segmente des Manipulators zu bestimmen.<br />

4.2.1 Lokalisierung der Hindernisse im Raum<br />

Bei der Hindernisvermeidung hat die Bildverarbeitungskomponente der Verhalten die Aufgabe, aus<br />

den Kameraaufnahmen die Hindernisse im Raum zu erkennen und relativ zum Manipulator zu lokalisieren.<br />

Aus dem Abstand und der Orientierung der Hindernisse zum Roboterarm kann die Steuerungskomponente<br />

der Verhalten ein Ausweichmanöver berechnen. Da jedoch ein einzelnes Bild keine Tie-