Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

4.2 Hindernisvermeidung 91<br />

H<br />

1<br />

ρ ρ<br />

2 T<br />

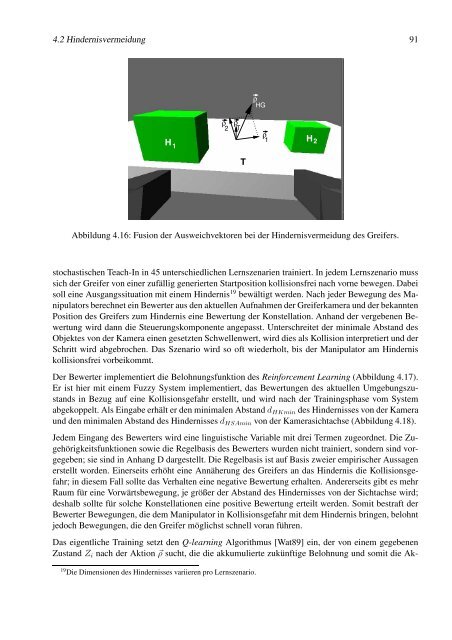

Abbildung 4.16: Fusion der Ausweichvektoren bei der Hindernisvermeidung des Greifers.<br />

stochastischen Teach-In in 45 unterschiedlichen Lernszenarien trainiert. In jedem Lernszenario muss<br />

sich der Greifer von einer zufällig generierten Startposition kollisionsfrei nach vorne bewegen. Dabei<br />

soll eine Ausgangssituation mit einem Hindernis 19 bewältigt werden. Nach jeder Bewegung des Manipulators<br />

berechnet ein Bewerter aus den aktuellen Aufnahmen der Greiferkamera und der bekannten<br />

Position des Greifers zum Hindernis eine Bewertung der Konstellation. Anhand der vergebenen Bewertung<br />

wird dann die Steuerungskomponente angepasst. Unterschreitet der minimale Abstand des<br />

Objektes von der Kamera einen gesetzten Schwellenwert, wird dies als Kollision interpretiert und der<br />

Schritt wird abgebrochen. Das Szenario wird so oft wiederholt, bis der Manipulator am Hindernis<br />

kollisionsfrei vorbeikommt.<br />

Der Bewerter implementiert die Belohnungsfunktion des Reinforcement Learning (Abbildung 4.17).<br />

Er ist hier mit einem Fuzzy System implementiert, das Bewertungen des aktuellen Umgebungszustands<br />

in Bezug auf eine Kollisionsgefahr erstellt, und wird nach der Trainingsphase vom System<br />

abgekoppelt. Als Eingabe erhält er den minimalen Abstand dHKmin des Hindernisses von der Kamera<br />

und den minimalen Abstand des Hindernisses dHSAmin von der Kamerasichtachse (Abbildung 4.18).<br />

Jedem Eingang des Bewerters wird eine linguistische Variable mit drei Termen zugeordnet. Die Zugehörigkeitsfunktionen<br />

sowie die Regelbasis des Bewerters wurden nicht trainiert, sondern sind vorgegeben;<br />

sie sind in Anhang D dargestellt. Die Regelbasis ist auf Basis zweier empirischer Aussagen<br />

erstellt worden. Einerseits erhöht eine Annäherung des Greifers an das Hindernis die Kollisionsgefahr;<br />

in diesem Fall sollte das Verhalten eine negative Bewertung erhalten. Andererseits gibt es mehr<br />

Raum für eine Vorwärtsbewegung, je größer der Abstand des Hindernisses von der Sichtachse wird;<br />

deshalb sollte für solche Konstellationen eine positive Bewertung erteilt werden. Somit bestraft der<br />

Bewerter Bewegungen, die dem Manipulator in Kollisionsgefahr mit dem Hindernis bringen, belohnt<br />

jedoch Bewegungen, die den Greifer möglichst schnell voran führen.<br />

Das eigentliche Training setzt den Q-learning Algorithmus [Wat89] ein, der von einem gegebenen<br />

Zustand Zi nach der Aktion �ρ sucht, die die akkumulierte zukünftige Belohnung und somit die Ak-<br />

19 Die Dimensionen des Hindernisses variieren pro Lernszenario.<br />

T<br />

ρ HG<br />

ρ 1<br />

H 2