Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

3.3 Teach-In in virtuellen Umgebungen 65<br />

Die Handlungsstrategie entspricht der steuernden Komponente des Agenten. Sie bestimmt, welche<br />

Aktion der Agent in welcher Situation wählen soll und realisiert eine Abbildung von dem Zustandsraum<br />

9 Z der Umgebung in den Aktionsraum 10 A zu: Z ↦→ A.<br />

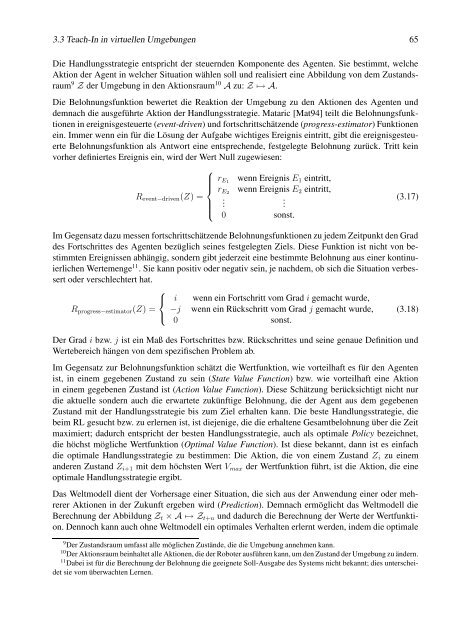

Die Belohnungsfunktion bewertet die Reaktion der Umgebung zu den Aktionen des Agenten und<br />

demnach die ausgeführte Aktion der Handlungsstrategie. Mataric [Mat94] teilt die Belohnungsfunktionen<br />

in ereignisgesteuerte (event-driven) und fortschrittschätzende (progress-estimator) Funktionen<br />

ein. Immer wenn ein für die Lösung der Aufgabe wichtiges Ereignis eintritt, gibt die ereignisgesteuerte<br />

Belohnungsfunktion als Antwort eine entsprechende, festgelegte Belohnung zurück. Tritt kein<br />

vorher definiertes Ereignis ein, wird der Wert Null zugewiesen:<br />

Revent−driven(Z) =<br />

⎧<br />

⎪⎨<br />

⎪⎩<br />

rE1 wenn Ereignis E1 eintritt,<br />

rE2 wenn Ereignis E2 eintritt,<br />

.<br />

.<br />

0 sonst.<br />

(3.17)<br />

Im Gegensatz dazu messen fortschrittschätzende Belohnungsfunktionen zu jedem Zeitpunkt den Grad<br />

des Fortschrittes des Agenten bezüglich seines festgelegten Ziels. Diese Funktion ist nicht von bestimmten<br />

Ereignissen abhängig, sondern gibt jederzeit eine bestimmte Belohnung aus einer kontinuierlichen<br />

Wertemenge 11 . Sie kann positiv oder negativ sein, je nachdem, ob sich die Situation verbes-<br />

sert oder verschlechtert hat.<br />

Rprogress−estimator(Z) =<br />

⎧<br />

⎨<br />

⎩<br />

i wenn ein Fortschritt vom Grad i gemacht wurde,<br />

−j wenn ein Rückschritt vom Grad j gemacht wurde,<br />

0 sonst.<br />

(3.18)<br />

Der Grad i bzw. j ist ein Maß des Fortschrittes bzw. Rückschrittes und seine genaue Definition und<br />

Wertebereich hängen von dem spezifischen Problem ab.<br />

Im Gegensatz zur Belohnungsfunktion schätzt die Wertfunktion, wie vorteilhaft es für den Agenten<br />

ist, in einem gegebenen Zustand zu sein (State Value Function) bzw. wie vorteilhaft eine Aktion<br />

in einem gegebenen Zustand ist (Action Value Function). Diese Schätzung berücksichtigt nicht nur<br />

die aktuelle sondern auch die erwartete zukünftige Belohnung, die der Agent aus dem gegebenen<br />

Zustand mit der Handlungsstrategie bis zum Ziel erhalten kann. Die beste Handlungsstrategie, die<br />

beim RL gesucht bzw. zu erlernen ist, ist diejenige, die die erhaltene Gesamtbelohnung über die Zeit<br />

maximiert; dadurch entspricht der besten Handlungsstrategie, auch als optimale Policy bezeichnet,<br />

die höchst mögliche Wertfunktion (Optimal Value Function). Ist diese bekannt, dann ist es einfach<br />

die optimale Handlungsstrategie zu bestimmen: Die Aktion, die von einem Zustand Zi zu einem<br />

anderen Zustand Zi+1 mit dem höchsten Wert Vmax der Wertfunktion führt, ist die Aktion, die eine<br />

optimale Handlungsstrategie ergibt.<br />

Das Weltmodell dient der Vorhersage einer Situation, die sich aus der Anwendung einer oder mehrerer<br />

Aktionen in der Zukunft ergeben wird (Prediction). Demnach ermöglicht das Weltmodell die<br />

Berechnung der Abbildung Zt × A ↦→ Zt+n und dadurch die Berechnung der Werte der Wertfunktion.<br />

Dennoch kann auch ohne Weltmodell ein optimales Verhalten erlernt werden, indem die optimale<br />

9 Der Zustandsraum umfasst alle möglichen Zustände, die die Umgebung annehmen kann.<br />

10 Der Aktionsraum beinhaltet alle Aktionen, die der Roboter ausführen kann, um den Zustand der Umgebung zu ändern.<br />

11 Dabei ist für die Berechnung der Belohnung die geeignete Soll-Ausgabe des Systems nicht bekannt; dies unterschei-<br />

det sie vom überwachten Lernen.