Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

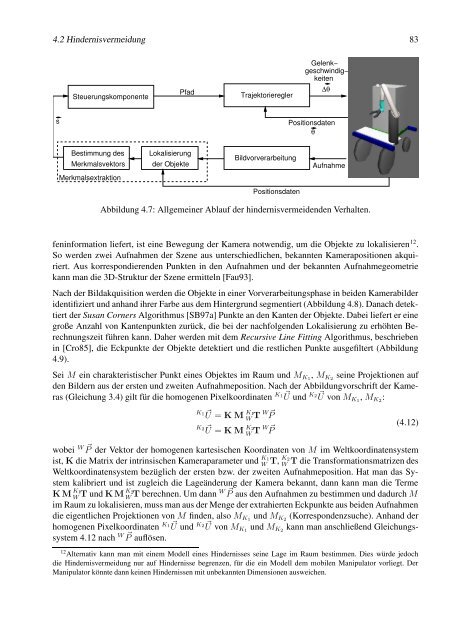

4.2 Hindernisvermeidung 83<br />

Steuerungskomponente<br />

Pfad<br />

Trajektorieregler<br />

Gelenk−<br />

geschwindig−<br />

keiten<br />

s Positionsdaten<br />

θ<br />

Bestimmung des<br />

Merkmalsvektors<br />

Merkmalsextraktion<br />

Lokalisierung<br />

der Objekte<br />

Bildvorverarbeitung<br />

Positionsdaten<br />

∆θ<br />

Aufnahme<br />

Abbildung 4.7: Allgemeiner Ablauf der hindernisvermeidenden Verhalten.<br />

feninformation liefert, ist eine Bewegung der Kamera notwendig, um die Objekte zu lokalisieren 12 .<br />

So werden zwei Aufnahmen der Szene aus unterschiedlichen, bekannten Kamerapositionen akquiriert.<br />

Aus korrespondierenden Punkten in den Aufnahmen und der bekannten Aufnahmegeometrie<br />

kann man die 3D-Struktur der Szene ermitteln [Fau93].<br />

Nach der Bildakquisition werden die Objekte in einer Vorverarbeitungsphase in beiden Kamerabilder<br />

identifiziert und anhand ihrer Farbe aus dem Hintergrund segmentiert (Abbildung 4.8). Danach detektiert<br />

der Susan Corners Algorithmus [SB97a] Punkte an den Kanten der Objekte. Dabei liefert er eine<br />

große Anzahl von Kantenpunkten zurück, die bei der nachfolgenden Lokalisierung zu erhöhten Berechnungszeit<br />

führen kann. Daher werden mit dem Recursive Line Fitting Algorithmus, beschrieben<br />

in [Cro85], die Eckpunkte der Objekte detektiert und die restlichen Punkte ausgefiltert (Abbildung<br />

4.9).<br />

Sei M ein charakteristischer Punkt eines Objektes im Raum und MK1, MK2 seine Projektionen auf<br />

den Bildern aus der ersten und zweiten Aufnahmeposition. Nach der Abbildungvorschrift der Kameras<br />

(Gleichung 3.4) gilt für die homogenen Pixelkoordinaten K1 � U und K2 � U von MK1, MK2:<br />

K1 � U = K M K1<br />

W T W� P<br />

K2 � U = K M K2<br />

W T W� P<br />

(4.12)<br />

wobei W P� der Vektor der homogenen kartesischen Koordinaten von M im Weltkoordinatensystem<br />

ist, K die Matrix der intrinsischen Kameraparameter und K1 K2<br />

W T, W T die Transformationsmatrizen des<br />

Weltkoordinatensystem bezüglich der ersten bzw. der zweiten Aufnahmeposition. Hat man das System<br />

kalibriert und ist zugleich die Lageänderung der Kamera bekannt, dann kann man die Terme<br />

K M K1<br />

K2<br />

W T und K M W T berechnen. Um dann W P� aus den Aufnahmen zu bestimmen und dadurch M<br />

im Raum zu lokalisieren, muss man aus der Menge der extrahierten Eckpunkte aus beiden Aufnahmen<br />

die eigentlichen Projektionen von M finden, also MK1 und MK2 (Korrespondenzsuche). Anhand der<br />

homogenen Pixelkoordinaten K1U� K2 und U� von MK1 und MK2 kann man anschließend Gleichungssystem<br />

4.12 nach W P� auflösen.<br />

12 Alternativ kann man mit einem Modell eines Hindernisses seine Lage im Raum bestimmen. Dies würde jedoch<br />

die Hindernisvermeidung nur auf Hindernisse begrenzen, für die ein Modell dem mobilen Manipulator vorliegt. Der<br />

Manipulator könnte dann keinen Hindernissen mit unbekannten Dimensionen ausweichen.