Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

120 5.4 Erlernen der Verhaltenskoordination<br />

Im Allgemeinen ist die optimale Gewichtung der Verhalten in jeder Situation nicht vorab bekannt,<br />

so dass ein überwachtes Lernverfahren nicht einsetzbar ist. Man kann jedoch das Ergebnis der Anwendung<br />

eines Verhaltens in einer Situation, ob sich also der Zustand des Aktuators in Hinblick auf<br />

das Aufgabenziel verbessert oder verschlechtert hat, leicht bewerten. Deswegen gehört nach Mataric<br />

[Mat94] das Erlernen der Verhaltenskoordinierung zur Kategorie des Lernens mit Bewerter (Reinforcement<br />

Learning, RL) (siehe auch Abschnitt 3.3.2). Beim RL wird nach der Ausführung eines<br />

Verhaltens eine Belohnung für einen Erfolg vergeben und damit die Handlungsstrategie so geändert,<br />

dass in einer vergleichbaren Situation ähnlich verfahren wird. Erhält der Roboter jedoch im Fall eines<br />

Misserfolges eine Bestrafung, wird der Entscheidungsalgorithmus derart angepasst, dass das Verhalten<br />

in ähnlichen Situationen nicht mehr aktiviert wird. In diesem Rahmen beschreiben die BBNs die<br />

zu erlernende Handlungsstrategie, welche eine Abbildung aus dem Zustandsraum, also dem Raum der<br />

Merkmale S ′ , in den Aktionsraum, d.h. die Aufstellung der Gewichtungsmatrix G, darstellt. Dafür<br />

werden die cpts der Knoten anhand der vergebenen Belohnung angepasst.<br />

Die Belohnungsfunktion bewertet, ob das jeweilige Verhalten innerhalb des Betrachtungszeitraums<br />

erfolgreich war. Sie ist verhaltensspezifisch und kann entweder eine Event-driven 9 oder eine Progressestimator<br />

Funktion 10 sein. Ihr Wert hängt von der Situation ab, die sich nach der Ausführung eines<br />

Verhaltens ergibt.<br />

Das Credit Assignment Problem wird gelöst, indem bei jedem Lernvorgang immer nur die Anwendbarkeit<br />

eines einzelnen Verhaltens erlernt wird. Dies bedeutet, dass man bei jedem Lernschritt nur<br />

das BBN, das die zu erlernende Anwendbarkeit des betreffenden Verhaltens modelliert, angepasst.<br />

Andere Verhalten können gleichzeitig aktiv sein, sie dürfen jedoch nicht eine ähnliche Zielsetzung<br />

wie das zu erlernende Verhalten haben. Damit kann eine verhaltensspezifische Belohnung vergeben<br />

werden, die nur den Erfolg des Verhaltens, dessen Anwendbarkeit erlernt wird, bewertet.<br />

Als Beispiel wird hier der Trainingsvorgang bei der Hindernisvermeidung des Greifers in der virtuellen<br />

Umgebung vorgestellt. Dabei sind alle zum Greifen notwendigen Verhalten, also das Planungsverhalten,<br />

die Zielführung, das Zielfolgen und die Hindernisvermeidung des Greifers aktiv. Die<br />

Trainingsdaten, also die Merkmals- und Positionsvektoren sowie die Bewertung des zu trainierenden<br />

Verhaltens, werden mit dem stochastischen Teach-In in der virtuellen Umgebung generiert und<br />

akquiriert (s.a. Abschnitt 3.3.4).<br />

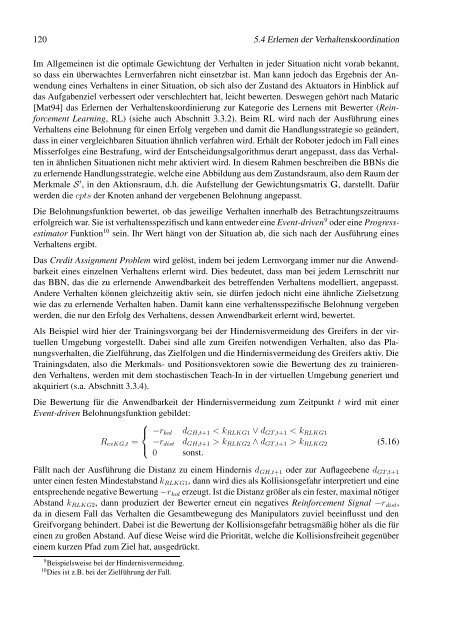

Die Bewertung für die Anwendbarkeit der Hindernisvermeidung zum Zeitpunkt t wird mit einer<br />

Event-driven Belohnungsfunktion gebildet:<br />

⎧<br />

⎨ −rkol dGH,t+1 < kRLKG1 ∨ dGT,t+1 < kRLKG1<br />

RevKG,t = −rdist<br />

⎩<br />

0<br />

dGH,t+1 > kRLKG2 ∧ dGT,t+1 > kRLKG2<br />

sonst.<br />

(5.16)<br />

Fällt nach der Ausführung die Distanz zu einem Hindernis dGH,t+1 oder zur Auflageebene dGT,t+1<br />

unter einen festen Mindestabstand kRLKG1, dann wird dies als Kollisionsgefahr interpretiert und eine<br />

entsprechende negative Bewertung −rkol erzeugt. Ist die Distanz größer als ein fester, maximal nötiger<br />

Abstand kRLKG2, dann produziert der Bewerter erneut ein negatives Reinforcement Signal −rdist,<br />

da in diesem Fall das Verhalten die Gesamtbewegung des Manipulators zuviel beeinflusst und den<br />

Greifvorgang behindert. Dabei ist die Bewertung der Kollisionsgefahr betragsmäßig höher als die für<br />

einen zu großen Abstand. Auf diese Weise wird die Priorität, welche die Kollisionsfreiheit gegenüber<br />

einem kurzen Pfad zum Ziel hat, ausgedrückt.<br />

9 Beispielsweise bei der Hindernisvermeidung.<br />

10 Dies ist z.B. bei der Zielführung der Fall.