Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

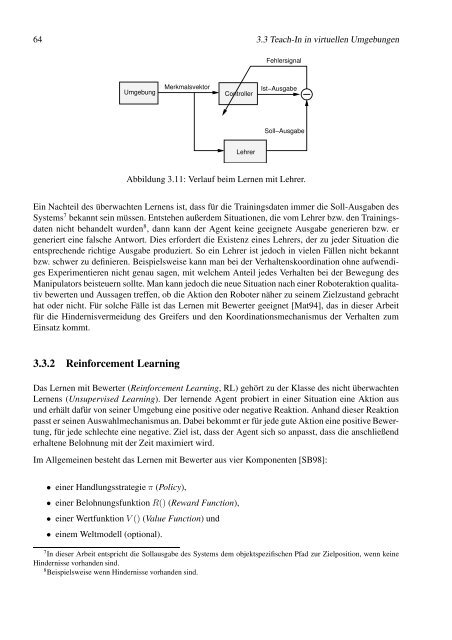

64 3.3 Teach-In in virtuellen Umgebungen<br />

Umgebung<br />

Merkmalsvektor<br />

Controller<br />

Lehrer<br />

Fehlersignal<br />

Ist−Ausgabe<br />

Soll−Ausgabe<br />

Abbildung 3.11: Verlauf beim Lernen mit Lehrer.<br />

Ein Nachteil des überwachten Lernens ist, dass für die Trainingsdaten immer die Soll-Ausgaben des<br />

Systems 7 bekannt sein müssen. Entstehen außerdem Situationen, die vom Lehrer bzw. den Trainingsdaten<br />

nicht behandelt wurden 8 , dann kann der Agent keine geeignete Ausgabe generieren bzw. er<br />

generiert eine falsche Antwort. Dies erfordert die Existenz eines Lehrers, der zu jeder Situation die<br />

entsprechende richtige Ausgabe produziert. So ein Lehrer ist jedoch in vielen Fällen nicht bekannt<br />

bzw. schwer zu definieren. Beispielsweise kann man bei der Verhaltenskoordination ohne aufwendiges<br />

Experimentieren nicht genau sagen, mit welchem Anteil jedes Verhalten bei der Bewegung des<br />

Manipulators beisteuern sollte. Man kann jedoch die neue Situation nach einer Roboteraktion qualitativ<br />

bewerten und Aussagen treffen, ob die Aktion den Roboter näher zu seinem Zielzustand gebracht<br />

hat oder nicht. Für solche Fälle ist das Lernen mit Bewerter geeignet [Mat94], das in dieser Arbeit<br />

für die Hindernisvermeidung des Greifers und den Koordinationsmechanismus der Verhalten zum<br />

Einsatz kommt.<br />

3.3.2 Reinforcement Learning<br />

Das Lernen mit Bewerter (Reinforcement Learning, RL) gehört zu der Klasse des nicht überwachten<br />

Lernens (Unsupervised Learning). Der lernende Agent probiert in einer Situation eine Aktion aus<br />

und erhält dafür von seiner Umgebung eine positive oder negative Reaktion. Anhand dieser Reaktion<br />

passt er seinen Auswahlmechanismus an. Dabei bekommt er für jede gute Aktion eine positive Bewertung,<br />

für jede schlechte eine negative. Ziel ist, dass der Agent sich so anpasst, dass die anschließend<br />

erhaltene Belohnung mit der Zeit maximiert wird.<br />

Im Allgemeinen besteht das Lernen mit Bewerter aus vier Komponenten [SB98]:<br />

• einer Handlungsstrategie π (Policy),<br />

• einer Belohnungsfunktion R() (Reward Function),<br />

• einer Wertfunktion V () (Value Function) und<br />

• einem Weltmodell (optional).<br />

7In dieser Arbeit entspricht die Sollausgabe des Systems dem objektspezifischen Pfad zur Zielposition, wenn keine<br />

Hindernisse vorhanden sind.<br />

8Beispielsweise wenn Hindernisse vorhanden sind.