Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

76 4.1 Bildgestützte Zielführung<br />

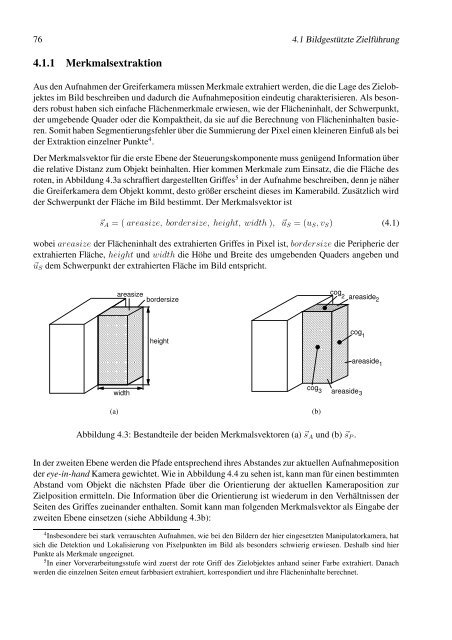

4.1.1 Merkmalsextraktion<br />

Aus den Aufnahmen der Greiferkamera müssen Merkmale extrahiert werden, die die Lage des Zielobjektes<br />

im Bild beschreiben und dadurch die Aufnahmeposition eindeutig charakterisieren. Als besonders<br />

robust haben sich einfache Flächenmerkmale erwiesen, wie der Flächeninhalt, der Schwerpunkt,<br />

der umgebende Quader oder die Kompaktheit, da sie auf die Berechnung von Flächeninhalten basieren.<br />

Somit haben Segmentierungsfehler über die Summierung der Pixel einen kleineren Einfuß als bei<br />

der Extraktion einzelner Punkte 4 .<br />

Der Merkmalsvektor für die erste Ebene der Steuerungskomponente muss genügend Information über<br />

die relative Distanz zum Objekt beinhalten. Hier kommen Merkmale zum Einsatz, die die Fläche des<br />

roten, in Abbildung 4.3a schraffiert dargestellten Griffes 5 in der Aufnahme beschreiben, denn je näher<br />

die Greiferkamera dem Objekt kommt, desto größer erscheint dieses im Kamerabild. Zusätzlich wird<br />

der Schwerpunkt der Fläche im Bild bestimmt. Der Merkmalsvektor ist<br />

�sA = ( areasize, bordersize, height, width ), �uS = (uS, vS) (4.1)<br />

wobei areasize der Flächeninhalt des extrahierten Griffes in Pixel ist, bordersize die Peripherie der<br />

extrahierten Fläche, height und width die Höhe und Breite des umgebenden Quaders angeben und<br />

�uS dem Schwerpunkt der extrahierten Fläche im Bild entspricht.<br />

areasize<br />

bordersize<br />

¥¤¥¤¥¤¥¤¥ £¤£¤£¤£¤£<br />

£¤£¤£¤£¤£ ¥¤¥¤¥¤¥¤¥<br />

¥¤¥¤¥¤¥¤¥ £¤£¤£¤£¤£<br />

£¤£¤£¤£¤£ ¥¤¥¤¥¤¥¤¥<br />

¥¤¥¤¥¤¥¤¥ £¤£¤£¤£¤£<br />

£¤£¤£¤£¤£ ¥¤¥¤¥¤¥¤¥<br />

¥¤¥¤¥¤¥¤¥ £¤£¤£¤£¤£<br />

£¤£¤£¤£¤£ ¥¤¥¤¥¤¥¤¥<br />

¥¤¥¤¥¤¥¤¥ £¤£¤£¤£¤£<br />

width<br />

(a)<br />

height<br />

�§� �§�§�§�§�§� �§�§�§�§�§� ©§©§©<br />

¦§¦§¦§¦ ¨§¨§¨§¨�§�<br />

©§©§©<br />

�§� ©§©§© ¨§¨§¨§¨ ¦§¦§¦§¦<br />

¦§¦§¦§¦ ¨§¨§¨§¨�§�<br />

©§©§©<br />

�§� ©§©§© ¨§¨§¨§¨ ¦§¦§¦§¦<br />

¦§¦§¦§¦ ¨§¨§¨§¨�§�<br />

©§©§©<br />

�§� ©§©§© ¨§¨§¨§¨ ¦§¦§¦§¦<br />

¦§¦§¦§¦ ¨§¨§¨§¨�§�<br />

©§©§©<br />

�§� ©§©§© ¨§¨§¨§¨ ¦§¦§¦§¦<br />

cog3<br />

cog<br />

2<br />

areaside2<br />

cog<br />

1<br />

areaside 3<br />

Abbildung 4.3: Bestandteile der beiden Merkmalsvektoren (a) �sA und (b) �sP .<br />

(b)<br />

areaside 1<br />

In der zweiten Ebene werden die Pfade entsprechend ihres Abstandes zur aktuellen Aufnahmeposition<br />

der eye-in-hand Kamera gewichtet. Wie in Abbildung 4.4 zu sehen ist, kann man für einen bestimmten<br />

Abstand vom Objekt die nächsten Pfade über die Orientierung der aktuellen Kameraposition zur<br />

Zielposition ermitteln. Die Information über die Orientierung ist wiederum in den Verhältnissen der<br />

Seiten des Griffes zueinander enthalten. Somit kann man folgenden Merkmalsvektor als Eingabe der<br />

zweiten Ebene einsetzen (siehe Abbildung 4.3b):<br />

4 Insbesondere bei stark verrauschten Aufnahmen, wie bei den Bildern der hier eingesetzten Manipulatorkamera, hat<br />

sich die Detektion und Lokalisierung von Pixelpunkten im Bild als besonders schwierig erwiesen. Deshalb sind hier<br />

Punkte als Merkmale ungeeignet.<br />

5 In einer Vorverarbeitungsstufe wird zuerst der rote Griff des Zielobjektes anhand seiner Farbe extrahiert. Danach<br />

werden die einzelnen Seiten erneut farbbasiert extrahiert, korrespondiert und ihre Flächeninhalte berechnet.