Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

32 2.3 Verfahren zur Koordination reaktiver Verhalten<br />

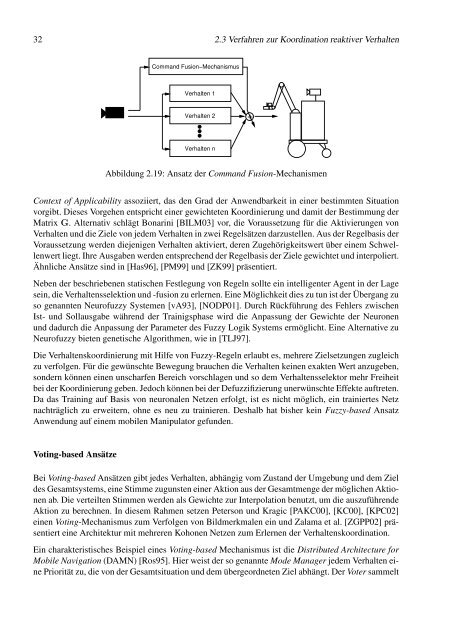

Command Fusion−Mechanismus<br />

Verhalten 1<br />

Verhalten 2<br />

Verhalten n<br />

Abbildung 2.19: Ansatz der Command Fusion-Mechanismen<br />

Context of Applicability assoziiert, das den Grad der Anwendbarkeit in einer bestimmten Situation<br />

vorgibt. Dieses Vorgehen entspricht einer gewichteten Koordinierung und damit der Bestimmung der<br />

Matrix G. Alternativ schlägt Bonarini [BILM03] vor, die Voraussetzung für die Aktivierungen von<br />

Verhalten und die Ziele von jedem Verhalten in zwei Regelsätzen darzustellen. Aus der Regelbasis der<br />

Voraussetzung werden diejenigen Verhalten aktiviert, deren Zugehörigkeitswert über einem Schwellenwert<br />

liegt. Ihre Ausgaben werden entsprechend der Regelbasis der Ziele gewichtet und interpoliert.<br />

Ähnliche Ansätze sind in [Has96], [PM99] und [ZK99] präsentiert.<br />

Neben der beschriebenen statischen Festlegung von Regeln sollte ein intelligenter Agent in der Lage<br />

sein, die Verhaltensselektion und -fusion zu erlernen. Eine Möglichkeit dies zu tun ist der Übergang zu<br />

so genannten Neurofuzzy Systemen [vA93], [NODP01]. Durch Rückführung des Fehlers zwischen<br />

Ist- und Sollausgabe während der Trainigsphase wird die Anpassung der Gewichte der Neuronen<br />

und dadurch die Anpassung der Parameter des Fuzzy Logik Systems ermöglicht. Eine Alternative zu<br />

Neurofuzzy bieten genetische Algorithmen, wie in [TLJ97].<br />

Die Verhaltenskoordinierung mit Hilfe von Fuzzy-Regeln erlaubt es, mehrere Zielsetzungen zugleich<br />

zu verfolgen. Für die gewünschte Bewegung brauchen die Verhalten keinen exakten Wert anzugeben,<br />

sondern können einen unscharfen Bereich vorschlagen und so dem Verhaltensselektor mehr Freiheit<br />

bei der Koordinierung geben. Jedoch können bei der Defuzzifizierung unerwünschte Effekte auftreten.<br />

Da das Training auf Basis von neuronalen Netzen erfolgt, ist es nicht möglich, ein trainiertes Netz<br />

nachträglich zu erweitern, ohne es neu zu trainieren. Deshalb hat bisher kein Fuzzy-based Ansatz<br />

Anwendung auf einem mobilen Manipulator gefunden.<br />

Voting-based Ansätze<br />

Bei Voting-based Ansätzen gibt jedes Verhalten, abhängig vom Zustand der Umgebung und dem Ziel<br />

des Gesamtsystems, eine Stimme zugunsten einer Aktion aus der Gesamtmenge der möglichen Aktionen<br />

ab. Die verteilten Stimmen werden als Gewichte zur Interpolation benutzt, um die auszuführende<br />

Aktion zu berechnen. In diesem Rahmen setzen Peterson und Kragic [PAKC00], [KC00], [KPC02]<br />

einen Voting-Mechanismus zum Verfolgen von Bildmerkmalen ein und Zalama et al. [ZGPP02] präsentiert<br />

eine Architektur mit mehreren Kohonen Netzen zum Erlernen der Verhaltenskoordination.<br />

Ein charakteristisches Beispiel eines Voting-based Mechanismus ist die Distributed Architecture for<br />

Mobile Navigation (DAMN) [Ros95]. Hier weist der so genannte Mode Manager jedem Verhalten eine<br />

Priorität zu, die von der Gesamtsituation und dem übergeordneten Ziel abhängt. Der Voter sammelt<br />

+