Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Thesis - RWTH Aachen University

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

4.1 Bildgestützte Zielführung 81<br />

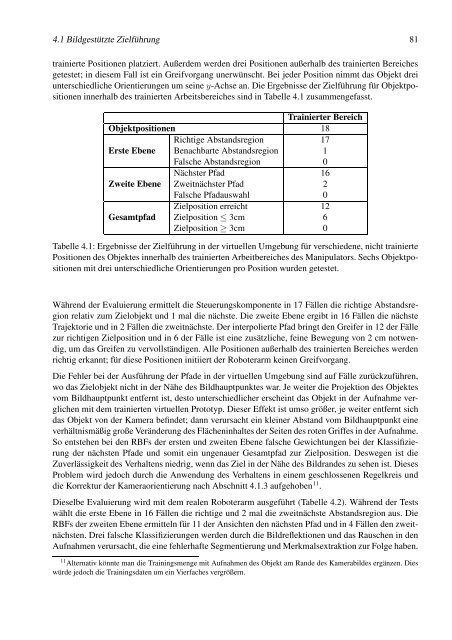

trainierte Positionen platziert. Außerdem werden drei Positionen außerhalb des trainierten Bereiches<br />

getestet; in diesem Fall ist ein Greifvorgang unerwünscht. Bei jeder Position nimmt das Objekt drei<br />

unterschiedliche Orientierungen um seine y-Achse an. Die Ergebnisse der Zielführung für Objektpositionen<br />

innerhalb des trainierten Arbeitsbereiches sind in Tabelle 4.1 zusammengefasst.<br />

Objektpositionen<br />

Trainierter Bereich<br />

18<br />

Richtige Abstandsregion 17<br />

Erste Ebene Benachbarte Abstandsregion 1<br />

Falsche Abstandsregion 0<br />

Nächster Pfad 16<br />

Zweite Ebene Zweitnächster Pfad 2<br />

Falsche Pfadauswahl 0<br />

Zielposition erreicht 12<br />

Gesamtpfad Zielposition ≤ 3cm 6<br />

Zielposition ≥ 3cm 0<br />

Tabelle 4.1: Ergebnisse der Zielführung in der virtuellen Umgebung für verschiedene, nicht trainierte<br />

Positionen des Objektes innerhalb des trainierten Arbeitbereiches des Manipulators. Sechs Objektpositionen<br />

mit drei unterschiedliche Orientierungen pro Position wurden getestet.<br />

Während der Evaluierung ermittelt die Steuerungskomponente in 17 Fällen die richtige Abstandsregion<br />

relativ zum Zielobjekt und 1 mal die nächste. Die zweite Ebene ergibt in 16 Fällen die nächste<br />

Trajektorie und in 2 Fällen die zweitnächste. Der interpolierte Pfad bringt den Greifer in 12 der Fälle<br />

zur richtigen Zielposition und in 6 der Fälle ist eine zusätzliche, feine Bewegung von 2 cm notwendig,<br />

um das Greifen zu vervollständigen. Alle Positionen außerhalb des trainierten Bereiches werden<br />

richtig erkannt; für diese Positionen initiiert der Roboterarm keinen Greifvorgang.<br />

Die Fehler bei der Ausführung der Pfade in der virtuellen Umgebung sind auf Fälle zurückzuführen,<br />

wo das Zielobjekt nicht in der Nähe des Bildhauptpunktes war. Je weiter die Projektion des Objektes<br />

vom Bildhauptpunkt entfernt ist, desto unterschiedlicher erscheint das Objekt in der Aufnahme verglichen<br />

mit dem trainierten virtuellen Prototyp. Dieser Effekt ist umso größer, je weiter entfernt sich<br />

das Objekt von der Kamera befindet; dann verursacht ein kleiner Abstand vom Bildhauptpunkt eine<br />

verhältnismäßig große Veränderung des Flächeninhaltes der Seiten des roten Griffes in der Aufnahme.<br />

So entstehen bei den RBFs der ersten und zweiten Ebene falsche Gewichtungen bei der Klassifizierung<br />

der nächsten Pfade und somit ein ungenauer Gesamtpfad zur Zielposition. Deswegen ist die<br />

Zuverlässigkeit des Verhaltens niedrig, wenn das Ziel in der Nähe des Bildrandes zu sehen ist. Dieses<br />

Problem wird jedoch durch die Anwendung des Verhaltens in einem geschlossenen Regelkreis und<br />

die Korrektur der Kameraorientierung nach Abschnitt 4.1.3 aufgehoben 11 .<br />

Dieselbe Evaluierung wird mit dem realen Roboterarm ausgeführt (Tabelle 4.2). Während der Tests<br />

wählt die erste Ebene in 16 Fällen die richtige und 2 mal die zweitnächste Abstandsregion aus. Die<br />

RBFs der zweiten Ebene ermitteln für 11 der Ansichten den nächsten Pfad und in 4 Fällen den zweitnächsten.<br />

Drei falsche Klassifizierungen werden durch die Bildreflektionen und das Rauschen in den<br />

Aufnahmen verursacht, die eine fehlerhafte Segmentierung und Merkmalsextraktion zur Folge haben.<br />

11 Alternativ könnte man die Trainingsmenge mit Aufnahmen des Objekt am Rande des Kamerabildes ergänzen. Dies<br />

würde jedoch die Trainingsdaten um ein Vierfaches vergrößern.