- Seite 1 und 2:

Projektgruppe Business Intelligence

- Seite 3 und 4:

Projektgruppe Cuberunner Einleitung

- Seite 5 und 6:

Projektgruppe Cuberunner Einleitung

- Seite 7 und 8:

Projektgruppe Cuberunner Einleitung

- Seite 9 und 10:

Projektgruppe Cuberunner Jinengo -

- Seite 11 und 12:

Projektgruppe Cuberunner Jinengo -

- Seite 13 und 14:

Projektgruppe Cuberunner Jinengo -

- Seite 15 und 16:

Projektgruppe Cuberunner Jinengo -

- Seite 17 und 18: Projektgruppe Cuberunner Jinengo -

- Seite 19 und 20: Projektgruppe Cuberunner Jinengo -

- Seite 21 und 22: Projektgruppe Cuberunner Jinengo -

- Seite 23 und 24: Projektgruppe Cuberunner Jinengo -

- Seite 25 und 26: Projektgruppe Cuberunner Jinengo -

- Seite 27 und 28: Projektgruppe Cuberunner Jinengo -

- Seite 29 und 30: Projektgruppe Cuberunner Jinengo -

- Seite 31 und 32: Projektgruppe Cuberunner Jinengo -

- Seite 33 und 34: Projektgruppe Cuberunner Jinengo -

- Seite 35 und 36: Projektgruppe Cuberunner Jinengo -

- Seite 37 und 38: Projektgruppe Cuberunner Jinengo -

- Seite 39 und 40: Projektgruppe Cuberunner Jinengo -

- Seite 41 und 42: Projektgruppe Cuberunner Jinengo -

- Seite 43 und 44: Projektgruppe Cuberunner Jinengo -

- Seite 45 und 46: Projektgruppe Cuberunner Jinengo -

- Seite 47 und 48: Projektgruppe Cuberunner Jinengo -

- Seite 49 und 50: Projektgruppe Cuberunner Jinengo -

- Seite 51 und 52: Projektgruppe Cuberunner Jinengo -

- Seite 53 und 54: Projektgruppe Cuberunner Jinengo -

- Seite 55 und 56: Projektgruppe Cuberunner Jinengo -

- Seite 57 und 58: Projektgruppe Cuberunner Jinengo -

- Seite 59 und 60: Projektgruppe Cuberunner Jinengo -

- Seite 61 und 62: Projektgruppe Cuberunner Jinengo -

- Seite 63 und 64: Projektgruppe Cuberunner Jinengo -

- Seite 65 und 66: Projektgruppe Cuberunner Jinengo -

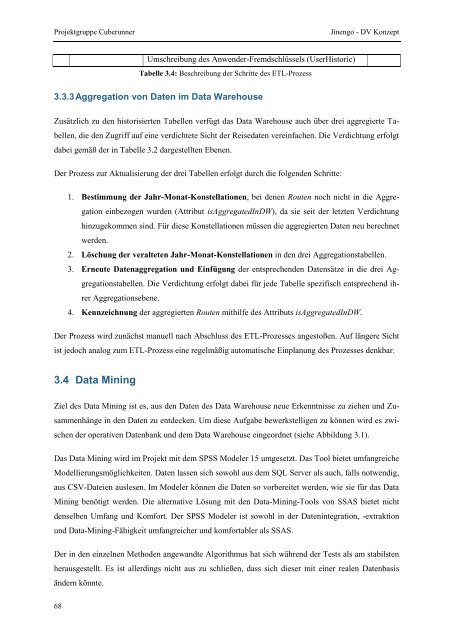

- Seite 67: Projektgruppe Cuberunner Jinengo -

- Seite 71 und 72: Projektgruppe Cuberunner Jinengo -

- Seite 73 und 74: Projektgruppe Cuberunner Jinengo -

- Seite 75 und 76: Projektgruppe Cuberunner Jinengo -

- Seite 77 und 78: Projektgruppe Cuberunner Jinengo -

- Seite 79 und 80: Projektgruppe Cuberunner Jinengo -

- Seite 81 und 82: Projektgruppe Cuberunner Jinengo -

- Seite 83 und 84: Projektgruppe Cuberunner Jinengo -

- Seite 85 und 86: Projektgruppe Cuberunner Jinengo -

- Seite 87 und 88: Projektgruppe Cuberunner Jinengo -

- Seite 89 und 90: Projektgruppe Cuberunner Jinengo -

- Seite 91 und 92: Projektgruppe Cuberunner Jinengo -

- Seite 93 und 94: Projektgruppe Cuberunner Jinengo -

- Seite 95 und 96: Projektgruppe Cuberunner Jinengo -

- Seite 97 und 98: Projektgruppe Cuberunner Jinengo -

- Seite 99 und 100: Projektgruppe Cuberunner Jinengo -

- Seite 101 und 102: Projektgruppe Cuberunner Jinengo -

- Seite 103 und 104: Projektgruppe Cuberunner Jinengo -

- Seite 105 und 106: Projektgruppe Cuberunner Jinengo -

- Seite 107 und 108: Projektgruppe Cuberunner Jinengo -

- Seite 109 und 110: Projektgruppe Cuberunner Jinengo -

- Seite 111 und 112: Projektgruppe Cuberunner Jinengo -

- Seite 113 und 114: Projektgruppe Cuberunner Jinengo -

- Seite 115 und 116: Projektgruppe Cuberunner Jinengo -

- Seite 117 und 118: Projektgruppe Cuberunner Jinengo -

- Seite 119 und 120:

Projektgruppe Cuberunner Jinengo -

- Seite 121 und 122:

Projektgruppe Cuberunner Jinengo -

- Seite 123 und 124:

Projektgruppe Cuberunner Jinengo -

- Seite 125 und 126:

Projektgruppe Cuberunner Jinengo -

- Seite 127 und 128:

Projektgruppe Cuberunner Jinengo -

- Seite 129 und 130:

Projektgruppe Cuberunner Jinengo -

- Seite 131 und 132:

Projektgruppe Cuberunner Jinengo -

- Seite 133 und 134:

Projektgruppe Cuberunner Jinengo -

- Seite 135 und 136:

Projektgruppe Cuberunner Jinengo -

- Seite 137 und 138:

Projektgruppe Cuberunner Jinengo -

- Seite 139 und 140:

Projektgruppe Cuberunner Jinengo -

- Seite 141 und 142:

Projektgruppe Cuberunner Jinengo -

- Seite 143 und 144:

Projektgruppe Cuberunner Jinengo -

- Seite 145 und 146:

Projektgruppe Cuberunner Jinengo -

- Seite 147 und 148:

Projektgruppe Cuberunner Jinengo -

- Seite 149 und 150:

Projektgruppe Cuberunner Jinengo -

- Seite 151 und 152:

Projektgruppe Cuberunner Jinengo -

- Seite 153 und 154:

Projektgruppe Cuberunner Jinengo -

- Seite 155 und 156:

Projektgruppe Cuberunner Jinengo -

- Seite 157 und 158:

Projektgruppe Cuberunner Jinengo -

- Seite 159 und 160:

Projektgruppe Cuberunner Jinengo -

- Seite 161 und 162:

Projektgruppe Cuberunner Jinengo -

- Seite 163 und 164:

Projektgruppe Cuberunner Jinengo -

- Seite 165 und 166:

Projektgruppe Cuberunner Jinengo -

- Seite 167 und 168:

Projektgruppe Cuberunner Jinengo -

- Seite 169 und 170:

Projektgruppe Cuberunner Jinengo -

- Seite 171 und 172:

Projektgruppe Cuberunner Jinengo -

- Seite 173 und 174:

Projektgruppe Cuberunner Jinengo -

- Seite 175 und 176:

Projektgruppe Cuberunner Jinengo -

- Seite 177 und 178:

Projektgruppe Cuberunner Jinengo -

- Seite 179 und 180:

Projektgruppe Cuberunner Jinengo -

- Seite 181 und 182:

Projektgruppe Cuberunner Jinengo -

- Seite 183 und 184:

Projektgruppe Cuberunner Jinengo -

- Seite 185 und 186:

Projektgruppe Cuberunner Jinengo -

- Seite 187 und 188:

Projektbericht Cuberunner CEWE „g

- Seite 189 und 190:

Projektbericht Cuberunner CEWE „g

- Seite 191 und 192:

Projektbericht Cuberunner CEWE „g

- Seite 193 und 194:

Projektbericht Cuberunner CEWE „g

- Seite 195 und 196:

Projektbericht Cuberunner CEWE „g

- Seite 197 und 198:

Projektbericht Cuberunner CEWE „g

- Seite 199 und 200:

Projektbericht Cuberunner CEWE „g

- Seite 201 und 202:

Projektbericht Cuberunner CEWE „g

- Seite 203 und 204:

Projektbericht Cuberunner CEWE „g

- Seite 205 und 206:

Projektbericht Cuberunner CEWE „g

- Seite 207 und 208:

Projektbericht Cuberunner CEWE „g

- Seite 209 und 210:

Projektbericht Cuberunner CEWE „g

- Seite 211 und 212:

Projektbericht Cuberunner CEWE „g

- Seite 213 und 214:

Projektbericht Cuberunner CEWE „g

- Seite 215 und 216:

Projektbericht Cuberunner CEWE „g

- Seite 217 und 218:

Projektbericht Cuberunner CEWE „g

- Seite 219 und 220:

Projektbericht Cuberunner CEWE „g

- Seite 221 und 222:

Projektbericht Cuberunner CEWE „g

- Seite 223 und 224:

Projektbericht Cuberunner CEWE „g

- Seite 225 und 226:

Projektbericht Cuberunner CEWE „g

- Seite 227 und 228:

Projektbericht Cuberunner CEWE „g

- Seite 229 und 230:

Projektbericht Cuberunner CEWE „g

- Seite 231 und 232:

Projektbericht Cuberunner CEWE „g

- Seite 233 und 234:

Projektbericht Cuberunner CEWE „g

- Seite 235 und 236:

Projektbericht Cuberunner CEWE „g

- Seite 237 und 238:

Projektbericht Cuberunner CEWE „g

- Seite 239 und 240:

Projektbericht Cuberunner CEWE „g

- Seite 241 und 242:

Projektbericht Cuberunner CEWE „g

- Seite 243 und 244:

Projektbericht Cuberunner CEWE „g

- Seite 245 und 246:

Projektbericht Cuberunner CEWE „g

- Seite 247 und 248:

Projektbericht Cuberunner CEWE „g

- Seite 249 und 250:

Projektbericht Cuberunner CEWE „g

- Seite 251 und 252:

Projektbericht Cuberunner CEWE „g

- Seite 253 und 254:

Projektbericht Cuberunner CEWE „g

- Seite 255 und 256:

Projektbericht Cuberunner CEWE „g

- Seite 257 und 258:

Projektbericht Cuberunner CEWE „g

- Seite 259 und 260:

Projektbericht Cuberunner CEWE „g

- Seite 261 und 262:

Projektbericht Cuberunner CEWE „g

- Seite 263 und 264:

Projektbericht Cuberunner CEWE „g

- Seite 265 und 266:

Projektbericht Cuberunner CEWE „g

- Seite 267 und 268:

Projektbericht Cuberunner CEWE „g

- Seite 269 und 270:

Projektbericht Cuberunner CEWE „g

- Seite 271 und 272:

Projektbericht Cuberunner CEWE „g

- Seite 273 und 274:

Projektbericht Cuberunner CEWE „g

- Seite 275 und 276:

Projektbericht Cuberunner CEWE „g

- Seite 277 und 278:

Projektbericht Cuberunner CEWE „g

- Seite 279 und 280:

Projektbericht Cuberunner CEWE „g

- Seite 281 und 282:

Projektbericht Cuberunner CEWE „g

- Seite 283 und 284:

Projektbericht Cuberunner CEWE „g

- Seite 285 und 286:

Projektbericht Cuberunner CEWE „g

- Seite 287 und 288:

Projektbericht Cuberunner CEWE „g

- Seite 289 und 290:

Projektbericht Cuberunner CEWE „g

- Seite 291 und 292:

Projektbericht Cuberunner CEWE „g

- Seite 293 und 294:

Projektbericht Cuberunner CEWE „g

- Seite 295 und 296:

Projektbericht Cuberunner CEWE „g

- Seite 297 und 298:

Projektbericht Cuberunner CEWE „g

- Seite 299 und 300:

Projektbericht Cuberunner CEWE „g

- Seite 301 und 302:

Projektbericht Cuberunner CEWE „g

- Seite 303 und 304:

Projektbericht Cuberunner CEWE „g

- Seite 305 und 306:

Projektbericht Cuberunner CEWE „g

- Seite 307 und 308:

Projektbericht Cuberunner CEWE „g

- Seite 309 und 310:

Projektbericht Cuberunner CEWE „g

- Seite 311 und 312:

Projektbericht Cuberunner CEWE „g

- Seite 313 und 314:

Projektbericht Cuberunner CEWE „g

- Seite 315 und 316:

Projektbericht Cuberunner CEWE „g

- Seite 317 und 318:

Projektbericht Cuberunner CEWE „g

- Seite 319 und 320:

Projektbericht Cuberunner CEWE „g

- Seite 321 und 322:

Projektbericht Cuberunner CEWE „g

- Seite 323 und 324:

Projektbericht Cuberunner CEWE „g

- Seite 325 und 326:

Projektbericht Cuberunner CEWE „g

- Seite 327 und 328:

Projektbericht Cuberunner CEWE „g

- Seite 329 und 330:

Projektbericht Cuberunner CEWE „g

- Seite 331 und 332:

Projektbericht Cuberunner CEWE „g

- Seite 333 und 334:

Projektbericht Cuberunner CEWE „g

- Seite 335 und 336:

Projektbericht Cuberunner CEWE „g

- Seite 337 und 338:

Projektbericht Cuberunner CEWE „g

- Seite 339 und 340:

Projektbericht Cuberunner CEWE „g

- Seite 341 und 342:

Projektbericht Cuberunner CEWE „g

- Seite 343 und 344:

Projektbericht Cuberunner CEWE „g

- Seite 345 und 346:

Projektbericht Cuberunner CEWE „g

- Seite 347 und 348:

Projektbericht Cuberunner CEWE „g

- Seite 349 und 350:

Projektbericht Cuberunner CEWE „g

- Seite 351 und 352:

Projektbericht Cuberunner CEWE „g

- Seite 353 und 354:

Projektbericht Cuberunner CEWE „g

- Seite 355 und 356:

Projektbericht Cuberunner CEWE „g

- Seite 357 und 358:

Projektbericht Cuberunner CEWE „g

- Seite 359 und 360:

Projektbericht Cuberunner CEWE „g

- Seite 361 und 362:

Projektbericht Cuberunner CEWE „g

- Seite 363 und 364:

Projektbericht Cuberunner CEWE „g

- Seite 366 und 367:

Projektbericht Cuberunner CEWE „g

- Seite 368 und 369:

Projektbericht Cuberunner CEWE „g

- Seite 370 und 371:

Projektbericht Cuberunner CEWE „g

- Seite 372 und 373:

Projektbericht Cuberunner Smart Win

- Seite 374 und 375:

Projektbericht Cuberunner Smart Win

- Seite 376 und 377:

Projektbericht Cuberunner Smart Win

- Seite 378 und 379:

Projektbericht Cuberunner Smart Win

- Seite 380 und 381:

Projektbericht Cuberunner Smart Win

- Seite 382 und 383:

Projektbericht Cuberunner Smart Win

- Seite 384 und 385:

Projektbericht Cuberunner Smart Win

- Seite 386 und 387:

Projektbericht Cuberunner Smart Win

- Seite 388 und 389:

Projektbericht Cuberunner Smart Win

- Seite 390 und 391:

Projektbericht Cuberunner Smart Win

- Seite 392 und 393:

Projektbericht Cuberunner Smart Win

- Seite 394 und 395:

Projektbericht Cuberunner Smart Win

- Seite 396 und 397:

Projektbericht Cuberunner Smart Win

- Seite 398 und 399:

Projektbericht Cuberunner Smart Win

- Seite 400 und 401:

Projektbericht Cuberunner Smart Win

- Seite 402 und 403:

Projektbericht Cuberunner Smart Win

- Seite 404 und 405:

Projektbericht Cuberunner Smart Win

- Seite 406 und 407:

Projektbericht Cuberunner Smart Win

- Seite 408 und 409:

Projektbericht Cuberunner Smart Win

- Seite 410 und 411:

Projektbericht Cuberunner Smart Win

- Seite 412 und 413:

Projektbericht Cuberunner Smart Win

- Seite 414 und 415:

Projektbericht Cuberunner Smart Win

- Seite 416 und 417:

Projektbericht Cuberunner Smart Win

- Seite 418 und 419:

Projektbericht Cuberunner Smart Win

- Seite 420 und 421:

Projektbericht Cuberunner Smart Win

- Seite 422 und 423:

Projektbericht Cuberunner Smart Win

- Seite 424 und 425:

Projektbericht Cuberunner Smart Win

- Seite 426 und 427:

Projektbericht Cuberunner Smart Win

- Seite 428 und 429:

Projektbericht Cuberunner Smart Win

- Seite 430 und 431:

Projektbericht Cuberunner Smart Win

- Seite 432 und 433:

Projektbericht Cuberunner Smart Win

- Seite 434 und 435:

Projektbericht Cuberunner Smart Win

- Seite 436 und 437:

Projektbericht Cuberunner Smart Win

- Seite 438 und 439:

Projektbericht Cuberunner Smart Win

- Seite 440 und 441:

Projektbericht Cuberunner Smart Win

- Seite 442 und 443:

Projektbericht Cuberunner Smart Win

- Seite 444 und 445:

Projektbericht Cuberunner Smart Win

- Seite 446 und 447:

Projektbericht Cuberunner Smart Win

- Seite 448 und 449:

Projektbericht Cuberunner Smart Win

- Seite 450 und 451:

Projektbericht Cuberunner Smart Win

- Seite 452 und 453:

Projektbericht Cuberunner Smart Win

- Seite 454 und 455:

Projektbericht Cuberunner Smart Win

- Seite 456 und 457:

Projektbericht Cuberunner Smart Win

- Seite 458 und 459:

Projektbericht Cuberunner Smart Win

- Seite 460 und 461:

Projektbericht Cuberunner Smart Win

- Seite 462 und 463:

Projektbericht Cuberunner Smart Win

- Seite 464 und 465:

Projektbericht Cuberunner Smart Win

- Seite 466 und 467:

Projektbericht Cuberunner Smart Win

- Seite 468 und 469:

Projektbericht Cuberunner Smart Win

- Seite 470 und 471:

Projektbericht Cuberunner Smart Win

- Seite 472 und 473:

Projektbericht Cuberunner Smart Win

- Seite 474 und 475:

Projektbericht Cuberunner Smart Win

- Seite 476 und 477:

Projektbericht Cuberunner Smart Win

- Seite 478 und 479:

Projektbericht Cuberunner Smart Win

- Seite 480 und 481:

Projektbericht Cuberunner Smart Win

- Seite 482 und 483:

Projektbericht Cuberunner Smart Win

- Seite 484 und 485:

Projektbericht Cuberunner Smart Win

- Seite 486 und 487:

Projektbericht Cuberunner Smart Win

- Seite 488 und 489:

Projektbericht Cuberunner Smart Win

- Seite 490 und 491:

Projektbericht Cuberunner Smart Win

- Seite 492 und 493:

Projektbericht Cuberunner Smart Win

- Seite 494 und 495:

Projektbericht Cuberunner Smart Win

- Seite 496 und 497:

Projektbericht Cuberunner Smart Win

- Seite 498 und 499:

Projektbericht Cuberunner Smart Win

- Seite 500 und 501:

Projektbericht Cuberunner Smart Win

- Seite 502 und 503:

Projektbericht Cuberunner Smart Win

- Seite 504 und 505:

Projektbericht Cuberunner Smart Win

- Seite 506 und 507:

Projektbericht Cuberunner Smart Win

- Seite 508 und 509:

Projektbericht Cuberunner Smart Win

- Seite 510 und 511:

Projektbericht Cuberunner Smart Win

- Seite 512 und 513:

Projektbericht Cuberunner Smart Win

- Seite 514 und 515:

Projektbericht Cuberunner Smart Win

- Seite 516 und 517:

Projektbericht Cuberunner Smart Win

- Seite 518 und 519:

Projektbericht Cuberunner Smart Win

- Seite 520 und 521:

Projektbericht Cuberunner Smart Win

- Seite 522 und 523:

Projektbericht Cuberunner Smart Win

- Seite 524 und 525:

Projektbericht Cuberunner Smart Win

- Seite 526 und 527:

Projektbericht Cuberunner Smart Win

- Seite 528 und 529:

Projektbericht Cuberunner Smart Win

- Seite 530 und 531:

Projektbericht Cuberunner Smart Win

- Seite 532 und 533:

Projektbericht Cuberunner Smart Win

- Seite 534 und 535:

Projektbericht Cuberunner Smart Win

- Seite 536 und 537:

Projektbericht Cuberunner Smart Win

- Seite 538 und 539:

Projektbericht Cuberunner Smart Win

- Seite 540 und 541:

Projektbericht Cuberunner Smart Win

- Seite 542 und 543:

Projektbericht Cuberunner Smart Win

- Seite 544 und 545:

Projektbericht Cuberunner Smart Win

- Seite 546 und 547:

Projektbericht Cuberunner Smart Win

- Seite 548 und 549:

Projektbericht Cuberunner Smart Win

- Seite 550 und 551:

Projektbericht Cuberunner Smart Win

- Seite 552 und 553:

Projektbericht Cuberunner Smart Win

- Seite 554 und 555:

Projektbericht Cuberunner Smart Win

- Seite 556 und 557:

Projektbericht Cuberunner Smart Win

- Seite 558 und 559:

Projektbericht Cuberunner Smart Win

- Seite 560 und 561:

Projektbericht Cuberunner Smart Win

- Seite 562 und 563:

Projektbericht Cuberunner Smart Win

- Seite 564 und 565:

Projektbericht Cuberunner Smart Win

- Seite 566 und 567:

Projektbericht Cuberunner Smart Win

- Seite 568 und 569:

Projektbericht Cuberunner Smart Win

- Seite 570 und 571:

Projektbericht Cuberunner Smart Win

- Seite 572 und 573:

Projektbericht Cuberunner Smart Win

- Seite 574 und 575:

Projektbericht Cuberunner Smart Win

- Seite 576 und 577:

Projektbericht Cuberunner Smart Win

- Seite 578 und 579:

Projektbericht Cuberunner Smart Win

- Seite 580 und 581:

Projektbericht Cuberunner Smart Win

- Seite 582 und 583:

Projektbericht Cuberunner Smart Win

- Seite 584 und 585:

Projektbericht Cuberunner Smart Win

- Seite 586 und 587:

Projektbericht Cuberunner Smart Win

- Seite 588 und 589:

Projektbericht Cuberunner Smart Win

- Seite 590 und 591:

Projektbericht Cuberunner Smart Win

- Seite 592 und 593:

Projektbericht Cuberunner Smart Win

- Seite 594 und 595:

Projektbericht Cuberunner Smart Win

- Seite 596 und 597:

Projektbericht Cuberunner Smart Win

- Seite 598 und 599:

Projektbericht Cuberunner Smart Win

- Seite 600 und 601:

Projektbericht Cuberunner Smart Win

- Seite 602 und 603:

Projektbericht Cuberunner Smart Win

- Seite 604 und 605:

Projektbericht Cuberunner Smart Win

- Seite 606 und 607:

Projektbericht Cuberunner Smart Win

- Seite 608 und 609:

Projektbericht Cuberunner Smart Win

- Seite 610 und 611:

Projektbericht Cuberunner Smart Win

- Seite 612 und 613:

Projektbericht Cuberunner Smart Win

- Seite 614 und 615:

Projektbericht Cuberunner Smart Win

- Seite 616 und 617:

Projektbericht Cuberunner Smart Win

- Seite 618 und 619:

Projektbericht Cuberunner Smart Win

- Seite 620 und 621:

Projektbericht Cuberunner Smart Win

- Seite 622 und 623:

Projektbericht Cuberunner Smart Win

- Seite 624 und 625:

Projektbericht Cuberunner Smart Win

- Seite 626 und 627:

Projektbericht Cuberunner Smart Win

- Seite 628 und 629:

Projektbericht Cuberunner Smart Win

- Seite 630 und 631:

Projektbericht Cuberunner Smart Win

- Seite 632 und 633:

Projektbericht Cuberunner Smart Win

- Seite 634 und 635:

Projektbericht Cuberunner Smart Win

- Seite 636 und 637:

Projektbericht Cuberunner Smart Win

- Seite 638 und 639:

Projektbericht Cuberunner Technisch

- Seite 640 und 641:

Projektbericht Cuberunner Technisch

- Seite 642 und 643:

Projektbericht Cuberunner Technisch

- Seite 644 und 645:

Projektbericht Cuberunner Technisch

- Seite 646 und 647:

Projektbericht Cuberunner Technisch

- Seite 648 und 649:

Projektbericht Cuberunner Technisch

- Seite 650 und 651:

Projektbericht Cuberunner Technisch

- Seite 652 und 653:

Projektbericht Cuberunner Technisch

- Seite 654 und 655:

Projektbericht Cuberunner Technisch

- Seite 656 und 657:

Projektbericht Cuberunner Technisch

- Seite 658 und 659:

Projektbericht Cuberunner Technisch

- Seite 660 und 661:

Projektbericht Cuberunner Technisch

- Seite 662 und 663:

Projektbericht Cuberunner Technisch

- Seite 664 und 665:

Projektbericht Cuberunner Technisch

- Seite 666 und 667:

Projektbericht Cuberunner Technisch

- Seite 668 und 669:

Projektbericht Cuberunner Technisch

- Seite 670 und 671:

Projektbericht Cuberunner Technisch

- Seite 672 und 673:

Projektbericht Cuberunner Technisch

- Seite 674 und 675:

Projektgruppe Cuberunner Fazit Proj