Programação Linear (e rudimentos de otimização não-linear)

Programação Linear (e rudimentos de otimização não-linear)

Programação Linear (e rudimentos de otimização não-linear)

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

notas <strong>de</strong> aula – versão 64 - Jerônimo C. Pellegrini<br />

9.5. VARIANTES DE MDPS 139<br />

A equação <strong>de</strong> otimalida<strong>de</strong> para SMDPs é mostrada a seguir. Com ela<br />

po<strong>de</strong>mos usar programação dinâmica na solução <strong>de</strong>stes problemas.<br />

V k (s) = max<br />

a<br />

[<br />

R(s, a) + ∑ s ′ m(s ′ , s, a)V k+1 (s ′ )<br />

Diversos outros métodos para solução <strong>de</strong> MDPs também funcionam<br />

para SMDPs, inclusive a formulação como programa <strong>linear</strong>.<br />

9.5.2 Parâmetros imprecisos<br />

Suponha que alguns dos parâmetros <strong>de</strong> um MDP foram especificados com<br />

imprecisão: sabemos apenas que algumas probabilida<strong>de</strong>s <strong>de</strong> transição e<br />

valores <strong>de</strong> recompensa estão situados em <strong>de</strong>terminados intervalos. Um<br />

MDP especificado <strong>de</strong>sta forma é chamado <strong>de</strong> “MDP com parâmetros imprecisos”<br />

(MDPIP)<br />

9.5.3 Observabilida<strong>de</strong> parcial<br />

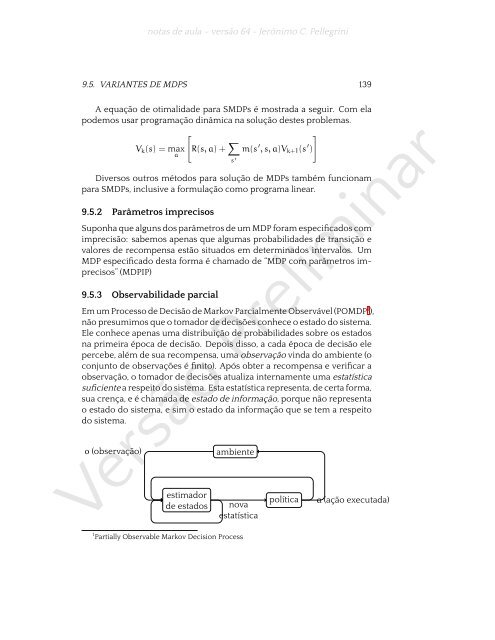

Em um Processo <strong>de</strong> Decisão <strong>de</strong> Markov Parcialmente Observável (POMDP 1 ),<br />

não presumimos que o tomador <strong>de</strong> <strong>de</strong>cisões conhece o estado do sistema.<br />

Ele conhece apenas uma distribuição <strong>de</strong> probabilida<strong>de</strong>s sobre os estados<br />

na primeira época <strong>de</strong> <strong>de</strong>cisão. Depois disso, a cada época <strong>de</strong> <strong>de</strong>cisão ele<br />

percebe, além <strong>de</strong> sua recompensa, uma observação vinda do ambiente (o<br />

conjunto <strong>de</strong> observações é finito). Após obter a recompensa e verificar a<br />

observação, o tomador <strong>de</strong> <strong>de</strong>cisões atualiza internamente uma estatística<br />

suficiente a respeito do sistema. Esta estatística representa, <strong>de</strong> certa forma,<br />

sua crença, e é chamada <strong>de</strong> estado <strong>de</strong> informação, porque não representa<br />

o estado do sistema, e sim o estado da informação que se tem a respeito<br />

do sistema.<br />

o (observação)<br />

ambiente<br />

Versão Preliminar<br />

estimador<br />

<strong>de</strong> estados<br />

nova<br />

estatística<br />

1 Partially Observable Markov Decision Process<br />

política<br />

]<br />

a (ação executada)